ComfyUIでFLUXとSDXLを使う方法と認証モデルのダウンロード

AI画像生成の世界で人気の、SDXL(Stable Diffusion XL)とFLUXが2大人気モデル。

最近では、そこに、WANの動画生成のノードも組み込めるようになり(WANはクラウド限定で使用可能)、益々面白くなっています。

- SDXL:安定性・汎用性の高さ

- FLUX:最新技術による高精細・高解像度出力

この記事では、SDXL(Stable Diffusion XL)とFLUXを動かす方法についてまとめました。

GPUを持っていない方でも、クラウド環境(クラウドGPU)で高画質モデルを動かす事が可能ですので是非、チャレンジしてみて下さい。

クラウドGPU選び

【2025年版】クラウドGPU比較|RunPod・Colab・Paperspace・Lambda Labsの特徴と選び方 クラウドGPUのニーズと記事の目的 近年、AI生成や3Dモデル作成、機械学習の学習用途などで、高性能GPUの需要が急速に高まっています。個人のPCでは対応が難しい処理も、…

目次

SDXLとFLUXの概要・違い

| 項目 | SDXL | FLUX |

|---|---|---|

| 特徴 | 安定・汎用性、LoRA/ControlNet資産豊富 | 写実・高精細、最新表現力 |

| 必要VRAM | 12〜16GB | 20GB以上推奨 |

| 商用利用 | 可(モデル配布元ライセンス確認) | モデルによって異なる(dev版は非商用) |

| コミュニティ | 非常に活発 | 急速成長中 |

⚠ FLUXはモデルごとに利用規約が異なるため、商用利用前に必ず確認してください。

公式のライセンスページや配布元を必ず参照しましょう。

SDXLとFLUXを同時に使う

SDXLで生成 → FLUXで補正(一般的な方法)

同時使用例

- SDXLを ベースの画像生成 に使う

- 生成された画像を FLUXで後処理(補正・強調・リファイン) する

- 例:

- SDXLでキャラを作る

- FLUXでテクスチャ・色彩を調整

- 実質「SDXL = 発想/構図担当」「FLUX = 仕上げ担当」

これは Refiner的な使い方 で、今一番分かりやすい流れです。

FLUXで生成 → SDXLでリファイン

逆の流れも可能です。

- FLUXは 光・空気感・リアルな表現 が得意

- SDXLのRefinerを最後に入れることで「解像度や細部」を整える

- ただし、FLUXはまだ拡張ノードが少ないので「生成後に整える」方が実践的です。

並列的に使う(応用的)

ComfyUIの強みは「並列生成」なので、

- 同じプロンプトで SDXLとFLUXを同時に生成 → 画像比較

- 片方をベース、片方をリファレンスとして 差分学習的に使う

- ControlNetで「SDXLの構図」を使い、FLUXで「雰囲気」を使う

少し実験的な使い方です。

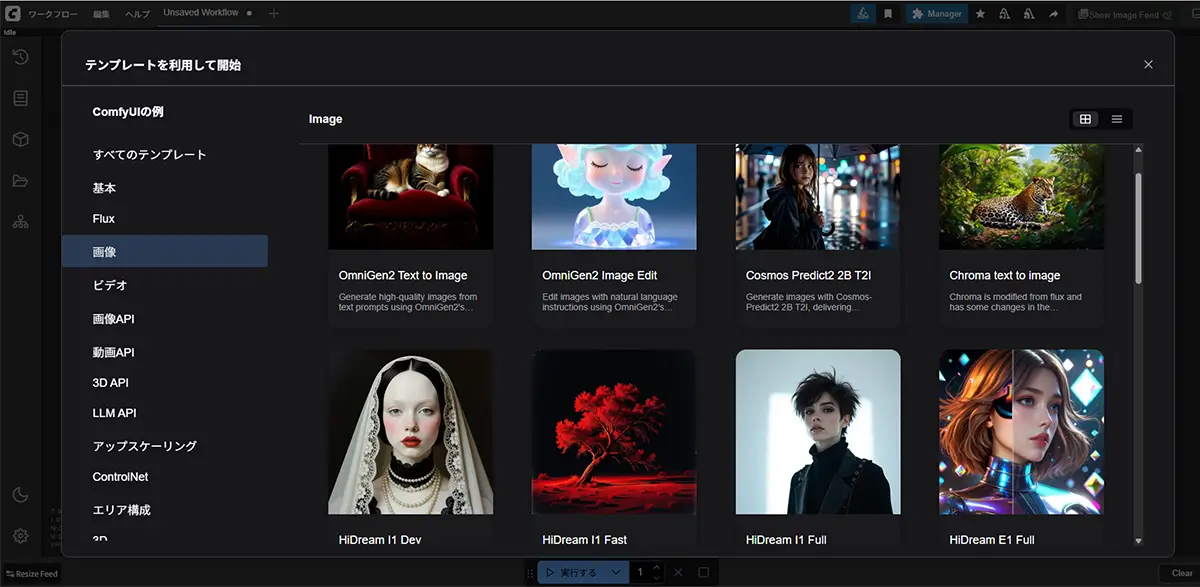

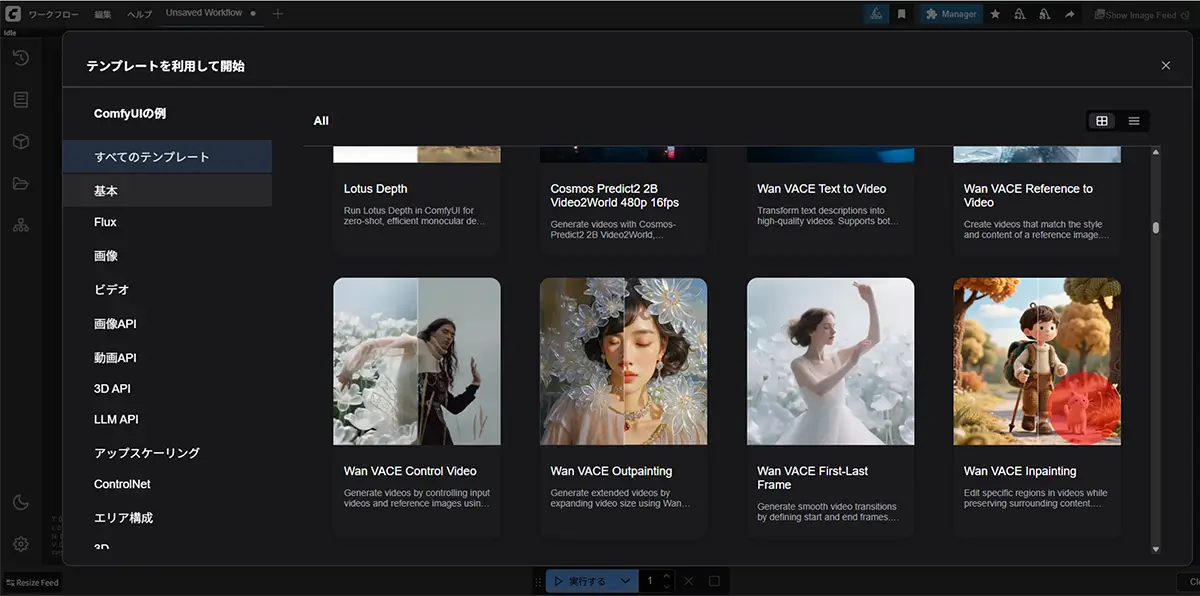

SDXL・FLUXユーザーに圧倒的人気な”ComfyUI”

テキスト→画像、画像→画像、ControlNet、LoRA、アップスケーリングなどを自由にノードで組み合わせ可能で、

SDXL・FLUXの推論フローを簡単に可視化・カスタマイズしやすい為、

2025年時点ではSDXL・FLUX推論ユーザーの多くはComfyUIを使用している様です。

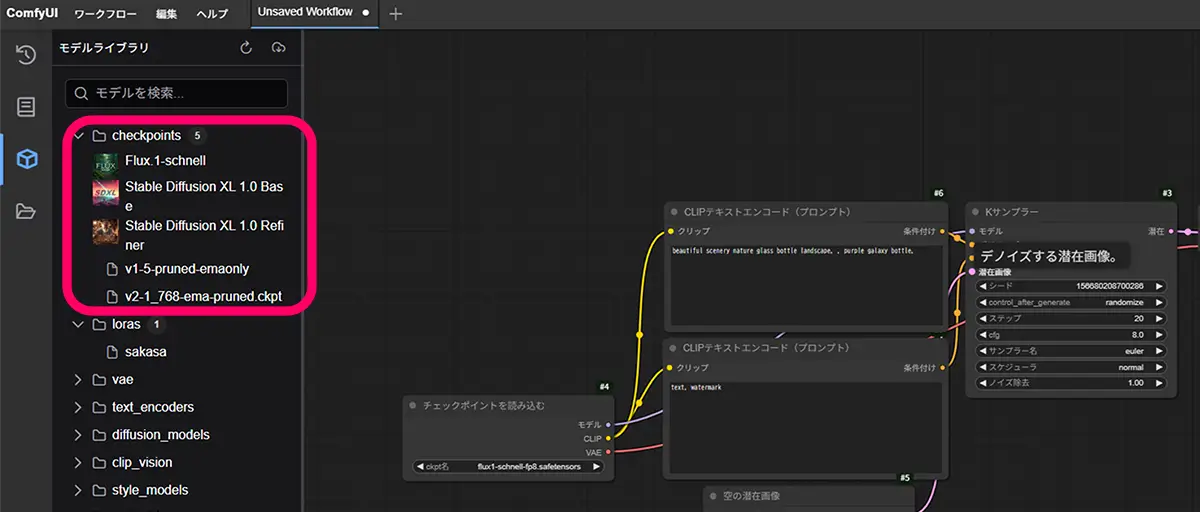

複数モデルの切り替え

- SDXL / FLUX / LoRA / ControlNetを1UI内で管理可能

- A1111やAUTOMATIC1111だと、SDXL対応は進んでいるがFLUXや複雑ノード組み合わせはComfyUIの方が扱いやすい

他UIとの比較

| UI | SDXL対応 | FLUX対応 | ノード機能 | 初心者向け | RunPodテンプレ対応 |

|---|---|---|---|---|---|

| ComfyUI | ◎ | ◎ | ◎ | △(慣れ必要) | ◎ |

| AUTOMATIC1111 | ◎ | △ | △(拡張で対応) | ◎ | △ |

| InvokeAI | ○ | × | △ | ◎ | △ |

推論で複数モデルや高機能を使いたい層はComfyUI一択になりやすい

使用傾向

- SDXL単体ならA1111ユーザーも多い

- SDXL+FLUX+ControlNet+LoRAを組み合わせる層 → ComfyUIが圧倒的に多い

- 動画化や複雑な生成パイプラインもComfyUI中心

必要環境

- SDXL

- GPU:RTX 3060(12GB VRAM)以上推奨

- FLUX

- GPU:RTX 4090 / RTX A6000(24GB〜48GB VRAM)推奨

- OS:Windows 10/11 または Linux

- ストレージ:モデルデータ保存用に30GB以上

【ローカル】の場合のComfyUIでの使用手順

最も使い勝手の良いComfyUIのインストールと使用方法の流れ

SAKASA AI

ComfyUIとは?Stable Diffusion 各モデルの特徴・用途・対応ツールのインストールと使い方 | SAKASA AI ComfyUIの使い方 Stable Diffusionの代表的WebUI「AUTOMATIC1111」に続き、InvokeAIやForgeも人気が急上昇。しかし、最も高機能なツールとして注目されるのは、自由自在に…

- Pythonと必要な依存ライブラリをインストール

- ComfyUIをクローン

- モデル(SDXLまたはFLUX)をダウンロードして

models/checkpointsに配置 python main.pyで起動- Web UIでプロンプト入力→生成

⚠ ローカルでのFLUX推論はVRAM不足エラーが出やすいため、低解像度生成→アップスケーリングの手順が有効です。

クラウドで動かす方法

現在はComfyUIが使用できるクラウド環境は、

- ComfyUIの公式ページ https://cloud.comfy.org/

- Google Colabや、RunpodなどのクラウドGPU

- RunDiffusionなどのプラットフォーム

※クラウドのGPUで画像生成を使用する際、有力な選択肢として、Google Colabを選択する事も可能ですが、Google Colabは、セッション時間制限があるため、SDXLやFLUXでの長時間高解像度生成や動画生成には不向きな上、LoRA学習や長時間バッチ生成も、Pro/Pro+でさえ途中でセッションが切れる可能性もある為、注意が必要です。

- 無料枠:短時間利用向け(SDXLは可能、FLUXはVRAM不足で制限あり)

- Pro枠:A100 GPUでVRAM 40GB使用可(FLUX推奨)

Colab Pro / Pro+ の制約(2025年時点)

| 項目 | Pro | Pro+ |

|---|---|---|

| GPU種類 | T4 / P100 / V100 / A100 | A100中心 |

| 連続実行時間 | 数時間〜最大12時間程度 | 数時間〜最大24時間程 |

| セッション切断 | 負荷や接続状態で切断あり | 同上 |

| 再接続 | 可能だが、RAM / GPUの状態はリセット | 同上 |

| 使用量制限 | 月間使用時間の目安あり | 多め |

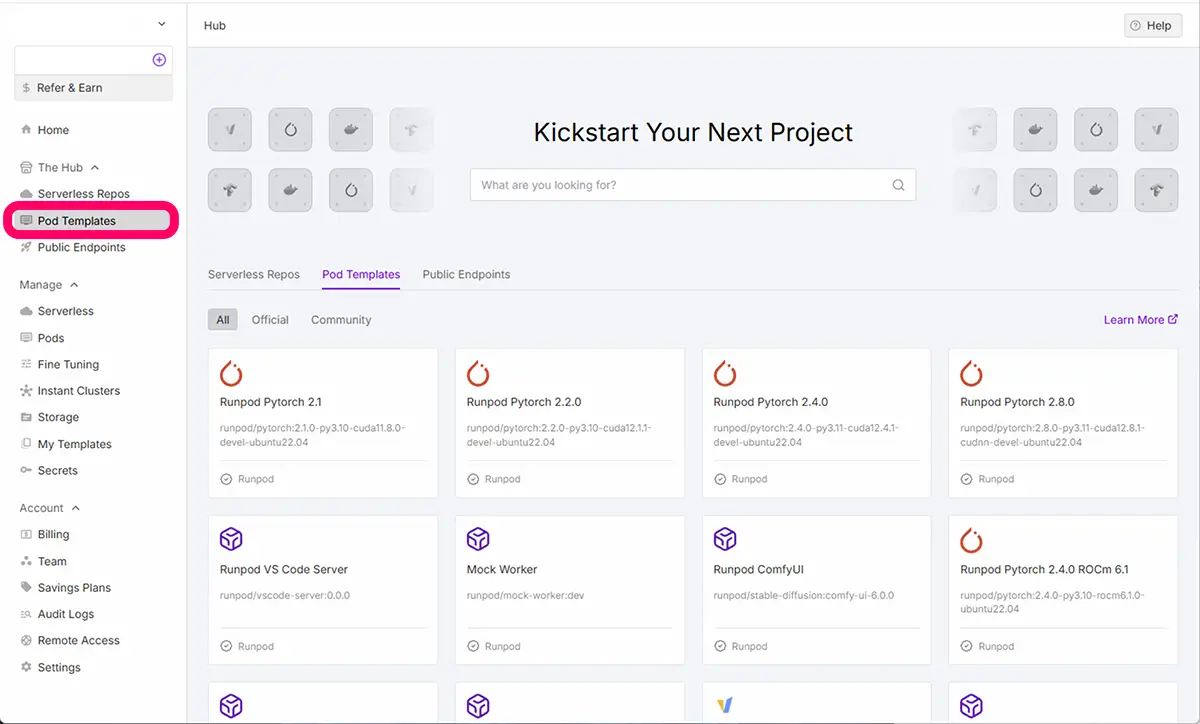

RunPodで使用する方法

RunpodにログインしてPod TemplatesでRunPod公式のComfyUI対応テンプレートを選択すると安価で使用する事が出来ます。

- 設定不要で最新モデルを動かせるため初心者もハードル低いです。

今回お薦めなのは、RunPodのテンプレート、ComfyUI + Flux.1-devです。

このテンプレートは、上記の【ローカル】の場合のComfyUIでの使用手順で述べた”1から5の手順”の内、

3.モデル(SDXLまたはFLUX)をダウンロードしてmodels/checkpointsに配置のみは自身で行う必要がありますが、その他の工程は、

”テンプレートを選択後、GPUを選択して実行するだけで使用環境が整う点が魅力です。

アカウントをお持ちでない場合はRunPod公式サイトでのアカウント作成方法についてこちらの記事で書いています。

あわせて読みたい

【RunPodの料金と使い方】Stable Diffusionなどで画像生成やLoRA学習をする方法【②実践編】 RunpodでStable Diffusion系画像生成やLoRA学習をする方法 Stable DiffusionやLoRA学習では、長時間GPUをフル稼働させるため、発熱や電源の安定性が大きな課題になりま…

【Runpod】テンプレート「ComfyUI without Flux.1-dev one-click」の使用方法は以下のページで書いています。

SAKASA AI

404: ページが見つかりませんでした | SAKASA AI AIを活用したクリエイティブの可能性を探るサイトです。初心者にも分かりやすく生成AI技術、専門用語をツールの使い方を解説しています。画像生成をメインに、WEB、PCに関…

RunDiffusionで使用する方法

RUNNITにログインして、RunDiffusion内で、ComfyUIのテンプレートを選択すると使用する事が出来ます。

未来

未来RUNNIT / RunDiffusionからも簡単に使えます

RunpodとRunDiffusionで迷ったらこちらの記事を参考にして下さいどっちが良い? RunPod と RunDiffusion の使い分けガイド

認証モデルのダウンロード

Hugging Face 側の制限

ライセンス同意や規約承諾が必要なモデルは、ユーザーごとのトークン認証が必須。(例:FLUX, 一部のSDXL系, 特殊LoRAなど)

モデルのダウンロードの方法は、通常HuggingFaceからワンクリックで行えますが、

Fluxや一部のSDXL系は、Hugging Face の「認証が必要なモデル」です。

ダウンロード時に認証が必要

対話式ログイン or 環境変数ログインを通す必要がある。

① HuggingFaceでトークンを発行する

②モデルページにアクセス → 利用規約を読む → 同意する

③そのアカウントのアクセストークンを使うとDL可能になる

‣対話式ログイン (huggingface-cli login)

‣環境変数 (HF_TOKEN=...)

HuggingFaceでのトークンを発行する

HuggingFaceでのトークンの発行方法についてはこちらの記事をご覧ください。

SAKASA AI

HuggingFaceでのトークンの種類と発行方法 | SAKASA AI HuggingFaceでのトークン発行 https://huggingface.co/settings/tokens 「Write」権限(読み込みだけなら「Read」でも可)のトークンを発行 コピーしておく モデルのダウ…

ダウンロード方法

huggingfaceとCivitai モデルの【直リンク(ダウンロード)方法】と【wget の使い方】 Modelの”直DL”のやり方 Hugging Faceの場合 直リンクの探し方 モデルページを開く(例: https://huggingface.co/runwayml/stable-diffusion-v1-5) 「Files and version…

モデルのダウンロード

モデルをダウンロードする(例)FLUX.1-dev のダウンロード

FLUXの著作権・利用制限を確認してダウンロード

モデルは、CivitAIや、HuggingFaceなどからダウンロードします。

Stable Diffusion XL (SDXL 系)

- 公式モデル(ベース)

stabilityai/stable-diffusion-xl-base-1.0

stabilityai/stable-diffusion-xl-refiner-1.0- SDXLは「ベースモデル+リファイナー」の2段階構成が推奨。

- イラストから写真までバランスよく生成可能。

- 人気の派生モデル

- Juggernaut XL(商用利用OK・万能)

- RealVisXL(リアル寄り)

- DreamShaper XL(イラスト&アニメ向き)

- AiWise / BetterThanWords-merged-SDXL-LoRA-v3

おすすめ用途:イラスト・二次創作・LINEスタンプなど幅広く。

LoRA資産が圧倒的に豊富 なので拡張性が高い。

FLUX 系(最新)

- 公式モデル(Black Forest Labs)

black-forest-labs/FLUX.1-dev

black-forest-labs/FLUX.1-schnell

[black-forest-labs/FLUX.1-pro](商用有料)- schnell → 軽量&高速。お試しに最適。

- dev → 高品質。LoRA学習もこのモデルが中心。

- pro → 有料サブスク。商用案件なら最強。

- Keltezaa / natalie-portman-sdxl-flux

スタイル:高品質なスタジオ風ポートレート。

特徴:リアルな写真の質感と洗練された構図を再現しやすいモデル。

おすすめ用途:リアル系、最新技術で高解像度・高精度の絵を作りたい場合。

LoRA資産はまだ少ない。

自動で全部ダウンロード

git lfs install

git clone https://huggingface.co/black-forest-labs/FLUX.1-devgit cloneするときに、git lfs管理対象の大容量ファイルも 自動で全部ダウンロードされる。- そのリポジトリに含まれる

.safetensorsも.binもlfs対象なら全取得。 - メリット → 追加コマンド不要で、clone した時点で全部揃う。

- デメリット → 巨大モデルだと数GB〜数十GB落ちるため時間も容量も食う。

必要なファイルだけダウンロード

git lfs install

GIT_LFS_SKIP_SMUDGE=1 git clone https://huggingface.co/black-forest-labs/FLUX.1-dev

cd FLUX.1-dev

git lfs pull --include="*.safetensors"GIT_LFS_SKIP_SMUDGE=1を付けて clone

→ この場合、大容量ファイル(.safetensorsや.bin)はダウンロードされず、ポインタファイル(メタ情報)だけが落ちる。

→ clone が高速で済む。- 必要なファイルだけ

git lfs pull --include="*.safetensors"で取得

→ 例えば.safetensorsだけ欲しい場合に効率的。

→ 他の大容量ファイル(学習ログや不要な重み)は落とさないで済む。

- 必要なファイルだけダウンロード可能(容量節約、時間短縮)。

- ストレージや帯域が限られている場合に便利。

配置するファイルを指定します。

mv flux1-dev.safetensors /workspace/ComfyUI/models/unet/(※環境によっては checkpoints/ や unet/ など指定パスが違うので確認してください。)

(例)SDXL のダウンロード(例:official base 1.0)

GIT_LFS_SKIP_SMUDGE=1 git clone https://huggingface.co/stabilityai/stable-diffusion-xl-base-1.0

cd stable-diffusion-xl-base-1.0

git lfs pull --include="*.safetensors"

mv *.safetensors /workspace/ComfyUI/models/checkpoints/

cd ..=workspace/models/checkpointsにモデルファイルをアップロード

ComfyUI の場合

- FLUX →

models/unet/ - SDXL →

models/checkpoints/

に置くのが一般的です。

あわせて読みたい

black-forest-labs/FLUX.1-Kontext-dev at main We’re on a journey to advance and democratize artificial intelligence through open source and open science.

SDXLとFLUXを同時に使う方法

同時使用の目的

SDXL と FLUX の得意分野を生かす

- SDXL

- 学習資源が豊富(LoRA / LoCon が大量)

- 緻密なディテールや特定キャラ再現に強い

- 高解像度のアップスケール系ワークフローが充実

- FLUX

- 構図・ポーズ・顔の補正が自然

- フォトリアルや自然なライティングが得意

- “編集系”(角度補正、表情変更など)で強い

同時運用の方法(ComfyUI)

- 初期生成を SDXL、補正を FLUX

- まず SDXL で LoRA を活用してキャラ固有の絵柄や衣装を生成FLUX に img2img で渡し、顔の角度補正や自然さをアップ

- 二段階高画質化

- SDXL → フィニッシュに FLUXSDXL で高解像度リサイズ(例:1024→2048)

高い VRAM(例:RunPod の A6000, H100) 環境があれば、1ワークフロー内で切り替えも可能。

軽量な環境 かつ効率重視なら、ワークフローを分割して処理する方が効率的。

実務上のポイント

- ComfyUIなら同時運用が簡単

- SDXLとFLUXを1UIでロードしてノード構成に組み込める

- LoRAやControlNetも両方のモデルで使い回せる

- RunPodでの利点

- 高VRAM GPUを使えば、SDXLとFLUX両方を同時にロードして推論可能

- ローカルPCではFLUXの高VRAM要求で同時使用が難しいこともあるので注意。

推論・生成を実行

- FLUX → より新しく、リアル寄り・構造的な表現が強い

- SDXL → 安定したクオリティ、イラスト表現やLoRA資産が豊富

ComfyUIの使用方法についてはこちらの記事をご覧ください。

あわせて読みたい

ComfyUIとは?Stable Diffusion 各モデルの特徴・用途・対応ツールのインストールと使い方 ComfyUIの使い方 Stable Diffusionの代表的WebUI「AUTOMATIC1111」に続き、InvokeAIやForgeも人気が急上昇。しかし、最も高機能なツールとして注目されるのは、自由自在…

高画質化のコツ

SDXL向け

CFG Scale: 7〜9- 解像度:1024×1024以上

- LoRA活用で作風特化

FLUX向け

- 高解像度生成+高ステップ(30〜40)

Negative Promptで不要要素を除去- 大きめVRAMで直接高解像度生成

アップスケーリング(超解像)

- 高解像度の出力を得たい場合、直接生成するより低解像度生成→アップスケーリングが効率的

- 使用例:

- Real-ESRGAN:汎用画像用

- GFPGAN / CodeFormer:人物・顔のディテール補正

- 手順(RunPod/ローカル共通):

- 生成した画像を保存

- Real-ESRGANでアップスケーリング

- 必要に応じてGFPGANで顔補正

- メリット:

- VRAM消費を抑えつつ高解像度画像生成

- FLUXなど高解像度モデルでVRAMが足りない場合に有効

あわせて読みたい

Real-ESRGAN と GFPGANを連携させる方法とGUIで使えるツール Real-ESRGAN と GFPGAN Real-ESRGAN(リアル・イーエスアールガン)と GFPGAN (ジーエフピーガン)は、インストール手順や使い方が、かなり似ています。両方とも Tence…

あわせて読みたい

【GFPGANのインストール方法と使い方】と【Automatic1111で使用する方法】 GFPGANとは? GFPGAN(Generative Facial Prior GAN)は、顔画像に特化した、顔復元のためのツールです。リアルな仕上がりで古い写真の再生に最適なツールです。顔以外の…

あわせて読みたい

【CodeFormerの使い方】3通りの方法 3通りの使い方 CodeFormerとは? 顔の復元・補完・高画質化に特化したAIツールです。主に次のような用途に向いています ぼやけた顔写真を鮮明にしたいとき AI生成画像の…

ControlNetの活用

- 元画像や線画を元に特定のポーズや構図を保持して生成できる

- 使用例:

- 元イラストのポーズを維持して別の作風に変換

- 背景だけ置き換え、キャラクターは維持

- 使い方(A1111 / ComfyUI):

- ControlNetモデルをダウンロード(HED / Canny / OpenPoseなど)

- WebUIで「ControlNet」タブを選択

- 入力画像を指定、生成条件を設定

- SDXL/FLUXで推論

注意点

- SDXL専用のControlNet(v1.1やv1.2など)もあるので、Flux側のSDバージョンと合わせるとより安定

⚠ ControlNetはVRAMを追加で消費するので、FLUXで高解像度出力する場合はクラウドGPU推奨です

あわせて読みたい

【ControlNetの使い方】完全ガイド|線画・ポーズ・輪郭で思い通りに画像生成する方法 ControlNetは、「拡張機能・追加機能」です。ControlNet自体はStable Diffusionに、条件(姿勢・線画・輪郭など)を与えて画像生成をコントロールするためのモデルや技…

注意点

- FLUXの利用規約を必ず確認

- クラウド利用時は生成量と時間でコスト管理

- モデル配布元がライセンスなどを更新する場合があるので最新情報をチェックしましょう

まとめ

- ローカル派:GPUが十分なら安定運用可

- クラウド派:RunPodでVRAM制限を突破できる

- SDXLとFLUXを使い分けることで、幅広い生成スタイルを実現可能

SAKASA AI

【保存版】ComfyUIが急に動かない原因はこれだった!ローカル環境の落とし穴と、クラウドで一発解決できる… ComfyUIが急に動かない?起動エラーの本当の原因を、ローカル環境の依存関係・CUDA衝突まで徹底解説。DockerやRunPodで一発解決する方法も詳しくまとめています。