RunPod×Kohya_ss GUI|GPU非対応の原因・互換表まとめ【⓪基礎 2.GPU編】

RunPodでKohya_ss guiが動かない?原因はGPU非対応かも!

RunPod公式サイト |お友達紹介特典付きリンク

こちらのリンクからサインアップすると、 5~500ドルの1回限りのクレジットが付与され、初回入金時に10ドルが追加されます。

こちらのリンクからサインアップすると、 5~500ドルの1回限りのクレジットが付与され、初回入金時に10ドルが追加されます。

Runpod

Runpod | The cloud built for AI GPU cloud computing made simple. Build, train, and deploy AI faster. Pay only for what you use, billed by the millisecond.

未来

未来Kohya_ssは学習に特化してる分、ちょっとGPUとの相性がシビアかも…。GPUエラーが多めのツールだよね。

SAKASA

SAKASA今回は少しややこしい、RunPodで使えるGPUの選び方について見ていこう。

RunPodのテンプレートを使用する場合のクラウドGPU選びには、押さえておきたいちょっとしたポイントがあります。

Kohya_ssやPyTorchはCUDAバージョンとの互換性が非常に重要で、これがズレていると起動エラーや学習中のクラッシュにつながります。さらに、テンプレート内で使用しているDockerイメージが実際のGPUやCUDA環境と合っていないケースもあり、これが原因で動作しないこともあります。

RunPodのテンプレートや自作環境を使う場合は、GPUに合ったCUDAバージョンとPyTorchの組み合わせをしっかり確認することが重要です。

特に、RTX 5090はもちろん、RTX 4090やRTX 5000 Ada世代などの最新GPUでは、PyTorch 2.1以上が前提となっており、古いテンプレートや環境だとKohya_ssが正常に動作しないことがあります。

GPUは日々進化していますが、ツールやライブラリの対応が追いついていない場合があるため注意が必要です。

本記事では、これらの確認方法と、テンプレート内部で使われているPyTorchのバージョンに対する対応GPUの見分け方について解説します。

そして、そもそも、この様な面倒な依存関係について考えたくない方は、それ相応のテンプレートを使用する事が、最短最良の方法となります。

SAKASA AI

【RunPod×Kohya_ssテンプレート】LoRA学習とWD14・BLIP2キャプション生成解説|最新版 | SAKASA AI キャプション生成からLoRA学習まで1Podで完結させる 本記事では、クラウドGPUのRunPod内で、 WD14”と、モデルダウンローダーが組み込まれた”Kohya_ss”のテンプレートを使用…

目次

テンプレート環境の確認方法

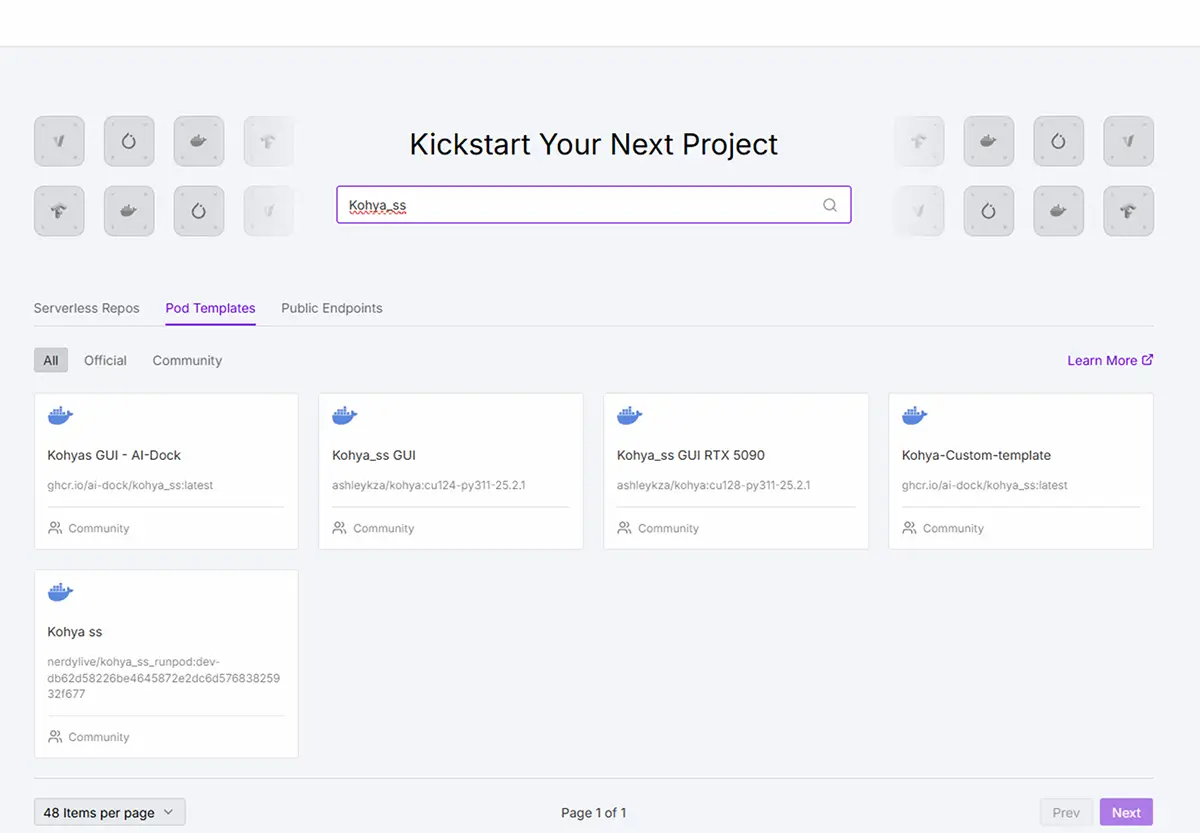

RunPod画面の左側のタブのExploreから、Explore Runpod Templatesを開き、Kohya_ssを絞り出します。

(今回は、特にGPU互換にシビアなKohya_ssで解説していきますが、他のツールにおいても同様です。)

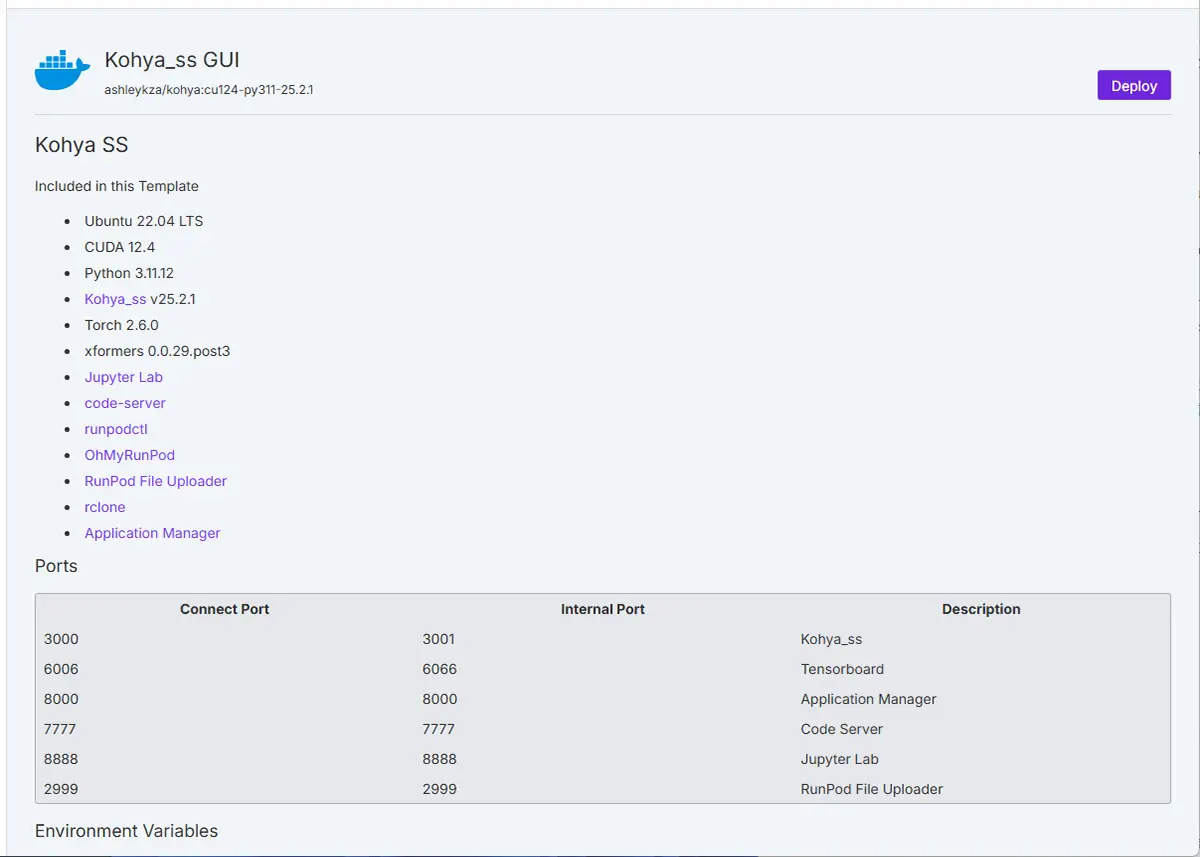

RunPodのTemplate内の各テンプレートをクリックすると概要(README)ページが開きます。

未来

未来もちろん、Kohya_ssでなくても対応GPUの確認方法は同じです。

※最近、以下のような画面に変更になりましたので追記です。

Exploreを選択➡検索窓で絞り込み➡テンプレートの種類(Official or Community)を選択できるようになりました。

今回は、Kohya_ss GUIを例に見ていきます。

このテンプレートは、Ubuntu 22.04 LTS環境に CUDA 12.4、Python 3.11.12 を組み合わせた構成で動作すると明記してあります。

CUDA 12.4 に対応したPyTorchのバージョンを使うことで、RTX 40シリーズなどのGPUが安定して動作しますが、逆にCUDAやPyTorchのバージョンが合わないと、学習が始まらなかったりエラーが発生する原因となります。

テンプレートを利用する際は、自分が選んだGPUに合ったCUDAバージョンが使われているか、PyTorchのバージョンは適切かを確認することが快適な学習環境の第一歩です。

起動が思うようにいかない時は、Podsの再起動と同時にGPUの変更をすることで、スムーズに行く事が多いです。

このテンプレートに適したGPUは?

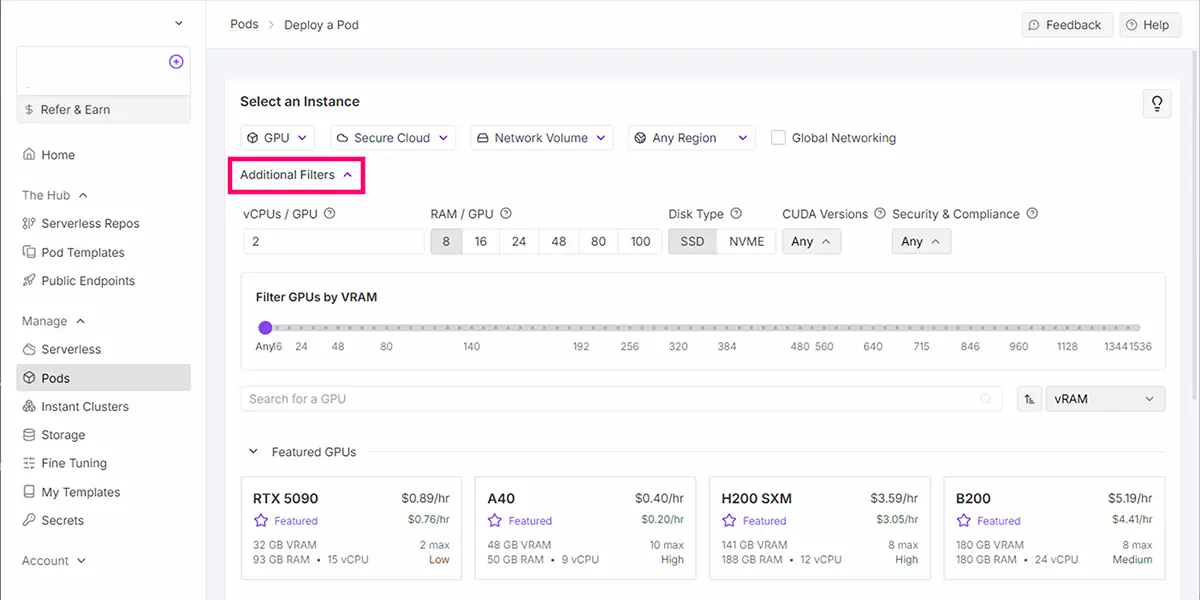

基本的には、Runpod内のCUDAのバージョンフィルター機能 Additional Filtersを使用します。

最近のGPU(RTX 4090など)は、CUDA 11.8イメージも12.1イメージも動きます(下位互換)

その為、フィルターは無視して、利用可能なGPUをそのまま使ってもよいようです。

STEP

「Additional Filters」ボタンをクリック

STEP

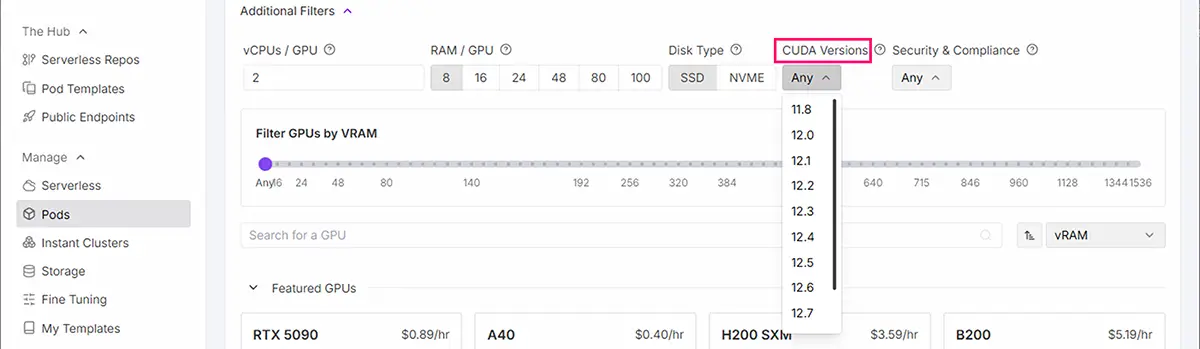

「CUDA Versions」ドロップダウンを選択

STEP

必要なCUDAバージョンを選択

STEP

互換性のあるGPUのみが表示される

ドライバー互換性の問題を自動的に解決

テンプレートに必要なCUDAバージョンと互換性のあるGPUのみ表示

「CUDA 12.4」が使われている場合、対応するGPUは比較的新しい世代に限られます。特に以下のGPUは テンプレート(CUDA 12.4)との互換性が高く、実運用でも安定して動作する構成 です。

| GPU名 | 対応CUDAバージョン | 備考 |

|---|---|---|

| RTX 3090 | CUDA 11.1 – 11.8 | PyTorch 2.0系と相性良好。VRAMも24GBありLoRA向き。 |

| RTX A6000 | CUDA 11.0 – 12.1 | VRAM 48GBクラス。商用LoRA学習にも最適。 |

| RTX 4080 / 4090 | CUDA 12.0 – 12.3 | PyTorch 2.1以降が望ましい。テンプレやDockerが未対応のことも。 |

| RTX 5000 Ada | CUDA 12.2 | Kohya_ssテンプレがCUDA 12対応でないとエラーになる可能性。 |

| NVIDIA T4 | CUDA 10.2 – 11.8 | 安価&軽量。8GB VRAMでLoRA学習向けだが制限あり。 |

| NVIDIA L40 | CUDA 12.0 – 12.4 | Ada世代。RTX 4090に近い性能+安定性。VRAM 24~48GBあり。 |

| H100 NVL | CUDA 12.1 – 12.4+ | ◎ 最上位。PyTorch 2.2以降が推奨。性能は圧倒的だが高コスト。 |

| H100 SXM / PCIe | CUDA 12.1 – 12.4+ | ◎ Kohya_ssテンプレがCUDA 12.4準拠なら安定。超高性能&高額。 |

| RTX 5090 | CUDA 12.8以降のみ対応 | PyTorch nightly(cu128)が必須。テンプレ未対応が多く注意。環境構築に手間がかかる。 |

…テンプレと高相性、条件付き対応。PyTorchやDocker調整が必要、軽量構成で可。ただし性能制限あり、◎ …高性能だがコスト高。環境構築は上級者向け

このテンプレートで確実に動かしたいならL40 または H100系(NVL / SXM / PCIe) を選びます。

ただし、H100系は料金が非常に高いことが多いため、コストと相談しながらL40で十分なケースも多いでしょう。

⚠ 注意点

- RTX 4090 や RTX 5000 Ada はCUDA 12.0~12.2あたりまでの対応が主で、「CUDA 12.4」ではテンプレートやDocker環境とのズレで動作不良のケースもあります。

- T4 や RTX 3090 / A6000 はCUDA 11系がメイン対応なので、このテンプレート(CUDA 12.4環境)では非対応か、エラーになる可能性が高いです。

GPU別 CUDA & PyTorch 互換対応表(2025年時点)

ここでは、よく使われるGPUとそのCUDA対応バージョンの目安をまとめました。テンプレート選びやGPU選択の参考にしてください。

| GPU名 | 対応CUDAバージョン | 適したPyTorchバージョン | 備考 |

|---|---|---|---|

| RTX 3090 | CUDA 11.1 – 11.8 | PyTorch 1.10~2.0系 | VRAM 24GB。PyTorch 2.0系と相性良くLoRA向き。Kohya_ssテンプレがCUDA 12.x前提だと非対応のことも。 |

| RTX A6000 | CUDA 11.0 – 12.1 | PyTorch 1.10~2.1系 | 商用向け。VRAM 48GB。Kohya_ssテンプレCUDA 12.4はギリ非対応。 |

| RTX 4080 / 4090 | CUDA 12.0 – 12.3 | PyTorch 2.1~2.2系 | CUDA 12.4テンプレは微妙に非対応のことあり。DockerやWheelsで調整が必要。 |

| RTX 5000 Ada | CUDA 12.2 | PyTorch 2.1~2.2系 | 古いテンプレではエラーになることも。 |

| NVIDIA T4 | CUDA 10.2 – 11.8 | PyTorch 1.9~2.0系 | VRAM 8GB。軽量LoRA学習向け。古いテンプレと相性良いが性能制限あり。 |

| NVIDIA L40 | CUDA 12.0 – 12.4 | PyTorch 2.1~2.3系 | 安定動作。Kohya_ss CUDA 12.4テンプレと互換性高。VRAM 24~48GB。 |

| H100 NVL | CUDA 12.1 – 12.4+ | PyTorch 2.2~2.3系 | PyTorch nightly推奨。Kohya_ss CUDA 12.4テンプレで対応。超高性能。 |

| H100 SXM / PCIe | CUDA 12.1 – 12.4+ | PyTorch 2.2~2.3系 | 高価格だが非常に高速。テンプレもCUDA 12.4以上が必要。 |

| RTX 5090 | CUDA 12.8 以降 | PyTorch nightly(cu128対応) | ドライバもバージョン57x以降必須。PyTorch公式whl /cu128 版が必要で、conda環境の手動構築が前提。現状テンプレ非対応のことも多い。 |

技術リソース(引用元)

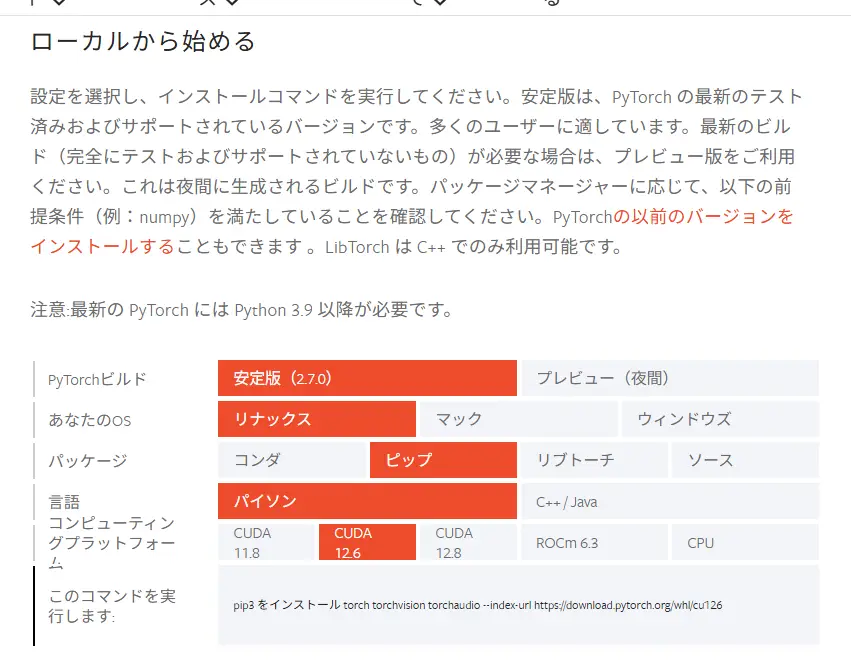

PyTorch公式のCUDAバージョン別wheel一覧

公式ページはこちら https://pytorch.org/get-started/locally/

このページでは、次のような形式でコマンドを確認できます。CUDAやPyTorchのバージョンが曖昧な場合は、PyTorch公式のバージョン互換表を参考にするのが確実です。RunPodのテンプレート説明欄でも、Python / CUDA / PyTorch の構成が記載されているので、GPU選定の前に必ずチェックしましょう。

あわせて読みたい

RunPodの【Podの見方と使い方】と【接続オプションの使い方】【⓪基礎・1.Pod編】 RunPodの大まかな使用方法、流れは こちらの記事でまとめています。 ”RunPodの使用方法と手順”については、上の記事でかなり細かくまとめたつもりでいました。しかし、…

SAKASA AI

「RunPodでのJupyterLabの使い方:workspaceとの違いも解説」【⓪基礎・3.JupyterLab編】 | SAKASA AI RunPodのテンプレート内の「Jupyter Notebook」。そもそも何のために使うのか?workspaceとの違い、GPUとの関係、画像生成で使う必要があるのか?など…初心者にもわかりや…

あわせて読みたい

【RunPodの料金と使い方】Stable Diffusionなどで画像生成やLoRA学習をする方法【②実践編】 RunpodでStable Diffusion系画像生成やLoRA学習をする方法 Stable DiffusionやLoRA学習では、長時間GPUをフル稼働させるため、発熱や電源の安定性が大きな課題になりま…

あわせて読みたい

【RunPod】で”Kohya_ss”を使用して”LoRA学習”をする方法【③応用編】 本記事では、クラウドGPUのRunPod内で、 ”Kohya_ss”のテンプレートを使用して、”LoRA学習”をする方法を解説しています。 RunPodの基本的な使用方法については、 こちら…