RunPodの【Podの見方と使い方】と【接続オプションの使い方】【⓪基礎・1.Pod編】

RunPod公式サイト |お友達紹介特典付きリンク

こちらのリンクからサインアップすると、 5~500ドルの1回限りのクレジットが付与され、初回入金時に10ドルが追加されます。

こちらのリンクからサインアップすると、 5~500ドルの1回限りのクレジットが付与され、初回入金時に10ドルが追加されます。

Runpod

Runpod | The cloud built for AI GPU cloud computing made simple. Build, train, and deploy AI faster. Pay only for what you use, billed by the millisecond.

RunPodの大まかな使用方法、流れはこちらの記事でまとめています。

”RunPodの使用方法と手順”については、上の記事でかなり細かくまとめたつもりでいました。

しかし、初めのうちは、Podの見方自体が分かりづらく感じると共に、多様な使い方が出来るRunPodは、ややこしさを感じる点も多くあると思います。

そこで、本記事では、レンタルサーバーRunPodの

”Podの見方と使用方法、そしてPod内の接続オプションの見方と使用方法”について、それからちょっとしたコツと、エラー対処方法なども加え、困ったときにいつでも見返せるようにまとめました。

目次

Pod Volume と Network Volume(Network Storage=永続ボリューム)

RunPodでPodを作成する際、画面に表示される「Disk」や「Volume」には以下のような違いがあります。

| Pod Volume | Pod内部専用ディスク領域 | ❌ 永続ではない | Podを停止・削除すると内容も消えます |

| Network Volume (永続ボリューム) | 永続的な外部ストレージ | ✅ 永続保存される | 複数のPodで共有可能/地域に注意 |

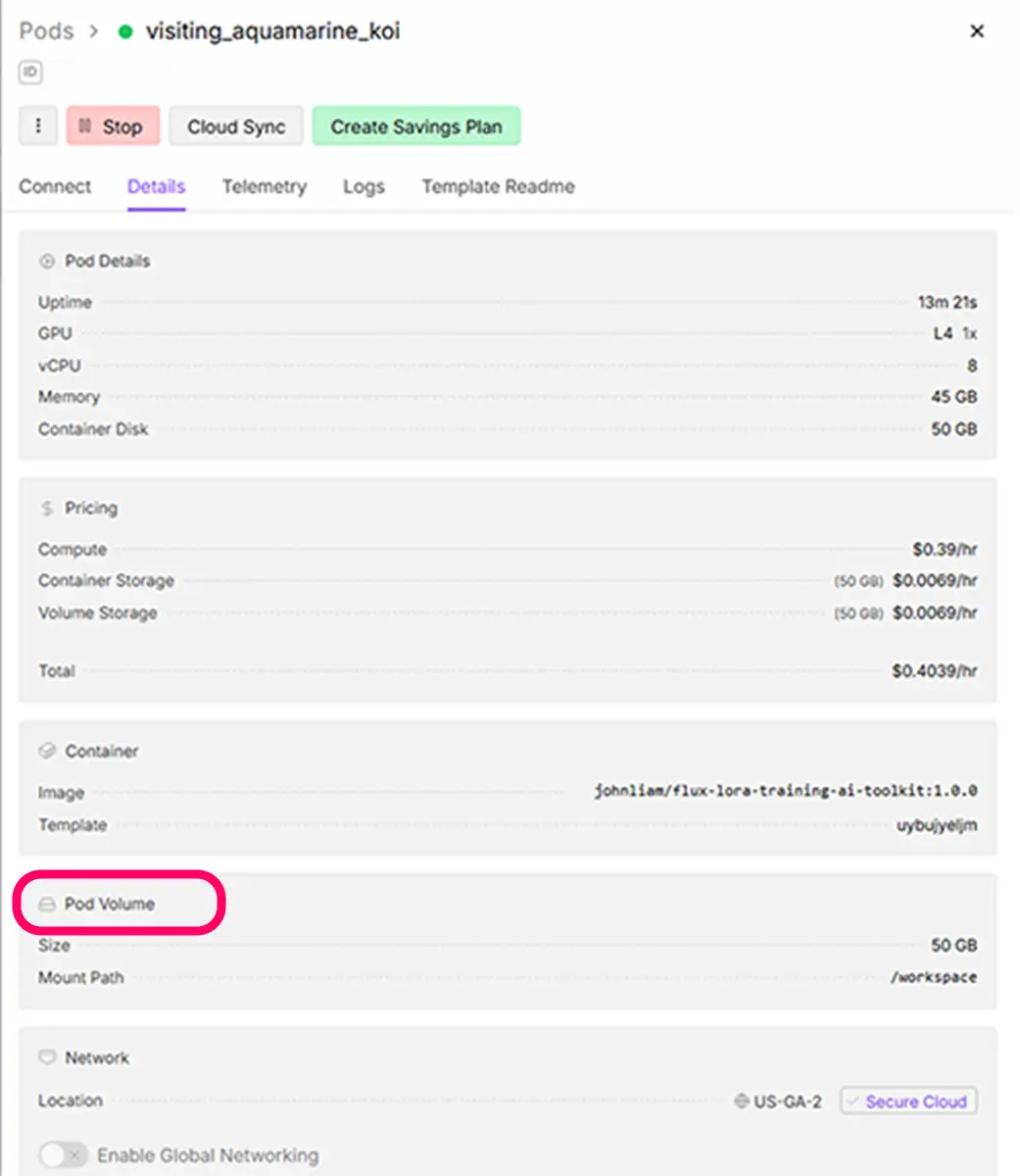

下の画像はPod内、Datailsです。

一枚目の画像では、 Pod Volumeと記載があります。

この、Pod Volumeというのは、永続的なボリュームではない場合の記載です。

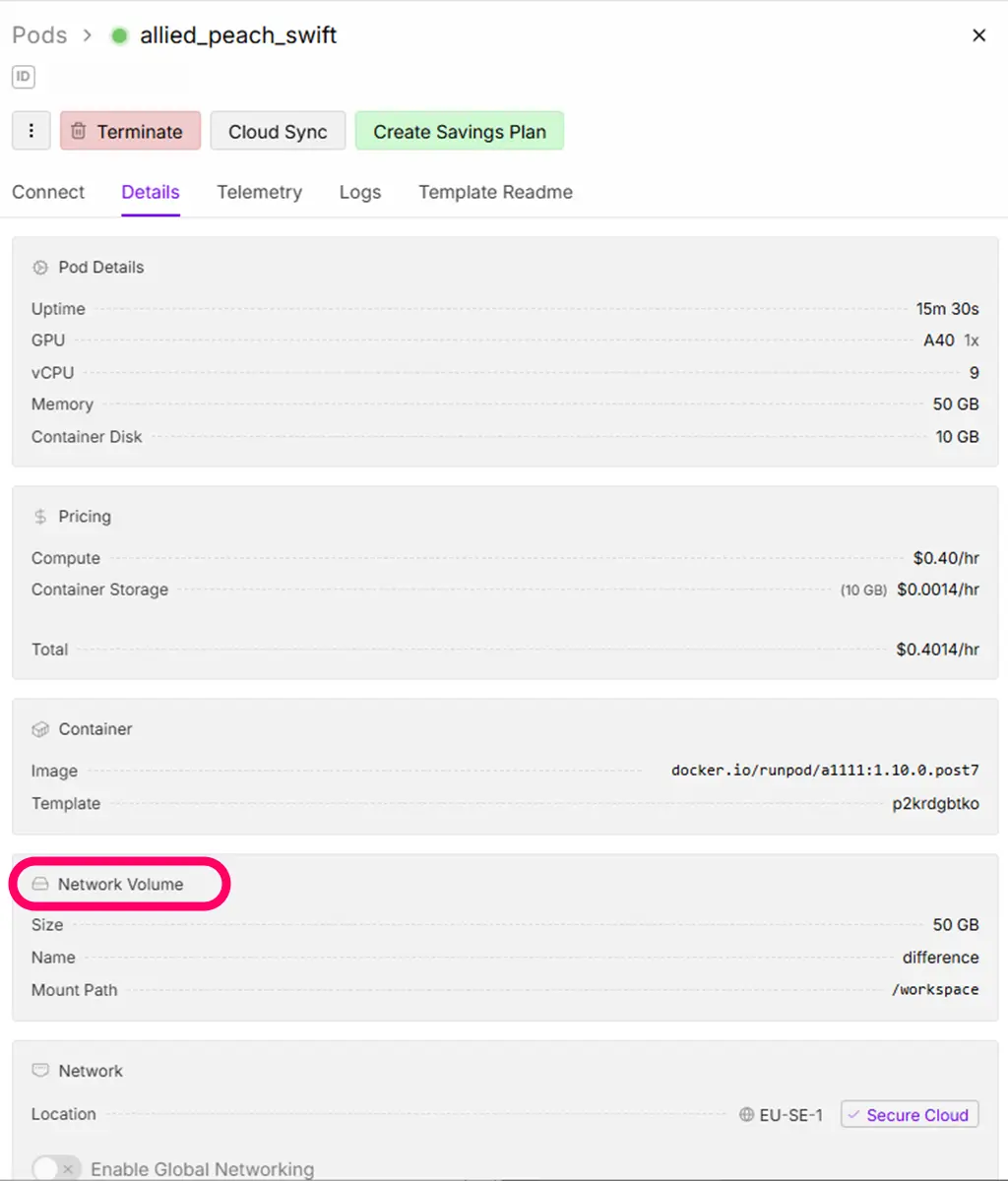

二枚目の画像では、 Network Volumeとあります。

この、Network Volumeというのが、Network Storage(永続ボリューム)使用時の記載です。

Pod作成画面に表示される「eur-is-1」や「us-west-2」といった表記は、RunPodのストレージノード(MFS)が存在する地域(リージョン)を示しています。

- PodとVolumeは同じリージョンに配置する必要があります。

- 違う地域のボリュームはマウントできません。

保存先として使えるパス

テンプレートによって異なるようですが、永続ストレージがマウントされる代表的なパスは以下の通りです。

これらのパス内のデータはPodを停止しても、保存されます。(Podを削除すると、全てのデータが消えます。)

ネットワークストレージを使用する際には、これらのパスの中にモデルファイルなどを配置していく事で次回も同じ環境下で作業が始められます。

詳細は、大抵の場合、各テンプレートのRead me内で記載があります。

/workspace(テンプレートによってはここが永続)/data(一部テンプレートで永続保存用)

Network Storage(永続ボリューム)の特徴

- Podを 停止しても削除しない限り 中身は残る

- 複数のPod間で 同じVolumeを共有できる

- 地域をまたぐと接続できないので、Podと同じリージョンを選ぶ必要あり

基本ルール:Volumeは複数のPodで共用できる

1つのVolumeを複数のPodに接続することが可能です。

※ただし、異なるテンプレートやバージョンのPodでVolumeを使い回すと、以下のような問題が発生することがあります

⚠️ Volumeを使い回すと発生しやすいトラブル

Accelerateの設定が壊れる kohya_ss では .cache/huggingface/accelerate や config_files などに自動保存された設定が、

他のバージョンのPodと競合してエラーの原因になることがあります。

WebUIが無反応になる 前のPodで生成された .toml や .json ファイルを読み込んでしまい、起動直後にUIが固まることも。

CUDA周りの設定が競合 古いテンプレートのtorch/cudaのキャッシュが残ると、対応しないGPUでクラッシュする可能性も。

SAKASA

SAKASAこの間は、気が付いたらNetworkVolumeの容量がいっぱいで モデルのDLダウンロードが途中で止まったよ!

🔁 再利用OKなケース

同じテンプレート(例:ashleykza/kohya:25.1.2)でPodを作り直すだけなら、Volumeは使い回した方がいい。

🚫 再利用しない方がよいケース

違うテンプレート(例:ComfyUIやInvokeAI)に切り替えるとき何度もエラーが起きた

Volumeを使い続けているとき(設定ファイルが壊れているかも)

Startを押しても反応しないなど明らかな異常があるとき

実際は、自作LoRAの保存、画像、プロンプトなどの資産があるなら使い回しますが、

テンプレートを変えるときは、新しいVolumeを使うのが安全です。

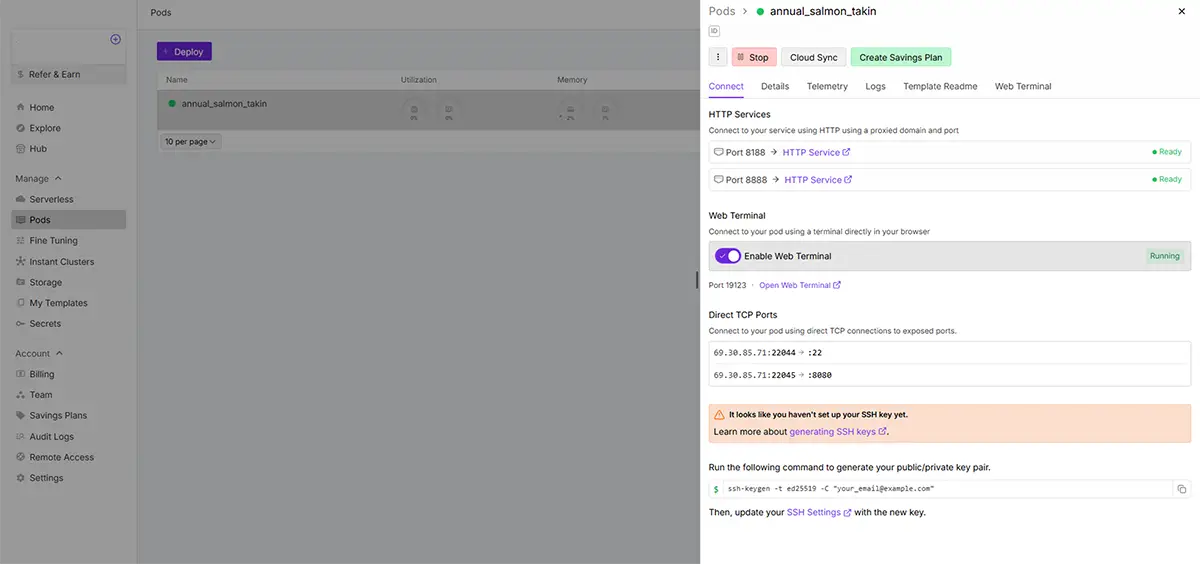

RunPodの接続オプション

RunPodでテンプレートからPodを起動した後に表示される 接続オプション(Connection Options)は、

使用するツールや操作方法によって選べる入口です。それぞれの意味を以下に整理しました。

※テンプレートによって内容は異なります。

「HTTPService → 3010」のような表記は、ツールやサービスが使っているポート番号を指しています

- RunPodでは、各Web UI(例:Kohya、ComfyUI、Stable Diffusion WebUI など)を外部アクセス可能にするために、それぞれ別のポート番号が割り当てられています。

- 例:

3010→ Kohya GUI3000→ ComfyUI7860→ WebUI(Stable Diffusion)8888→ JupyterLabなど

【起動時間の目安】

下は、起動時間の目安です。回線の込み具合などもある様ですが、体感的に、あまり遅い場合は再起動した方が良い様に思います。

| 状況 | 起動にかかる時間 | 備考 |

|---|---|---|

| 初回起動(Pod作成直後) | 1〜10分 | Dockerイメージの読み込みや初期化処理に時間がかかる |

| 2回目以降の起動(Stop → Start) | 数十秒〜5分 | キャッシュがあるため早い |

| それ以上かかる場合 | 20分以上待ってもGUIが出ない場合は異常の可能性 **※巨大モデルを含んだツールSDXLなどのモデル | フリーズやポートエラーの可能性あり |

- **巨大モデルの初回ダウンロード

- SDXL(約6GB以上)、Flux(さらに大きめ)、ControlNet追加などを初回にダウンロードすると、ストレージへ展開するのに 数十分かかることもある。

- これは「Pod起動」自体ではなく「起動後の初期セットアップ」の時間です。

- イメージのPullが必要な場合

- カスタムテンプレートや公式イメージ更新後に、Dockerイメージを引っ張ってくる処理が走ると、その分待たされます。

- ストレージ容量不足やマウント遅延

- Podが大きなボリュームをマウントする時に遅延が発生するケース。

**巨大モデルの初回ダウンロードでのコツについては、こちらで書いています。

又、意外と見落としがちな原因の一つに、GPUなどの互換性も挙げられます。

GPU選択の互換性について以下の記事の中で、詳しく書いています。

エラー対処法

PodのDeploy後、使用できる状態にならない場合に考えられる原因は、多岐にわたりますが、

まずは、Logsを確認します。

Container is READY!

が出るまでは、URL経由でアクセスは出来ません。

テンプレートの不具合の可能性

色々な考えられる可能性を排除した上で、それでもなかなかPodが立ち上がらない場合、一番多いかも知れないと思う原因が、テンプレートの不具合ではないかと思います。

ただ、一言にテンプレートの不具合とは言っても、回線の具合で変化するタイプの不具合の場合と、

全く使えない、何度試しても、メンテが止まっているなどの理由で全く使い物にならないテンプレートが存在しています。

これらについては、私も可能な限りではありますが、各ツールの解説ページや、推しテンプレート掲示板にて度々、レポを更新していますので、チェックしてください。(実際、Runpod内のテンプレートも更新が行われていますので、情報が追い付かないかも知れません。)

推しテンプレート=使えるテンプレート

推しテンプレート掲示板(随時更新) Runpodの使えるテンプレートと、使えないテンプレート Runpodのテンプレートには使えるものと、使えないものがあります。 すんなり立ち上がるテンプレートもあれば、ど…

① 現在のPodを一旦削除して再作成(クリーンスタート)

- 必要なデータは

/runpod-volumeに保存してあることを確認 - 今のPodを「Stop」→「Delete」

- もう一度、テンプレート(

ULTIMATE Stable Diffusion Kohya ComfyUI InvokeAIなど)から新しくPodを作成

② Network Volume内を整理しておく(任意)

/runpod-volume内に大量の不要ファイル(大きなモデル・画像・ログなど)があると、起動が遅くなる要因になります。logsや 一時的に使ったoutputsフォルダなどを整理しておく。

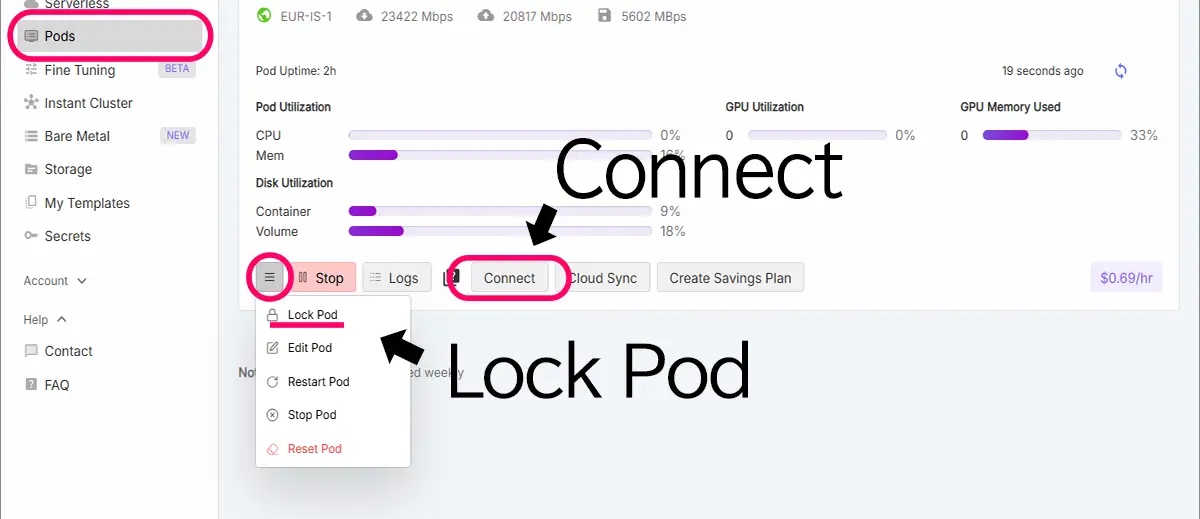

③ Lock Podしておくと次回がラク

- Pod作成後、GUIやパス、rclone設定などが整った段階で「Lock Pod」しておけば、設定済みの状態で再起動できます。

- LockしたPodを「Clone」して新しいPodを作れば、再設定の手間が最小限に。

Connect内Port

1. Web UI / App(例:ComfyUI、InvokeAIなど)

- 用途:Stable DiffusionやComfyUIなどのWebアプリケーションをブラウザ上で操作するためのUIです。

- 使い方:クリックするだけで、該当するアプリがブラウザで開きます。

- 例:

ComfyUIInvokeAIKohya SS Trainer

画像生成・LoRAトレーニングをGUIで操作したいなら、ここがメインです。

2. Jupyter Notebook

- 用途:※ファイルのアップロードやダウンロードも簡単に行えるし、ターミナルも使える。

Pythonベースでコードを書いて実行するノートブック環境。主にデータ分析やカスタムスクリプト実行向け。 - 使い方:Pythonコードをノート形式で記述・実行できます。

- LoRA学習:Jupyterを通してKohyaスクリプトを使うことも可能。

コードベースでLoRAトレーニングや自作スクリプトを動かしたい方向け。

Jupyter Notebookの使い方はこちらで解説しています。

3. SSH ターミナルアクセス

- 用途:LinuxのコマンドラインでPodにアクセスできます(シェル操作)。

- 使い方:SSHクライアントやRunPod内の「Web Terminal」で接続。

- できること:フォルダ作成、rcloneでの同期、学習スクリプトの直接実行など。

ターミナルでの細かい操作をしたいときに便利。

4. Web Terminal

- 用途:ブラウザからPodのターミナルにアクセスできる。

- 使い方:クリックで開くとLinuxコマンドが使えるターミナルが表示されます。

- 特徴:別途SSHクライアントを用意しなくてもすぐ使える。

手軽にターミナル操作したいときはこれが便利。画像整理やrcloneアップロード、

HuggingFaceからモデルを直接ダウンロードしたりも出来る。

こちらの記事で、modelの直ダウンロードの方法を解説しています。

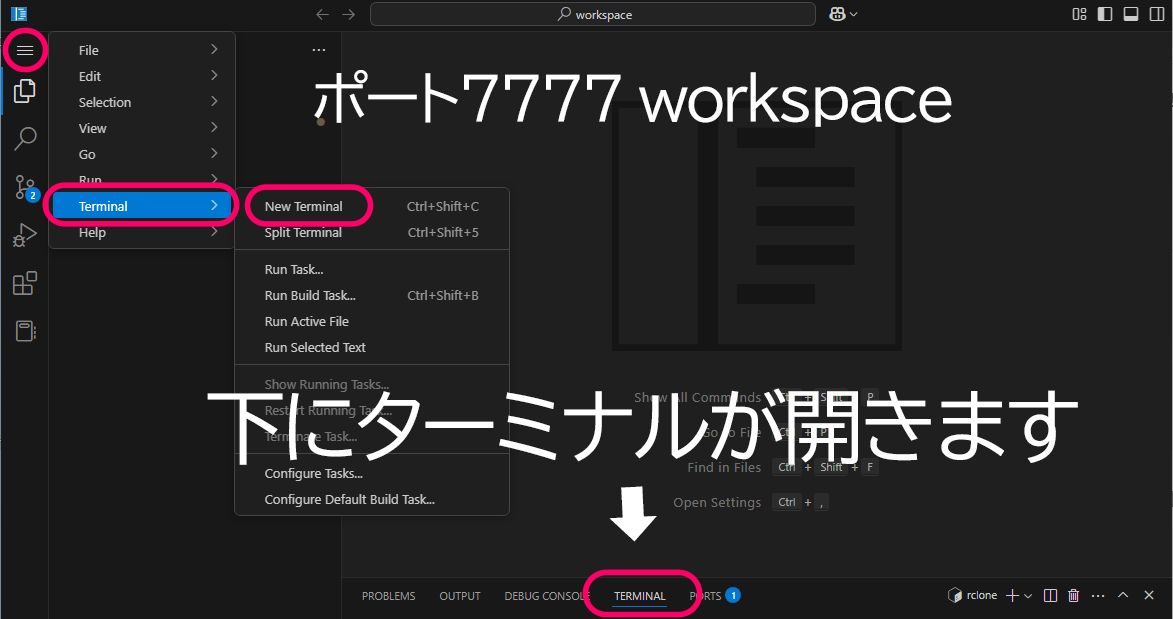

5.Workspace(ファイルマネージャー)

Workspace(https://xxxxx-7777.proxy.runpod.net/?folder=/workspace)は、あくまでファイルの整理を行うための GUI ファイルマネージャーです。

→ 学習の実行や画像生成などの「ツール起動・操作」は 別のUI(Kohya, ComfyUIなど)で行う必要があります。Workspace 上に画像をアップロードしても、それを使って学習・生成するには、該当ツールのUIに入り、パスを指定する必要があります。

| 作業内容 | 接続オプション |

|---|---|

| ComfyUIを使って画像生成 | ComfyUI(Web UI) |

| InvokeAIで生成や管理 | InvokeAI(Web UI) |

| KohyaでLoRAトレーニング | Kohya Trainer or Web Terminal |

| フォルダ作成・rcloneで同期 | Web Terminal または SSH Access |

| Pythonコードベースで処理 | Jupyter Notebook |

ファイル操作のみport 7777 | Workspace |

接続に失敗する場合の確認

- Podのステータスが “Running” になっているか確認

- ブラウザのポップアップブロックでブロックされていないか確認

そもそも重いモデルの場合でダウンロードが終わっていない可能性もあります。Logで、Readyなどと出ているか?確認。

注意点

- RunPodのPod は Dockerコンテナ 上で動いています。

RunPodの仕様はテンプレートによって違うので、

「/workspaceは一時領域」と書かれている解説もあれば、

「/workspaceが永続化されている」というテンプレートもあります。

テンプレート(Readme)を確認してください

保存コマンドの例

Jupiter Labが開ける場合は、Jupiter Labで行うのが一番簡単です。大抵のファイル操作が行えます。

JupiterLabの使用方法は、こちらで解説しています https://sakasaai.com/rp_jupyternotebook/

Web Terminalか、Jupiter notebookか、workspaceでターミナルを開く

cp -r /workspace/outputs /runpod-volume/

cp -r /workspace/models /runpod-volume/

cp -r /workspace/training_images /runpod-volume/※上記は一例です。フォルダ構成に合わせて適宜修正してください。

フォルダ名やファイルの場所が分からない場合は、

ls /workspaceなどで確認ができます。

RunPodでは、データはPodを削除すると すべて消えます。

一方 、永続ボリュームに保存されている部分は、永続ボリュームを使い回せば、次のPodでもそのまま使えます。

容量を確認し、不要なファイルを削除する方法

以下のコマンドで容量を食っているディレクトリを確認

du -h --max-depth=1 /workspace | sort -hrまたは(永続ストレージ含む場合)

du -h --max-depth=1 / | sort -hr削除の優先候補

以下のようなファイルは安全に削除できます

- 古い

.safetensorsモデル(GoogleDriveにバックアップしてあるなら) outputs/配下の古い画像や中間ファイルtraining出力先(学習失敗で空のモデルが大量にできていることがある)

例:

rm -rf /workspace/output/*

rm -rf /workspace/kohya_ss/outputs/*.safetensors容量が空いたら再起動(重要)

容量不足の状態では、GUIもPythonも正常に動かなくなる。

最終手段:Volumeごと削除&再作成(空にする)

どうしても容量を空けられない場合新しく空のVolumeを作成し、Podに接続。

1. 不要ファイル削除

2. Podを再起動RunPodのダッシュボードから該当のVolumeを削除(⚠データも消える)

.safetensors や画像などは、学習が終わるたびに GoogleDrive に rclone でバックアップし、Podから削除しておくと安心です。

必要なら、/workspace ではなく、永続ストレージ付きテンプレート(例:/runpod-volume) に切り替えることも検討を。

残っている .safetensors ファイルを調べる方法

以下のコマンドを Webターミナル で実行して、.safetensors ファイルの一覧とサイズを確認。

find /workspace -name "*.safetensors" -exec ls -lh {} \;これで、すべての .safetensors ファイルがフルパス+サイズ付きで表示されます。

不要なファイルを削除するには

たとえば、見つかったパスが /workspace/stable-diffusion-webui/models/Stable-diffusion/v1-5-pruned-emaonly (3).safetensors のようであれば、以下のように削除できます。

rm "/workspace/stable-diffusion-webui/models/Stable-diffusion/v1-5-pruned-emaonly (3).safetensors"⚠️ パスの中にスペース () などがあるときは、パスを必ずダブルクオート " で囲む。

削除後、ディスク使用量を確認

du -h -d1 /workspace | sort -hrdu コマンドで再確認(サイズ順で表示)

du -h /workspace --max-depth=2 | sort -hr | head -n 20これで /workspace フォルダ以下のサブフォルダの容量をリストで表示できます(大きい順)。何が容量を食っているのかを確認しましょう。

回線不調で起こりがちなトラブル

UI画面は立ち上がっているのに使えない場合など、環境構築には成功していて、Runnng状態の場合に考えられる原因

| 症状 | 原因 |

|---|---|

| Trainingボタンが押しても無反応 | GUIのバックエンドが回線切断で応答を失っている可能性 |

| フォルダ指定時にエラーやフリーズ | ファイルシステムとの通信エラー |

Connection errored out や Source Controlが止まる | WebSocket/HTTPSのタイムアウトや断線 |

- GUI内部でPythonプロセスがクラッシュしている

- 古いモデルやスクリプトとの競合(バージョン差)

- 永続ボリュームに不整合なファイル構成がある

対策

- RunPodのタブを更新して再接続してみる

→ GUIがリロードされて状態がリセットされます。学習はバックグラウンドで続く場合もあります。 - Webターミナル側で学習が走っているか確認

ps aux | grep train→ 何も表示されなければ、プロセスが動いていない。 - 保存した設定ファイル(.toml)を読み込み直す

→ すでに設定ファイルがある場合、GUIから「Load Config」で再読み込みできます。 - ネットワークを安定させて再度操作

→ 一時的な接続不良なら、時間を空けて操作すると改善することがあります。

一般的に安定しやすいと言われる時間帯(日本時間)

| 時間帯 | 備考 |

|---|---|

| 早朝(5:00〜8:00) | 世界的にもユーザー数が少なく、クラウド負荷が軽い時間帯 |

| 平日昼間(10:00〜13:00) | 日本国内は作業時間だが、欧米のアクセスがまだ少ない |

| 深夜(23:00〜2:00) | 一部の地域では使用が減るタイミング |

不安定になりやすいと言われる時間帯(日本時間)

| 時間帯 | 備考 |

|---|---|

| 夜(19:00〜23:00) | 日本・アジア・一部欧米が重なってアクセス集中しやすい |

| 土日・祝日の日中 | 世界的にユーザーが自由時間で使う傾向がある |

状況を知る工夫

- RunPodのステータスページや公式Discordをチェック

→ たまに「一部リージョンで不安定」などの情報が出ます。 - Podのリージョンを変える(例:

EUR-IS-1→US-CA-1)

→ 特定地域のサーバーが混んでいることもあります。

RunPod の制限に関するポイント

1. 「Auto-shutdown(自動停止)」の設定

- Pod に一定時間アクセスや処理がないと、自動的にシャットダウンする設定が可能。

- これは自分で無効にもできるが、オンになっていると学習が途中で止まることもあるらしい。

確認方法

Pod起動時の「Advanced Options」にある Auto-shutdown timeout の設定を確認(例:15分など)

2. プリペイド残高・課金が切れると停止

- RunPodは使った分だけ時間で課金されます(従量課金制)。

- クレジット残高やクレカの上限を超えると、自動的にPodが止まる。

3. Disk/Volume容量制限で処理が止まることも

- 例えば、ボリュームが 100% に達すると、保存やログ出力ができず学習が失敗。

- この場合「止まる」というより「動いてるように見えて進んでいない」という状況に。

4. RunPod 自体のメンテナンス・トラブル時の停止

- 稀にRunPodがサーバーメンテナンスや障害対応でPodが落とされることがある。

- 特にマイナーリージョン(EUR-ISなど)では発生頻度が若干高め。

未来

未来メンテナンスの際には、事前でPod内にメッセージが出ます。

あわせて読みたい

【RunPodリンクページ】活用マニュアル|使用方法から注目テンプレートまで 【2025年最新版】RunPodガイド・Stable Diffusionから”今注目のテンプレート”まで 本ページでは、RunPodの使い方や料金、具体的な活用方法などに関する記事のリンクをま…

SAKASA AI

RunPod×Kohya_ss GUI|GPU非対応の原因・互換表まとめ【⓪基礎 2.GPU編】 | SAKASA AI RunPodでKohya_ssを使ってLoRAを学習する際のポイントを初心者向けに解説!テンプレート選びや画像アップロード、WebUI操作から永続ストレージ管理まで、迷わず学べる手順…

SAKASA AI

「RunPodでのJupyterLabの使い方:workspaceとの違いも解説」【⓪基礎・3.JupyterLab編】 | SAKASA AI RunPodのテンプレート内の「Jupyter Notebook」。そもそも何のために使うのか?workspaceとの違い、GPUとの関係、画像生成で使う必要があるのか?など…初心者にもわかりや…

【①解説編】

クラウドGPU”RunPod”とは?画像生成・LoRA学習の最適解?!個人利用の効率よいクラウド環境【①解説編】 ComfyUI、Stable Diffusionなどの画像生成も使いやすい Stable Diffusionで「思う存分、画像,動画生成がしたい」「自分の作風を学習させたい」「LoRAやDreamBoothを試し…

【②実践編】

【RunPodの料金と使い方】Stable Diffusionなどで画像生成やLoRA学習をする方法【②実践編】 RunpodでStable Diffusion系画像生成やLoRA学習をする方法 Stable DiffusionやLoRA学習では、長時間GPUをフル稼働させるため、発熱や電源の安定性が大きな課題になりま…

【③応用編】

【RunPod】で”Kohya_ss”を使用して”LoRA学習”をする方法【③応用編】 本記事では、クラウドGPUのRunPod内で、 ”Kohya_ss”のテンプレートを使用して、”LoRA学習”をする方法を解説しています。 RunPodの基本的な使用方法については、 こちら…