【ローカル】【クラウド】【GUI】【CLI】画像生成AIを動かす7つの方法

画像生成AIを動かす7つの方法

私が画像生成AIを始めた頃、最初に触ったのは Hugging Face の Spaces 上で動く Stable Diffusion(Automatic1111系のツール) でした。

そのとき「【ローカル】と【クラウド】という使い方がある」と知ったものの、正直なところピンときませんでした。

なぜなら、当時の私にとって「クラウド=ネット上のアプリを使う感覚」でしかなく、

同じGUIがローカルとクラウドの両方で動くということがすぐには理解できなかったからです。

さらに混乱したのが【GUI】と【CLI】の違いです。

「画像生成なのにUI画面が無い?」「生成された画像はどこに出てくるの?」と、なぜ?どうして?の連続でした。

そこで本記事では、当時の自分に向けて「画像生成AIを動かす7つの方法」を整理しました。

「どんな種類の使い方があるのか?」「結局どれを選べばいいのか?」と迷っている方に、ぜひ読んでいただきたい内容です。

目次

AI画像生成の方法

画像生成の方法には、GUI(グラフィカルユーザーインターフェース)とCLI(コマンドラインインターフェース)があり、

それぞれローカルもしくは、クラウドで操作する方法があります。

※GUIと、CLIとは、コンピュータやツールとユーザーがやりとりする方法の違いを表す基本的な分類です。

GUIとは?

Graphical User Interface=GUIは、画面を見ながらマウスで操作する方法です。

ブラウザでアイコンやボタンを使って表示・操作ができ、視覚的にわかりやすいのが特徴です。

開発向け・自動化には、不向きなことが多いです。

例: Windowsのデスクトップ、iPhoneのアプリ画面、Photoshop、AUTOMATIC1111のWeb画面などの事を指す。

初心者でも直感的に使える

操作の自由度は少ないが、やさしいのが特徴です。

CLIとは?

Command Line Interface=CLIは、ユーザーが文字ベースのコマンドで操作するインターフェースです。

対話的に操作するGUIとは対照的に、コマンドを文字で入力して操作します。(黒い画面で操作)

コマンドの知識が必要ですが、開発向け・自動化が得意です。

最近は、Ollama / Gemma3が、会話しながら画像生成も可能になったと話題になっています。

柔軟で高速で、GUIではできない高度な操作も可能。

ローカルCLIは、自分のPC上で動作。自由度が高いが初期設定が必要な場合もあり、Python環境 + GPU などがある人向けです。細かい制御やバッチ処理ができます。

ターミナルでの実行

クラウドCLIは、ブラウザ上のJupyter Notebook(例:Colab、Runpod)や、REST API を curl や Python で叩く方式が一般的。

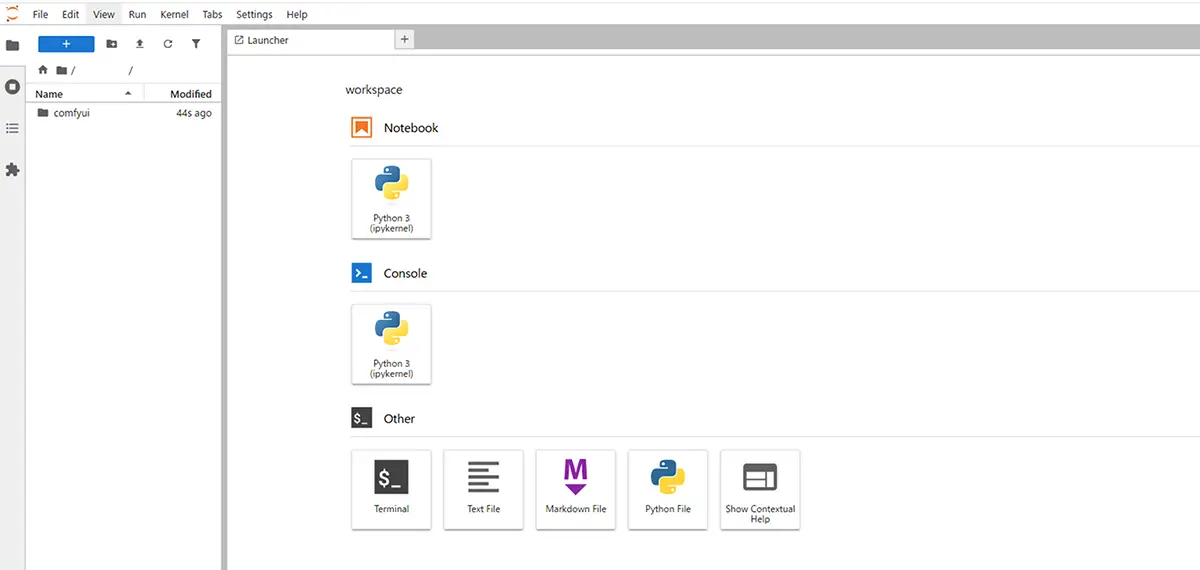

Jupiter notebook UI画面

このような操作をするツールは「CLIツール」と分類されます。

python mytool.py --input image.png --output result.pngこれは PythonスクリプトをCLIとして使っている例 です。正確には「PythonスクリプトをBashなどのコマンドライン上で実行する形式」です。python:Pythonインタプリタを呼び出すコマンド。mytool.py:実行したいPythonスクリプトのファイル名。--input と --output:Pythonスクリプトに渡すオプション(コマンドライン引数)。

CLI操作の画像処理ツール例

| ツール名 | 実行例 | 分類 |

| Real-ESRGAN(スクリプト) | python inference_realesrgan.py -i input.jpg | CLI |

| GFPGAN(スクリプト) | python inference_gfpgan.py -i input.jpg | CLI |

| Stable Diffusion (diffusers使用) | python txt2img.py --prompt "cat" | CLI |

CLIとはいえGUIと併用されるケースもある

- たとえば

AUTOMATIC1111やComfyUIは、CLIで起動してWebブラウザで操作するGUIです。 DockerもGUIは持たないが、WebUI付きツールを走らせることが多い。RunPodやKaggleはCLIベースのJupyterノートブックです。

この様に、カテゴリー分けが曖昧になりがちな為、初めは、少しわかりづらいなと感じます。

| 項目 | GUI(グラフィカルUI) | CLI(コマンドラインUI) |

|---|---|---|

| 表示 | 画面・ボタン・画像・ウィンドウなど | 黒い画面に文字だけ(ターミナル) |

| 操作方法 | マウスやタッチ操作で直感的 | キーボードでコマンド入力 |

| 学習コスト | 低い(初心者向き) | 高い(慣れが必要) |

| 柔軟性・自由度 | 限られる(操作は決まっている) | 非常に高い(スクリプト・自動化も可能) |

| エラー時の対応 | 視覚的にわかりやすい | エラー文から読み取る必要あり |

| 例 | Leonardo.ai、AUTOMATIC1111のWeb画面、Photoshop | ターミナル、Anaconda Prompt、Pythonスクリプト実行 |

AUTOMATIC1111はインストールは、CLI(Git + Python コマンド)普段の使用は、GUI(ブラウザから操作)。

「Pythonでコマンドラインから実行するツール」は、CLI(Command Line Interface)ツール 。

画像生成AIを動かす 7つの方法(2025年版)

| 分類 | 方法 | 操作タイプ | 具体例 | 特徴 |

|---|---|---|---|---|

| ローカル環境 | ①GUIアプリ | GUI | NMKD GUI(Win)、DiffusionBee(Mac)、Stable Diffusion UI、Draw Things(iOS版も有) | インストールしてすぐ使える。初心者向けで設定が簡単 |

| ②Web UI | GUI | AUTOMATIC1111、ComfyUI、InvokeAI、Fooocus | 高機能・拡張性あり。カスタマイズ性が豊富 | |

| ③コマンドライン | CLI | Hugging Face diffusers、InvokeAI CLI、ComfyUI headless、python generate.py | 軽量で柔軟。画面はなくスクリプト操作が中心 | |

| ④WSL+Linux | CLI / GUI | WSL2 + diffusers、Docker + AUTOMATIC1111、Linux版ComfyUI | WindowsでもLinux環境を利用したい場合に便利 | |

| クラウド環境 | ⑤実行環境 | CLI / GUI | RunPod、Google Colab、Kaggle、Paperspace、Lambda Labs | クラウドGPUを借りて実行。ローカル性能に依存せず高負荷処理が可能 |

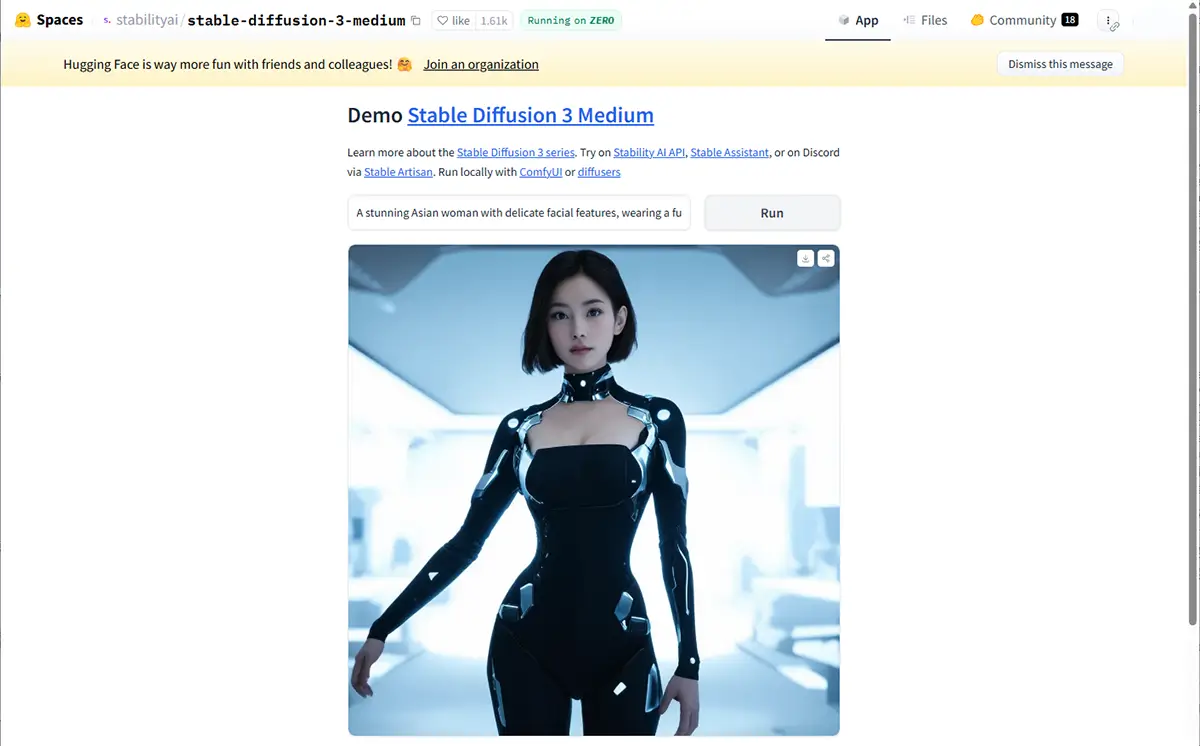

| ⑥Webアプリ | GUI | Hugging Face Spaces、DreamStudio、Leonardo.Ai、Midjourney(Discord)、Adobe Firefly、Runway ML、Fotor、Canva AI | アカウント作成だけで即利用可能。カスタマイズ性は低め | |

| モバイル | ⑦スマホアプリ | GUI | Draw Things(iOS)、Imagine AI、AI Picasso、Wonder AI、StarryAI、StableArt、Picsart AI | モバイル完結。手軽だが制限あり。外出先でも生成可能 |

①, DiffusionBee(macOS専用)

- 特徴:Macで使えるGUIツール(Draw Thingsと近いが異なる)

- メリット:

- ワンクリックで導入可

- Appleシリコン(M1〜)に最適化

- 難易度:初心者向け

①, NMKD Stable Diffusion GUI(Windows専用)

- 特徴:インストーラー形式で手軽に使える完全ローカルGUI。

- メリット:

- プログラミング不要

- Windowsユーザーには特にやさしい

- 難易度:初心者向け

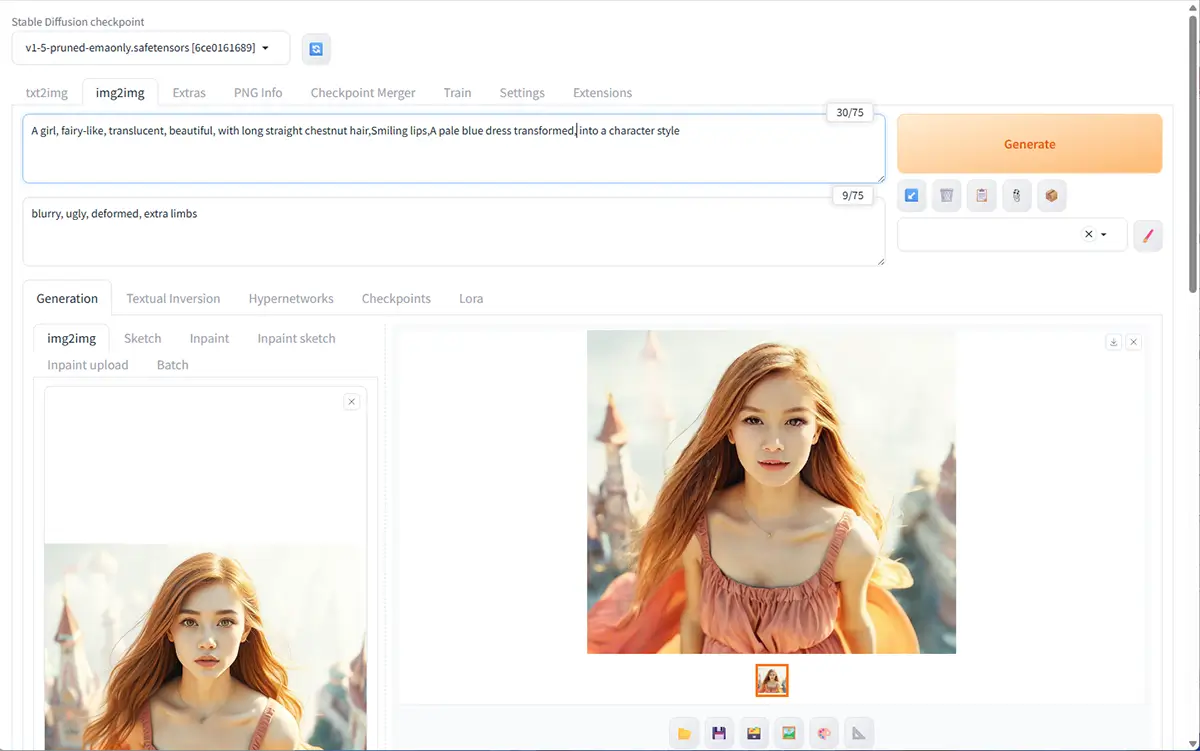

②, WebUI(例:AUTOMATIC1111)

- 概要・定義:

Webブラウザから操作できるユーザーインターフェース(UI)を備えたAI画像生成ツール。

代表的なのが「Stable Diffusion WebUI(AUTOMATIC1111)」で、ローカルにインストールして使う。 - 特徴:

- ボタンや入力欄で操作できるGUI

- 拡張機能やプラグインが豊富

- 初心者にも比較的始めやすい

- Pythonやコマンド操作の知識が少なくても使える

あわせて読みたい

WebUI(AUTOMATIC1111)の【インストール方法】【拡張機能インストール】【エラー対処法】 WebUI(Webユーザーインターフェース)とは、ブラウザを通じて操作できるユーザーインターフェースのことです。特にStable Diffusionでは、WebUIを使うことで専門的なコ…

②, InvokeAI

- 特徴:CLIでもGUIでも操作できるStable Diffusionツール。

- メリット:

- 複数の生成モード(txt2img, inpainting, etc.)

- A1111より軽量で安定性あり

- 難易度:中〜上級者向け

あわせて読みたい

【InvokeAIの使い方】最新版InvokeAI|Stable Diffusion 使い方完全ガイド・2026年版 InvokeAI の特徴 「InvokeAI(インヴォーク・エーアイ)」は、Stable Diffusionをベースとした画像生成ツールの一つで、特に以下のような特徴。があります。 項目内容 …

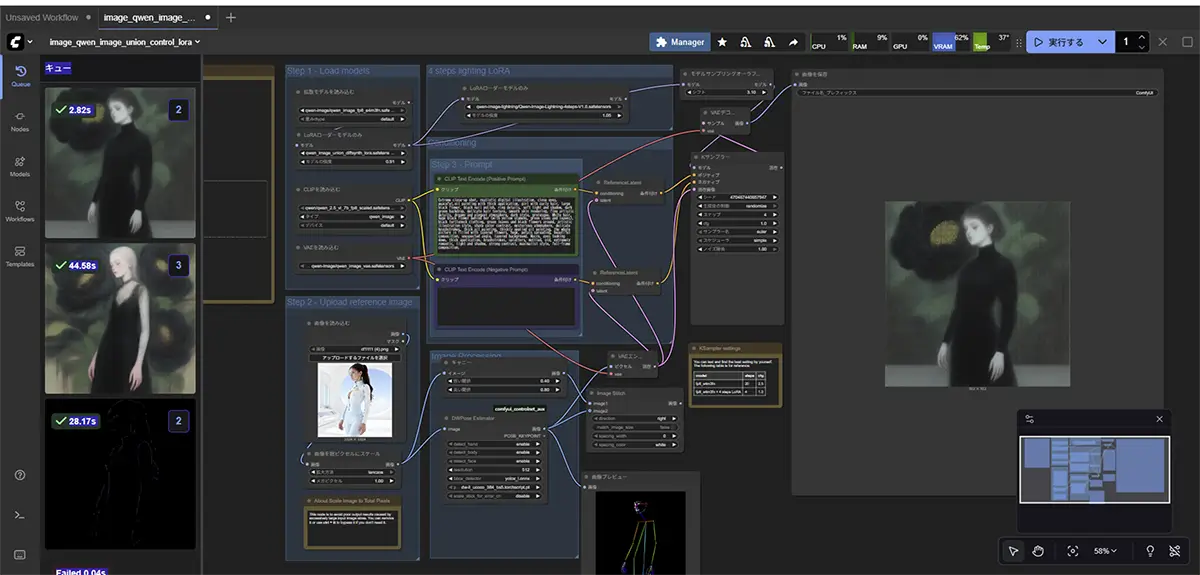

②, ComfyUI

- 特徴:ノードベースで操作できるWebUI(BlenderやTouchDesignerのような感覚)。

- メリット:

- 処理の流れを視覚的に設計できる

- カスタマイズ性が極めて高い

- 難易度:中級者以上向け(ただしGUI操作)

あわせて読みたい

ComfyUIとは?Stable Diffusion 各モデルの特徴・用途・対応ツールのインストールと使い方 ComfyUIの使い方 Stable Diffusionの代表的WebUI「AUTOMATIC1111」に続き、InvokeAIやForgeも人気が急上昇。しかし、最も高機能なツールとして注目されるのは、自由自在…

②, Fooocus

特長:とにかく簡単なのに高精細で大注目

2025年6月の最新版2.5.3 の顔入れ替えの精度とスピード感と自然さはハイグレード。

あわせて読みたい

Fooocus 2.5.3(Stable Diffusion)完全ガイド|ComfyUI・Automatic1111比較|SDXL・RunDiffusion対応【… Fooocusの使い方 「Fooocus(フーカス)」は Webサービス ではなく、ローカルで動かす画像生成ツール です。今回の最新版2.5.3 では、安定性や速度、アップスケーラーや…

②, ローカルWeb UIを、コンテナ技術(Docker)で実行する方法

- 概要・定義:

自分のPC上(ローカル)で、Dockerコンテナ内に画像生成AIの環境(例:AUTOMATIC1111)を構築・実行

普通の「ローカルWeb UI」は、

➡ Python、CUDA、依存パッケージなどを自分のPCに直接インストールして動かす方法。

Dockerを使った「ローカルWeb UI」は、

➡ 必要なソフト一式をコンテナ(箱)の中で用意して動かすので、自分のPCは最低限の操作だけで済む方法です。 - 特徴:

- 環境の再現性が高い(どこでも同じ環境)

- セットアップが自動化できる

- 中〜上級者向け(Dockerの理解が必要)

あわせて読みたい

【Dockerコンテナ徹底解説】~インストールからDocker対応AIツールまで Dockerコンテナとは? 通常、あるツールやアプリを動かすには「OSの設定・依存ライブラリ・Python・CUDAのバージョン」などを細かく合わせる必要があります。そして、そ…

③, RunPodやKaggleでクラウド実行

- 概要・定義:

PCに高性能GPUがなくても、外部サービス(クラウドレンタルGPU)を使って画像生成を行う方法です。

一部ローカルとも併用できるため紹介。 - 特徴:

- GPUを安価・一時的に利用可能

- ローカル環境を汚さずに試せる

- モデルやツールのダウンロードなどの作業無しに、すぐに使える

- ファイルのアップロード・保存には注意が必要

レンタルGPU

【2025年版】クラウドGPU比較|RunPod・Colab・Paperspace・Lambda Labsの特徴と選び方 クラウドGPUのニーズと記事の目的 近年、AI生成や3Dモデル作成、機械学習の学習用途などで、高性能GPUの需要が急速に高まっています。個人のPCでは対応が難しい処理も、…

使いやすいのでおすすめ

クラウドGPU”RunPod”とは?画像生成・LoRA学習の最適解?!個人利用の効率よいクラウド環境【①解説編】 ComfyUI、Stable Diffusionなどの画像生成も使いやすい Stable Diffusionで「思う存分、画像,動画生成がしたい」「自分の作風を学習させたい」「LoRAやDreamBoothを試し…

④, Pythonスクリプトでの実行

- 概要・定義:

コードベースでStable Diffusionなどのモデルを直接操作する方法。

Pythonで書かれたスクリプト(例:txt2img.py)を自分で実行する。 - 特徴:

- 柔軟性が高く、細かい制御が可能

- 上級者向け(Pythonの知識が必要)

- 最もカスタマイズ性が高い

⑤, WSL + Linuxツールで実行

- 概要・定義:

Windowsユーザーが「WSL(Windows Subsystem for Linux)」を使い、Linux環境上で画像生成ツールを動かす方法。 - 特徴:

- Linux前提のツールも使えるようになる

- WSL経由でCLI操作が必要

- PythonスクリプトやDiffusersなどと相性が良い

- 初心者にはややハードル高め

⑦, ローカルGUIアプリ(例:Draw Things)

- 概要・定義:

MacやiOSなどに対応した、完全ローカル動作のGUIアプリケーション。インストールするだけですぐ使える。 - 特徴:

- 簡単・手軽に使える

- モバイルや非エンジニアにも優しい

- 機能は限定されることがある

- モデルの管理やカスタム化はやや制限あり

その他の可能性

- Jupyter Notebook での実行(ローカル):Diffusersライブラリなどを使い、自分のPCでNotebook形式で動かす

- ローカルAPI化して外部ツールと連携:例えばローカルで立てたWebUIに他のアプリからリクエストを送る形

用途別おすすめ

| 目的 | おすすめの方法 |

|---|---|

| とにかく簡単に始めたい | Draw Thingsや RunPod |

| カスタマイズしたい・プロンプト細かく試したい | WebUI(AUTOMATIC1111) |

| 学習済モデルを自分で組み合わせて使いたい | ローカルCLI or WSL |

| 学習(LoRAなど)やモデル改造もしたい | Docker or WSL |

| WindowsでもLinuxツールを活用したい | WSL |

それぞれのメリット・デメリット

| 方法 | メリット | デメリット |

|---|---|---|

| WebUI | GUIで使いやすい・人気 | 少し重い・初回DLが多い |

| CLI | 自由度が高い・軽い | コマンド操作が必要 |

| WSL | Linuxの環境そのまま | 初期構築がやや複雑 |

| Docker | 再現性・切り替えに最適 | 使い方に慣れが必要 |

| RunPodなど | GPU不要・DL無し・容易 | 有料・保存制限なども |

| Draw Things | 初心者に優しい | 機能が限られることも |

さらに詳しい比較はこちらの記事をご覧ください。

画像補完系(CodeFormer・RestoreFormer)を使いたい場合

- PythonベースのCLI実行が基本です。

- Windowsネイティブ or WSL or Docker いずれかで環境構築が必要。

pip install -r requirements.txtのような操作が出てきます。

あわせて読みたい

AI画像補完ツールとは?—初心者向けに仕組みから使い方、おすすめツールまでを徹底解説 画像を補完・修復・高画質化するツール AI画像補完ツールとは? AI画像補完ツールは、AI技術を使って画像の欠けた部分や不完全な要素を推測して補うツールです。これに…

あわせて読みたい

Real-ESRGAN と GFPGANを連携させる方法とGUIで使えるツール Real-ESRGAN と GFPGAN Real-ESRGAN(リアル・イーエスアールガン)と GFPGAN (ジーエフピーガン)は、インストール手順や使い方が、かなり似ています。両方とも Tence…