【初心者向け】自作LoRAの作り方|Kohya_ssで学習する方法|Anaconda + CUDA【Windows】

ローカル環境構築から学習までを解説

この記事では、LoRAをKohya_ssで学習する為の環境構築からKohya_ssを開くまでの手順を解説しています。

LoRAモデルの概要、モデルの選び方に関しては、こちらのリンク記事で書いています。

Kohya_ssを使用してLoRA学習をする手順はこちらの記事で書いています。

Kohya_ssでLoRA学習をする方法

Kohya_ssとは?LoRA学習に特化したGUI版の使い方【完全ガイド2025年最新版】 Kohya_ssとは? 本記事では、Kohya_ssとは何かという基礎から、LoRA学習に特化したGUI版の使い方、そして2025年時点の最新UIの実践手順までをまとめて解説します。 Kohy…

目次

Kohya_ssでLora学習する方法

近年、イラストや写真などのスタイルをAIに学習させる「LoRA(Low-Rank Adaptation)」が注目を集めています。

中でも、人気の学習ツール「Kohya_ss」は、最低限のコマンド操作と、細かな設定が可能なWebUI(ブラウザ型GUI)で、多くの生成AIユーザーに支持されています。

この記事では、初心者の方でも安心してLoRA学習を始められるように、Kohya_ssをWindowsでローカル環境(自身のPC)に導入する手順を1つずつ丁寧に解説しています。

Kohya_ssを導入するための、Anacondaのセットアップから、CUDA・PyTorchの対応バージョン確認方法まで網羅しているので、この記事を参考にすれば自分のPCでもLoRA学習ができるようになります!

※ Lora学習では、通常 GPUのVRAM(ビデオメモリ)が、12 GB以上必要です。

▶ GPUの VRAM容量の確認方法(Windows)は、こちらをクリックして下さい。

⚠️ 注意

VRAM(GPUメモリ)とは、画像生成やAI処理で使用される

GPU専用のメモリ容量のことです。

※ PCのメモリ(RAM)とは別物です。

Windowsの場合:

スタートボタンを左クリックタスクマネージャー → パフォーマンス → GPU → 専用GPUメモリ

”専用GPUメモリ”に記載されている容量がGPUのVRAMです。

LoRA学習やStable Diffusionでは、GPUのVRAM容量(例:8GB / 12GB)が重要になります。

ご自身のPCのGPUのVRAM(ビデオメモリ)が、12 GB以下の場合は、クラウドGPUでの学習がおすすめです。

クラウドGPUを使用するメリット

- この記事でご紹介しているツールのダウンロードの手間が無い

- 選択するGPU次第で学習を高速で終わらせる事が出来る

クラウドGPUで”LoRA学習する方法”についてこちらの記事をご覧ください

クラウドのレンタルGPUを使用してLoRAをKohya_ssで学習する方法

【RunPodの料金と使い方】Stable Diffusionなどで画像生成やLoRA学習をする方法【②実践編】 RunpodでStable Diffusion系画像生成やLoRA学習をする方法 Stable DiffusionやLoRA学習では、長時間GPUをフル稼働させるため、発熱や電源の安定性が大きな課題になりま…

Anaconda+CUDAでKohya_ssをローカル導入する方法

前提条件

- GPU:NVIDIA

- OS:Windows 10 / 11

- Python:3.10.x(推奨)Python3.10.6のインストール方法はこちら。

- 仮想環境:Anaconda(推奨)後ほど解説スキップしたい方はこちらをクリックしてください。

- CUDA:*使用するPyTorchバージョンが対応するCUDAバージョンを調べる。(このすぐ下で解説。)

- NVIDIAドライバ:最新版(Studio Driver推奨)(この下で解説。)

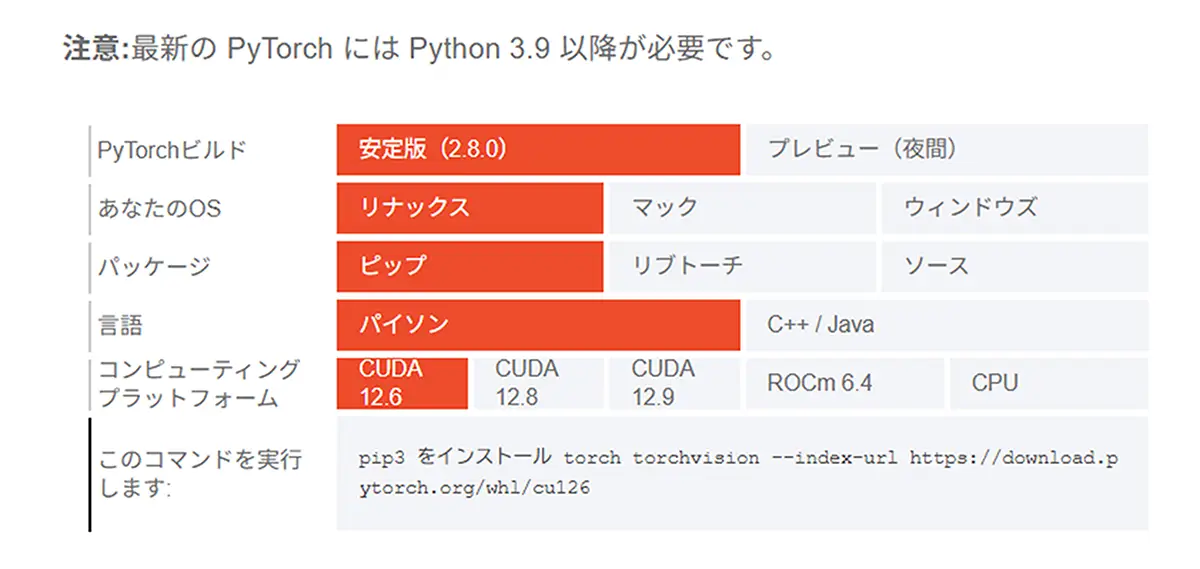

*使用するPyTorchバージョンに対応するCUDAバージョンを調べる方法

PyTorchは、バージョンごとに対応するCUDAのバージョンが決まっています。

PyTorch公式ページにアクセスしますhttps://pytorch.org/get-started/locally/

使用する条件の選択<strong>PyTorchビルド</strong>(例:2.1.0)➡通常は安定版を選びます。あなたのOS ➡(例:Windows)<strong>パッケージ</strong> ➡(通常は「Pip」または「Conda」)言語➡(Python)

CUDAバージョン(ここに対応するCUDAが表示されます)

選択に応じて、下にインストール用コマンドと一緒に、推奨されるCUDAのバージョンが表示されます。

*NVIDIA AppでStudioドライバの確認

※2024年11月12日、NVIDIAは「GeForce Experience」を廃止し、後継として「NVIDIA App」に移行しています。要確認。

NVIDIA App(旧:GeForce Experience)を開く

左メニューまたは上部の「Drivers」タブを選択

「Studio Driver」になっているか確認(必要に応じて切り替え可能)

無い場合は、ダウンロードしておきますNVIDIA公式サイト内/ドライバ:ダウンロードページ

ポイント

PyTorchとCUDAのバージョンが合っていないと、エラーになることがあります。

CUDA 11.8 を使いたい場合は、PyTorch 2.1 までが対応しています。

最新のPyTorch(2.2以降)では、CUDA 12.x系が主流になっています。

Kohya_ssは依存関係が多いツール

Kohya_ss(LoRA学習GUI)は以下のような依存ライブラリが複雑に絡んでいます

- PyTorch(バージョンやCUDAとの整合性がシビア)

- xformers(PyTorchのバージョンに敏感)

- bitsandbytes(GPU構成によって挙動が変わる)

- Hugging Face Transformers / diffusers

- TensorBoard、WandB などのオプションツール

これらをpip + venvだけで揃えるのは、かなり経験者向けの作業です。

一方、Anacondaならこうした依存関係のバージョン調整が比較的簡単になります。

Kohya_ssのように「PyTorch + CUDA + 特殊ライブラリ」が絡む環境では、Anacondaで仮想環境を切っておくのが一番安全です。

| 比較項目 | venv(Python標準) | Anaconda(またはMiniconda) |

|---|---|---|

| 環境構築の簡単さ | 自分でPython・CUDA・PyTorchのバージョン整合をとる必要あり | condaが自動で依存関係を解決 |

| パッケージの管理 | 基本はpip頼り。複雑な依存関係で詰まりやすい | conda + pip両方使えて柔軟&強力 |

| CUDAの扱い | CUDA Toolkitを手動インストールしてパス設定が必要 | PyTorch+CUDAをconda install pytorchだけで完結できることが多い |

| 初心者への安心感 | エラー時の自己解決力が必要 | 失敗しにくい構成。エラーも少ない |

| 仮想環境の切り替え | source venv/bin/activate など | conda activate 環境名 で統一 |

この項のまとめです。(以下の項目をチェックしてOKでしたら、次の項目へ進んで下さい。)

GPUのCompute Capabilityを確認:NVIDIA公式サイトで自身のGPUのCCを調べる。

CUDAバージョンの選定:使用するPyTorchバージョンが対応するCUDAバージョンを選ぶ。

ドライバの更新:CUDAバージョンに対応するNVIDIAドライバをインストールする。

目的:仮想環境の活用:Anacondaやvenvを使用して、異なる環境を簡単に切り替えられるようにする。

AnacondaでLoRA学習環境を作る

Anacondaのインストール

- 公式ダウンロードページ: anaconda.com

任意のアカウントでログインします。

Anacondaの公式ダウンロードページから、お使いのOSに対応したインストーラーをダウンロードできます。

① Anacondaの準備

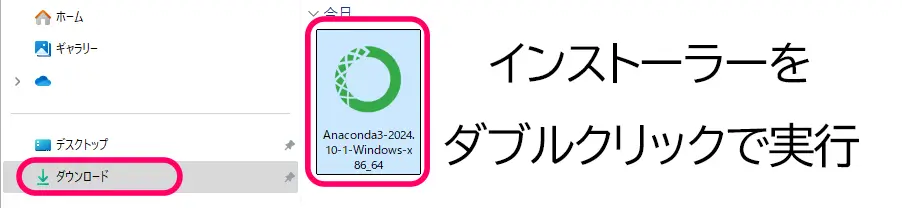

インストール手順(Windowsの場合)

- ダウンロードしたインストーラー(例:

Anaconda3-2024.10-1-Windows-x86_64.exe)をダブルクリックして実行します。

2. インストーラーが起動したら、「Next」をクリックします。

3. ライセンス契約画面で「I Agree」を選択します。

4. インストールタイプの選択では、「Just Me(推奨)」を選び、「Next」をクリックします。

5. インストール先フォルダを確認し、必要に応じて変更後、「Next」をクリックします。

6. 追加タスクの選択では、特に変更がなければそのまま「Install」をクリックします。

7. インストールが完了したら、「Next」をクリックし、最後に「Finish」をクリックしてインストールを終了します。

インストール後、スタートメニューから「Anaconda Prompt」や「Anaconda Navigator」を起動できます。

※Anaconda Navigator(GUI)からアップデートを求められた場合は、基本的にはそのまま「更新」してOKです。ただし、すでに構築済みの仮想環境内でパッケージを更新する場合は、conda updateやpipのバージョン管理に注意が必要です。

インストール確認

Anaconda Promptを開き、以下のコマンドを入力してPythonのバージョンを確認します。

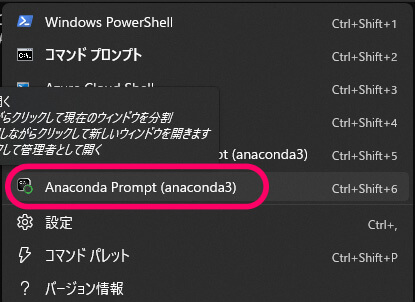

Anaconda Promptは、WindowsでAnacondaをインストールした後、以下の手順で起動できます。

- スタートメニューを開く

- 「Anaconda Prompt」と検索

- アイコンをクリックして起動

※黒いウィンドウが開き、(base) と表示されていれば、Anacondaの「base」環境が有効になっています。

もしくは、Windowsターミナルを開き、

タブから””下矢印をクリックで、Anaconda Promptを選択(Anacondaインストール後に追加されます。)

※ Windows のターミナルの起動方法…

Windows Terminal起動方法

- スタートメニューで、左クリック➡

ターミナルもしくは、「Windows Terminal」と検索して起動

※ デフォルトでは PowerShell または WindowsPowerShell)が開きます

画像生成用途の場合は、コマンドプロンプト(CMD)と相性が良いです。

pip install や conda などのモダン開発向けコマンドは、PowerShellと相性が良いです。

(※コマンドプロンプト(cmd)をWindows Terminal から開く為の設定方法はこちらの記事をご覧ください。)

Windows Terminalは、タブを切り替えて複数のシェルを使う事が出来ます

- 上部の

+ボタンから新しいタブを開けます

※Microsoft 公式も「Windows Terminal」を推奨

※ Mac のターミナルの起動方法…

ターミナル起動方法

- **「Command ⌘ + Space」を押して、「Spotlight検索」**を開く

- 検索バーに「ターミナル」と入力してEnter

または、以下の手順でも開けます:

アプリケーション → ユーティリティ → ターミナル

※ Linux のターミナルの起動方法…

Linuxターミナル起動方法

- 1,:

Ctrl + Alt + Tを同時に押す(多くのLinuxディストリビューションで共通) - 2,:アプリケーション一覧から「ターミナル」または「Terminal」で検索して開く

Ubuntu、Fedora、Debianなど、ほとんどのLinux環境に標準で搭載されています。

※ PowerShell の起動方法…(Windows)

PowerShell(パワーシェル)**は、Windowsに標準搭載されている、より高度な操作ができるコマンドラインツールです。見た目はコマンドプロンプトと似ていますが、より多機能で、プログラミング的な処理も得意です。

PowerShell起動方法

1,スタートメニューで「PowerShell」と検索してクリック

※ コマンドプロンプト(cmd)の起動方法…(Windows)

Windowsキー + Rを押す

「cmd」と入力してEnterを押す

または、スタートメニューで「コマンドプロンプト」と検索してもOK!

コマンドプロンプト(cmd)は、Windowsのターミナルからも開く事が出来ます

(※コマンドプロンプト(cmd)をWindows Terminal から開く為の設定方法はこちらの記事をご覧ください。)

python --versionまた、Anaconda Navigatorを起動して、GUI上で環境やパッケージの管理ができることを確認してください。

Anaconda Prompt を開いて以下を実行(仮想環境を有効化)

conda create -n kohya python=3.10 -y

conda activate kohya※このコマンドを実行する事で、kohya_ss 内で仮想環境を使った作業ができる状態になります。

② Git & GitHub からKohya_ssを取得

Gitがインストールされていることを確認

ターミナルで以下を実行

git --versionターミナルで以下を実行

→ git --version でバージョンが表示されればOK

※インストールされていなければ、公式サイトから入手してください。

あわせて読みたい

初心者でも迷わない!GitHub・Git・Git Bashの違いとインストール&使い方完全ガイド 生成AIを使っていると、モデル配布やカスタムノードなどで頻繁にお世話になるGitHub。 ですが、使う機会は多くても「そもそも GitHub とは何ができる場所なのか?」と疑…

Anaconda Prompt または コマンドプロンプトを開く

以下のコマンドでクローンします

git clone https://github.com/bmaltais/kohya_ss.gitkohya_ss フォルダに移動

cd kohya_sscd+kohya_ssフォルダのパス。

※たとえば、kohya_ssという名前のフォルダが C:\Users\あなたの名前\Documents\ にあるとします。

その場合、Anaconda Promptで以下のように入力して移動します。

cd C:\Users\あなたの名前\Documents\kohya_ss※クローン先のディレクトリに注意(cd や mkdir を使って管理)

仮想環境を使う場合は、先に Anaconda Prompt で仮想環境を有効化しておく。

状況の確認

(base) C:\Users\あなたの名前>cd C:\Users\あなたの名前\kohya_ss

(base) C:\Users\あなたの名前\kohya_ss>このように表示されていれば、今あなたは C:\Users\あなたの名前\kohya_ss フォルダの中にいます。

③ 依存ライブラリのインストール

pip install -r requirements.txt を実行

pip install -r requirements.txtCUDA 11.8 に対応した PyTorch 2.1.0 と torchvision 0.16.0 のインストール

は、以下のコマンドを実行してください

pip install torch==2.1.0 torchvision==0.16.0 --extra-index-url https://download.pytorch.org/whl/cu118CUDA 11.8 に対応した PyTorch 2.2.0 と torchvision 0.16.0 のインストール(バージョンは2.2.0の場合)

は、以下のコマンドを実行してください

pip install torch==2.2.0+cu118 torchvision==0.16.0+cu118 --extra-index-url https://download.pytorch.org/whl/cu118※CUDA、 PyTorch、 torchvisionのそれぞれのバージョンを指定してください。

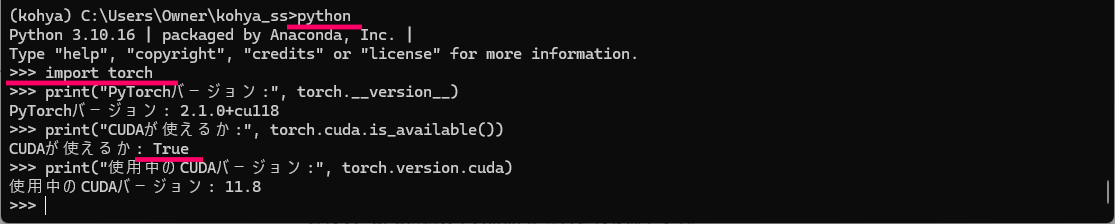

④ CUDAとPyTorchの対応確認(重要)

インストールが完了したら、以下の Python コマンドで動作確認できます。

Pythonコードを実行する正しい方法

- Pythonインタプリタを起動する

pythonと入力してEnterすると、Pythonの対話モード(>>>)になります。

- そこでPythonコードを入力してください

import torch

print("PyTorchバージョン:", torch.__version__)

print("CUDAが使えるか:", torch.cuda.is_available())

print("使用中のCUDAバージョン:", torch.version.cuda)- 確認が終わったら、

exit()またはCtrl+Z(Windows)でPythonを終了できます。

True が返ってきたらOK。

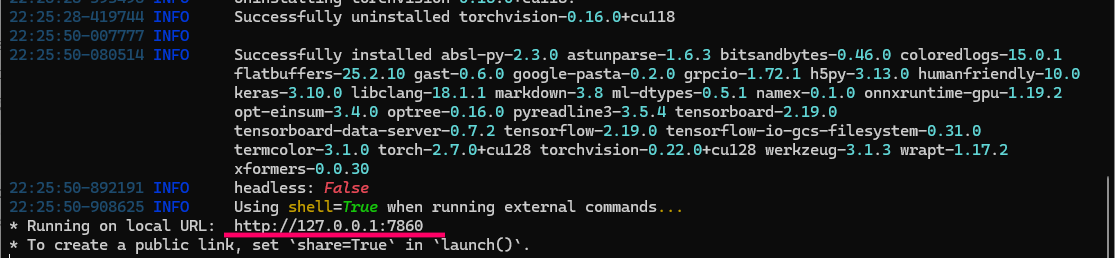

⑤ GUIの起動(ローカルブラウザで操作:Anaconda Prompt)

※GUIで作業をする際には、以下のコマンドを実行してGUIを開きます。

仮想環境のアクティベート(必要に応じて)

conda activate kohya # すでに実行済みならスキップKohya_ssのフォルダへ移動

cd C:\Users\Owner\kohya_ss※Users Ownerこの箇所は、ご自身のフォルダ名に置き換えて下さい。

Web UI 起動スクリプトの実行

Kohya_ss は kohya_gui.py というスクリプトでGUIを起動できます。

python kohya_gui.py※GUIが自動でブラウザに表示されない場合は、以下のようなURLが表示されることがあります

Running on local URL: http://127.0.0.1:7860※このURLをctrlを押しながら開くか、コピーしてブラウザに貼り付けてhttp://127.0.0.1:7860 を開きます。

よくあるエラー・確認ポイント

| 症状 | 対処 |

|---|---|

ModuleNotFoundError | requirements.txt の再インストールが必要な場合があります。 |

| 起動後真っ白で何も表示されない | ブラウザのキャッシュをクリア、または別ブラウザで試す |

| エラーメッセージが大量に表示される | 一度ターミナルを閉じて、仮想環境を再アクティベートしてから再実行 |

<span class="swl-inline-color has-black-color">kohya_gui.py</span> が見当たらない場合

GitHubからの取得が完全でなかった可能性があります。その場合は以下のコマンドで再取得出来ます。

git clone https://github.com/bmaltais/kohya_ss.gitその後、もう一度、移動&仮想環境アクティベート&起動。

⑤ GUIの起動(ローカルブラウザで操作:Anaconda Prompt)

LoRA学習

Kohya_ssを使用してLoRA学習をする方法はこちらの記事で書いています。

Kohya_ssでLoRA学習をする方法

Kohya_ssとは?LoRA学習に特化したGUI版の使い方【完全ガイド2025年最新版】 Kohya_ssとは? 本記事では、Kohya_ssとは何かという基礎から、LoRA学習に特化したGUI版の使い方、そして2025年時点の最新UIの実践手順までをまとめて解説します。 Kohy…

画像とcaption(.txt)ファイルについて

LoRA学習をする為の、画像とcaption(.txt)ファイルの用意がまだの方は、こちらの記事をご覧ください。

画像データとテキストタグの準備

【自作イラストをLoRA化】画像とキャプション(テキストタグ)の準備からフォルダ構成まで徹底解説 学習用データセットの作り方 LoRA(Low-Rank Adaptation)は、既存のAIモデルに対して、自分のイラストや作風を学習させられる技術です。でもいざ始めようとすると── 「…

LoRAの概要、モデルの選び方、学習方法の選択肢については、こちらの記事内にまとめました。

LoRAとは?

LoRAとは?仕組み・学習・使い方・学習パラメータまで【LoRA完全ガイド】 LoRAとは何か? LoRAとは、Low-Rank Adaptation(低ランク適応)の略で、大規模なモデル(例:Stable Diffusion)の重みをすべて再学習するのではなく、一部だけを効率…

おすすめのフォルダ構成

C:\Users\Owner\kohya_ss\

├── dataset\ ← データ系(学習素材)

│ ├── 10_train\

│ │ ├── img\

│ │ ├── txt\

│ │ └── reg\

│

├── outputs\ ← 出力ファイル(学習済LoRAなど)

│ ├── 12_loracat\

│ └── 10_train\

│

├── configs\ ← 設定ファイルの保存場所(任意)

│

├── venv\ ← 仮想環境(Anacondaなしで動かす場合)

├── GUI起動用のbatファイルやスクリプト

└── READMEなど

※Kohya_ssでトレーニングに使用する画像とテキストは、まとめて一つのフォルダに入れておきます。

WebUI(ブラウザ画面)の閉じ方

Kohya_ssでWebUIを使用してローカル学習を行っている場合、作業をいったん終了する際には、ターミナル側とWebUI側の両方で適切に閉じることが重要です。以下にそれぞれの正しい閉じ方を説明します。

WebUIは、Kohya_ssのGUI(ブラウザ)であり、直接的には学習プロセスを制御していません。ただの表示窓のようなものです。

- ブラウザのタブまたはウィンドウを閉じるだけでOKです。

- ChromeやEdgeなどで開いているKohyaのWebUIタブを普通に閉じてください。

- 学習ジョブが実行中でも、ターミナル側で動いていれば裏で進行します。

ターミナル(コマンドプロンプト / Anaconda Promptなど)の正しい閉じ方

ターミナルはKohya_ssのWebUI(gui.py)を起動している実行プロセスです。

閉じるタイミング

学習をまだ開始していない/完了済みの場合

- ターミナルにフォーカスして、

Ctrl + Cを押す(2回必要な場合あり)Shutdown this Flask server (y/n)?と出る場合は、yを入力してEnter。

- コマンドプロンプトがプロンプト(例:

(base) C:\Users\yourname>)に戻ったら、ターミナルを閉じてOK。

学習中に終了したい場合

- 学習ジョブが進行中に

Ctrl + Cを押すと、途中で学習が止まります。- ログ出力が止まり、「KeyboardInterrupt」と表示されます。

- チェックポイント(途中保存)されていない場合は、データが失われる可能性があるので注意。

※「定期保存(save_every_n_stepsなど)を有効にしておく」と、学習途中でもモデルが保存されます。

トラブル・エラー

エラー時の基本チェックポイント

- Training images

→images + .txtが同じフォルダに入っている → OK

→ フォルダ名output/art_part1→ OK(英数字とスラッシュのみで問題なし) - Dataset preparation

- 「Dreambooth/LoRA Folder Preparation」または「Dataset Balancing」のどちらかのみを使用する。

- 通常のLoRA学習では「Folder Preparation」で十分。「Dataset Balancing」はデータに偏りがあるとき用。

- 出力先指定(Save trained model as)

→ 設定済みであればOK。空白だと保存されないことがあります。 - ログ出力確認

/kohya_ss/outputs/に.tomlや.jsonが出力される場合、「ボタンは動作しているが学習開始に失敗している」可能性が高い。- エラーが出ないのはPython側でエラーを握り潰している場合あり。

- 学習設定の最小限構成でテスト

- epoch数を1、ステップ数を10程度にして動作確認用にしてみてください(負荷をかけず起動の可否だけチェック)

Startの前に、GUIの 「Trainタブ」→ 全項目の必須入力欄 は埋まっていますか?- 特に以下のような項目が必要です。

Base model pathOutput nameOutput directoryImage folderCaptionファイル形式(BLIP/DeepBooruなど) or.txtSave trained model as(safetensors)Epochやbatch sizeなど

| トラブル例 | 対処法 |

|---|---|

| フォルダ指定でクラッシュする | 「📁マーク」からクリックで選択(ドラッグや手入力は避ける) |

| 選択後に内容が更新されない | 一度タブを切り替えるか、ページをリロード(F5) |

| エラーでフォームが固まる | GUIページを閉じて、再読み込み(または再起動) |

| GUIが応答しない | Anacondaで一度Ctrl+Cしてサーバーを再起動(重要) |

GUIが壊れてしまった場合

kohya_ssフォルダにあるui-config.jsonを削除- Anaconda Prompt で再起動

cd C:\Users\Owner\kohya_ss

python kohya_gui.py「.toml」「.json」「.txt のみが出力される!

「.toml」「.json」「.txt のみが出力された」という場合

KohyaのLoRA学習を実行したあと、モデルファイル(例:.safetensors)が出力されなかったという意味です。

これはいくつかの原因が考えられます。以下を順番にチェックしてみてください。

学習エポック数(epoch)が 0 や 1 になっていないか?

Epochの数が極端に少ないと、学習がほぼ行われず、モデル出力がスキップされることがあります。- 2〜4以上にして再試行してみてください。

output_name の指定がない or 無効な名前になっていないか?

- 出力ファイル名が

output_name.safetensorsとして作成されるため、ここが空欄だと出力されない場合があります。 - 例:

lora_dogなどの名前を必ず入れておく。

出力フォルダが output_dir で指定されている場所に .safetensors が出ているか?

.tomlや.jsonは設定保存ファイルです。学習結果(モデル)は.safetensorsで出力されます。- 例:

/workspace/outputs/lora_dog.safetensorsなどに出力されているか確認。

Save every N steps などの中間保存が有効かどうか?

- 学習途中で保存する設定(

save_every_n_stepsなど)がないと、学習途中で停止した場合に何も出力されないことも。

コマンド実行時にエラーが出ていたかも?

- 実行ログ(WebUI上部 or Terminal)を確認し、途中で

CUDA out of memoryなどのエラーが出ていなかったかチェック。

Start training を押しても無反応な場合のチェックポイント

Kohya GUIでは、以下のような必須項目が空白だと、裏側でコマンドが生成されず、Start training を押しても無反応になります。

確認すべき項目(特にLoRAの場合)

Image folder(学習用画像のフォルダ)

Output namePretrained model(ベースのモデルファイル)

Output directoryEpoch(エポック数)や Batch size(バッチサイズ)

どこか赤く縁取りされている項目がないかチェックしてください。

ファイルパスの指定ミス

Pretrained model や Image folder のパスが 存在しないか間違っている と動作しません。

Browse ボタンでGUI経由で選択するのがおすすめ。

ターミナルや htop コマンドで裏側のプロセスが動いているかも確認できます。

CLI Preview(またはログ)にエラーが出ていないか?

Start training 実行後に下部にエラー表示がある場合、それが原因です。

「CLI Preview」ボタンがある場合は、出力されるコマンドを先にチェック。

CLI(コマンドライン)での実行も可

GUIでのトラブルがあまりに多い場合、以下のようにCLI(コマンドライン)でLoRA学習を実行する方法もあります

python train_network.py --config_file="your_config.json"GUIは設定の確認用、CLIは確実に回す用、と使い分けている人も多い。

ComfyUIやAUTOMATIC1111との連携

Kohya_ssで作成したLoRAファイルは、ComfyUIや、AUTOMATIC1111、InvokeAIなどのツールで、使用できます。

- LoRAファイルは

/webui/models/Lora/に配置 - WebUIで LoRA名を

"<lora:modelname:weight>"として使えます。

このフォルダに入っている .safetensors や .pt ファイルが、ComfyUIや、A1111などのWebUIで自動的に読み込まれ、モデル選択UIやプロンプト補完で使用可能になります。

作成した、.safetensors や .ptファイルの使用方法の詳細は、下のリンク記事をご覧下さい。

あわせて読みたい

【完全ガイド】Stable Diffusion WebUI(AUTOMATIC1111) LoRA モデルの使い方と設定手順 この記事では、Stable Diffusion WebUI(AUTOMATIC1111)での、”LoRAモデルの配置方法から、強度の設定・プロンプト調整までを、わかりやすく解説しています”Stable Dif…

ComfyUIのインストール方法や使用方法については、こちらの記事をご覧ください。

ComfyUIで生成したい場合はこちら

ComfyUIとは?Stable Diffusion 各モデルの特徴・用途・対応ツールのインストールと使い方 ComfyUIの使い方 Stable Diffusionの代表的WebUI「AUTOMATIC1111」に続き、InvokeAIやForgeも人気が急上昇。しかし、最も高機能なツールとして注目されるのは、自由自在…

Stable Diffusio(AUTOMATIC1111)のインストール方法については、こちらの記事をご覧ください。

SAKASA AI

WebUI(AUTOMATIC1111)の【インストール方法】【拡張機能インストール】【エラー対処法】 | SAKASA AI WebUI(Webユーザーインターフェース)とは、ブラウザを通じて操作できるユーザーインターフェースのことです。特にStable Diffusionでは、WebUIを使うことで専門的なコマ…