【FaceFusion 3.4.1】手軽に顔交換!フェイススワップ完全ガイド|GUI設定まで解説【RunPod対応】

FaceFusion v3.4.1

画像上の顔をそのままコピペするのではなく、顔の角度・骨格・目の距離・輪郭などを解析し、3D的な座標変換とマスク生成する。

色補正や質感調整をリアルタイムで行う高精度なスワップ処理で、自然で破綻の少ない顔入れ替えが可能になった、

最新の v3.4.1 では、マスクの滑らかさ・輪郭の馴染み方が大幅に改善されました。

未来

未来この記事では、AI補正と実写合成の中間にある“自然なフェイススワップが可能なFaceFusion v3.4.1について解説しています。

目次

高速フェイススワップ

- リリース時期:2024年10月頃

- 開発元:@facefusion(GitHub上のオープンソースプロジェクト)

- 主目的:**顔スワップ(Face Swap)**を、オフライン環境でも実行可能にする。

- 対応OS:Windows / macOS / Linux

- 推奨GPU:NVIDIA系(CUDAサポート)

- 実行モード:

- CLI(コマンドライン)

- GUI(ブラウザ上で操作可能なUI)

- Headless(サーバーやクラウド向け)

FaceFusionの仕組み

FaceFusionは「DeepFake」ではなく、顔の特徴量マッピング+ブレンド合成を行う設計。

- 顔の骨格や角度が近いほど自然(でも変化が小さい)

- 顔の骨格が違うほど変化が大きい(でも破綻しやすい)

というトレードオフがある。

v3.4.1 の主な変更点(v3.3以前との違い)

| 項目 | 内容 |

|---|---|

| モデル構造 | 新しい InsightFace ベースの顔認識を標準採用。 以前より自然なマッピングと輪郭補正が可能に。 |

| 顔マスク | 「adaptive mask」機能が改善され、髪や輪郭の繋がりが自然に。 |

| 設定UI | GUIモードでリアルタイムプレビューが追加(ブラウザ上でマスク確認可能)。 |

| パフォーマンス | マルチスレッド処理が最適化され、処理速度が約20〜30%向上。 |

| 実行プロバイダー | ONNXRuntime 1.18対応。CUDA 12.3でも安定動作。 |

| 出力 | “enhancer”(補正モジュール)の品質調整が細分化。4段階選択可能。 |

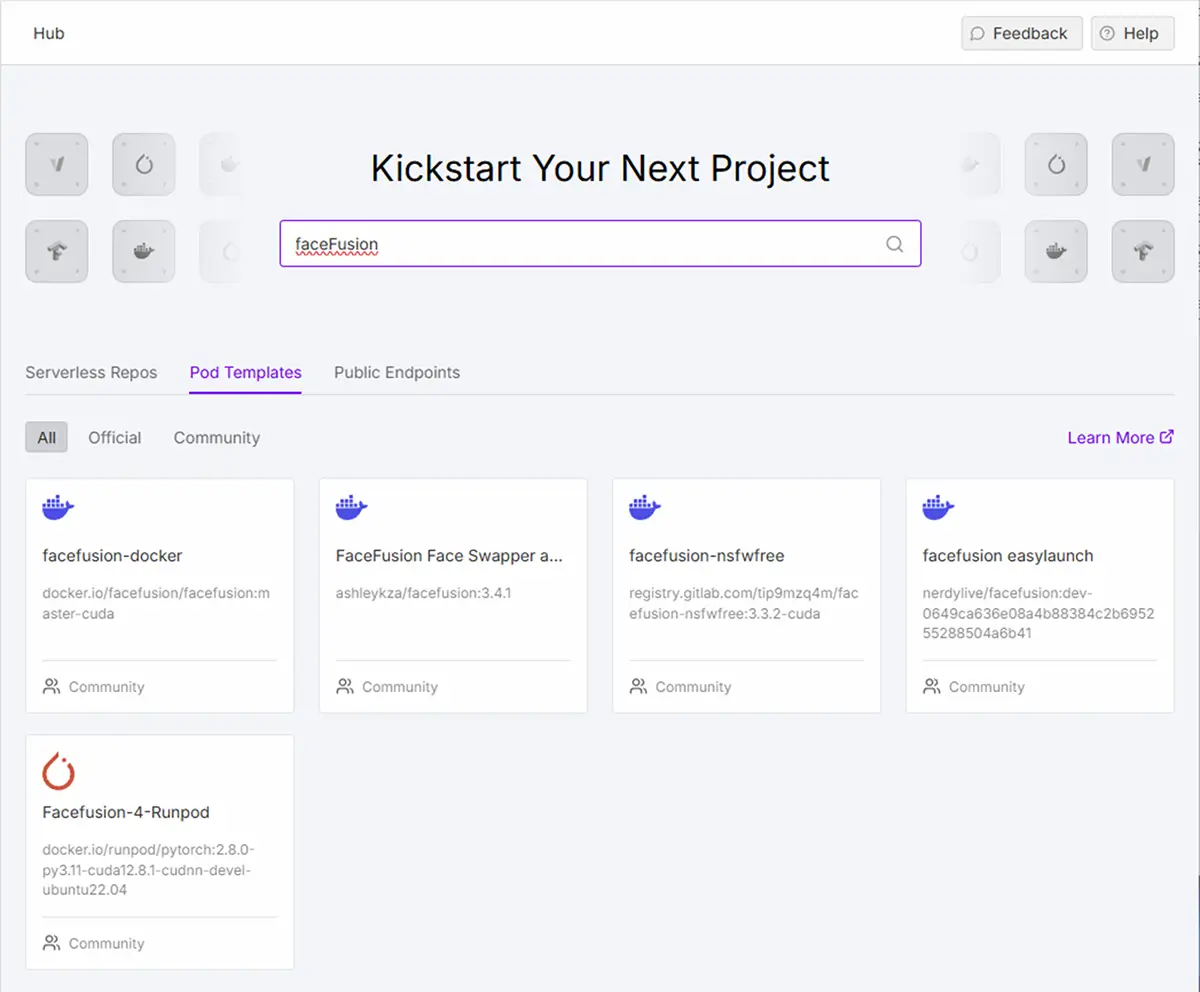

【クラウド環境】クラウドならFaceFusionはRunPodが使いやすい

クラウドなら、FaceFusionのような「重い処理を繰り返す系」は、RunPodのようなGPUが実用的です。

RunDiffusionも手軽にFaceFusionが試せますが、FaceFusion 3.4.x 系は構造自体がかなり軽量化・最適化されてるので、

RunPodとの相性がとてもいいです。

| 比較項目 | RunDiffusion | RunPod |

|---|---|---|

| 環境変更の自由度 | ほぼなし | かなり自由 |

| 手軽さ | ||

| GPU選択 | 自動 | 手動で最適化できる |

| ファイル永続化 | なし(都度DL) | あり(workspace保持) |

| コマンド利用 | 不可 | JupyterLabやTerminalで可 |

| 学習・自動化向け | ❌ | ✅ |

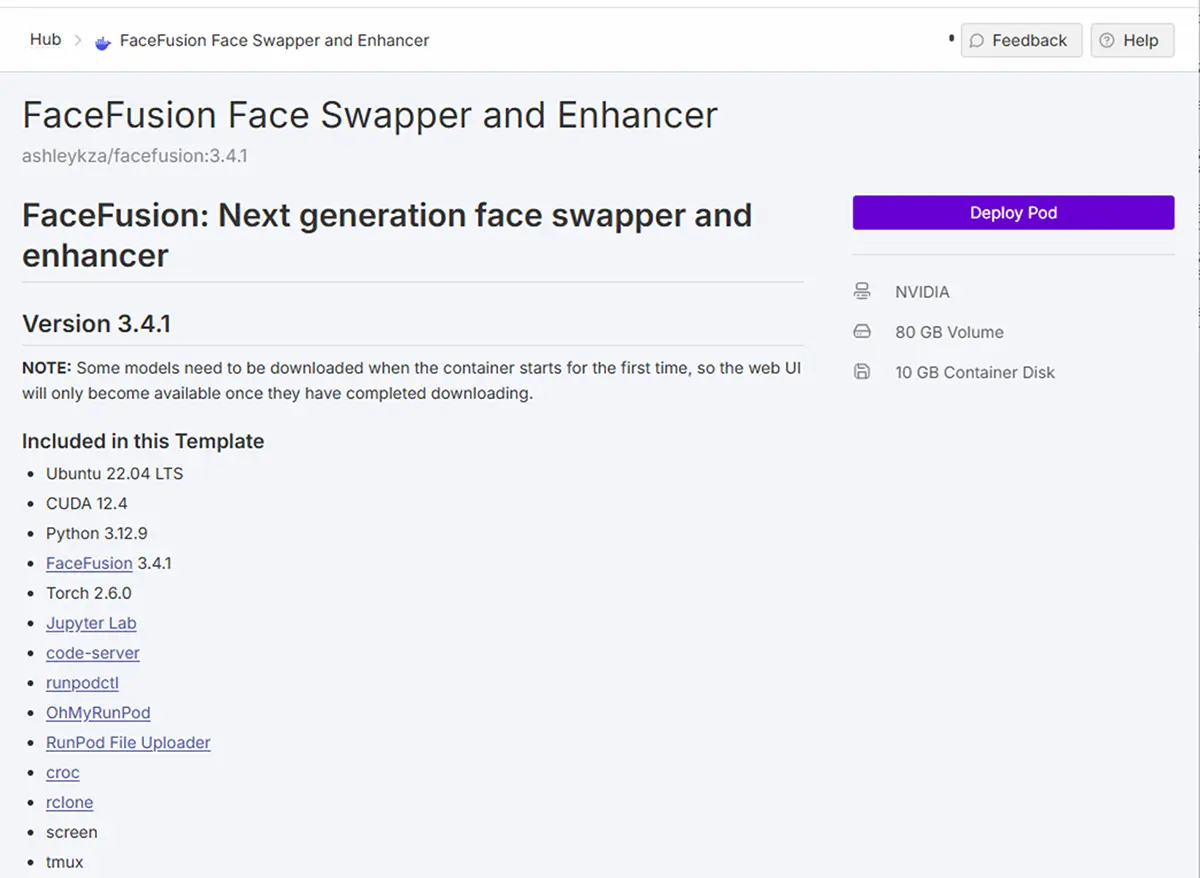

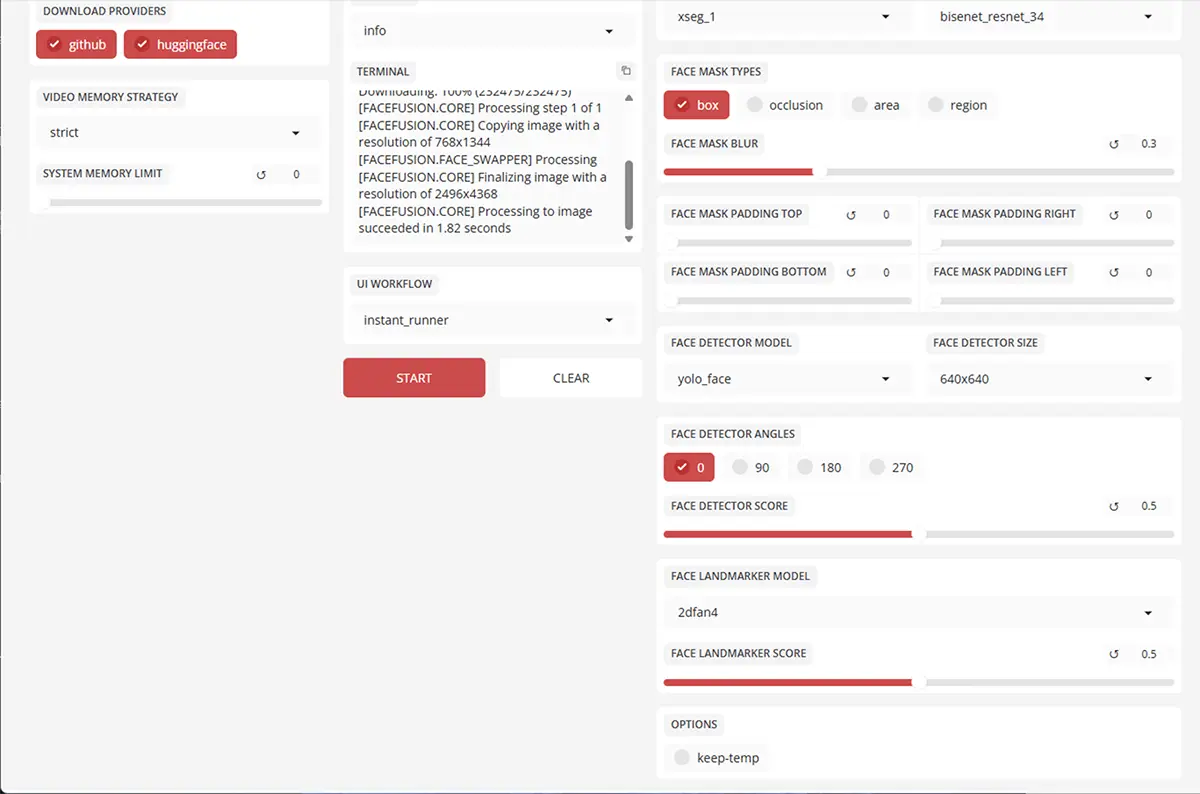

RunPod上のFaceFusion 3.4.1起動ログ。

テンプレート”FaceFusion Face Swapper and Enhancer”は、すぐに使えるのでお勧めです。

先日は起動開始から、わずか約1分でコンテナがREADYに。2分の時もありましたが、比較的起動がスムーズです。

Jupyter Lab、code-server、FaceFusion本体が同時に立ち上がるため、すぐに作業を開始できます。

【ローカル環境】インストール手順(Windows向け)

※Python 3.10 〜 3.11 を推奨

※VRAM 6GB以上推奨(動画スワップ時は12GB以上)STEP

依存ツールを準備

- Python公式サイト から Python 3.10 をインストール。

インストール時に「Add Python to PATH」にチェックを入れる。 - NVIDIA GPUを使う場合は CUDA Toolkit 12.1 と cuDNN を導入。

STEP

FaceFusionを入手

git clone https://github.com/facefusion/facefusion.git

cd facefusionSTEP

必要なライブラリをインストール

pip install -r requirements.txt(環境によっては以下を追加)

pip install onnxruntime-gpuSTEP

起動

GUIモード(ブラウザUIを開く)で起動するには

python run.py gui起動後、ブラウザが自動で開く

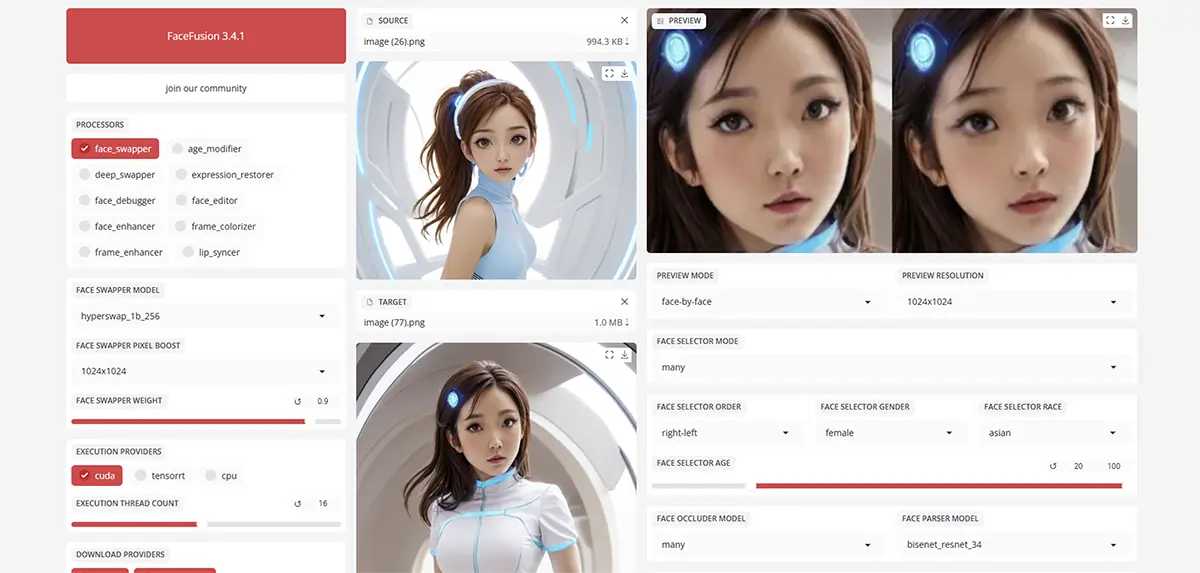

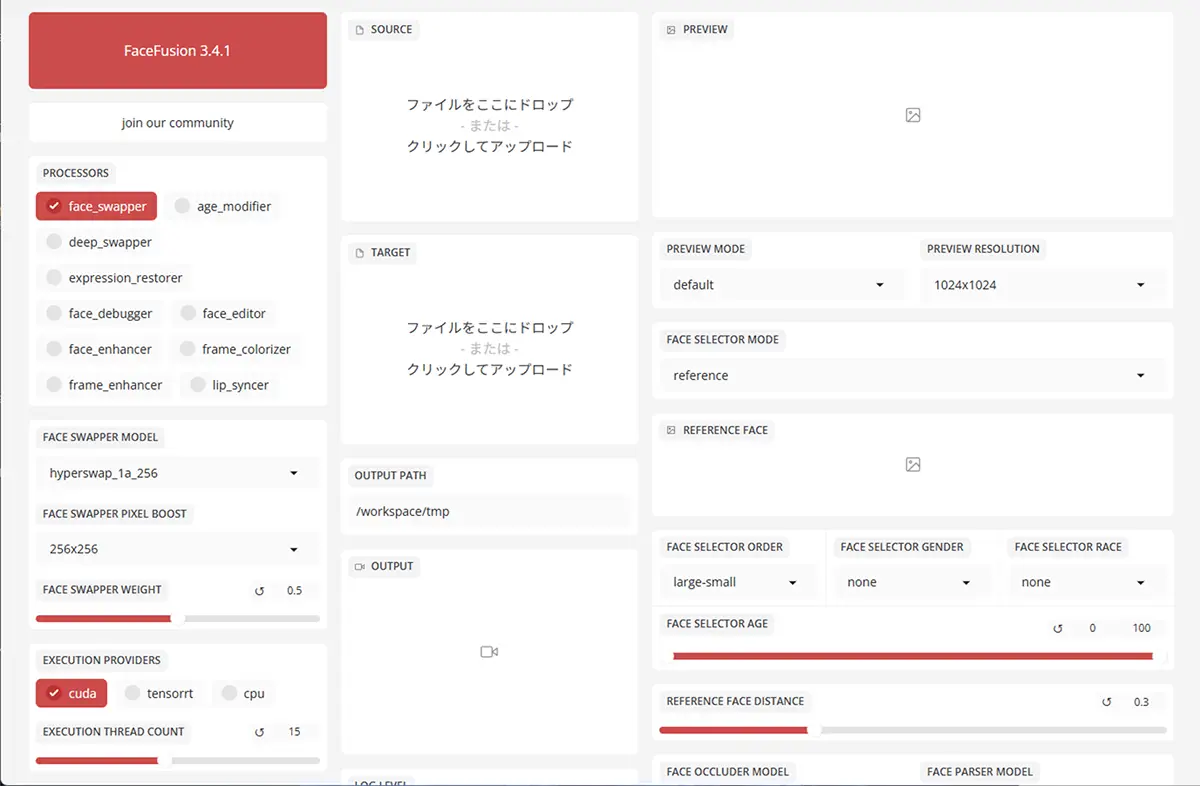

http://127.0.0.1:7860/GUIの使い方(v3.4.1)

手順(静止画のFace Swap)

STEP

Source画像をアップロード

- はっきり顔が映っている正面のものが最適。

- 顔が小さかったり角度が大きいと、認識されないことがあります。

STEP

Target画像をアップロード

ここに「Sourceの顔」が置き換わります。

STEP

Modelを選ぶ

- 例:

inswapper_128.onnx→ 最も自然で高品質(推奨)simswap.onnx→ 少し古いが速い

- v3.4.1では

inswapper_128がデフォルトで最も安定しています。

STEP

Face Detection & Alignment をオン

- 「顔を検出して正しい向きに合わせる」設定。

- 自然な結果を得たいときは

RetinaFace+Face Alignmentを有効にします。

STEP

Run / Generate

「Process」ボタンを押して結果を確認。

FaceFusion 3.4.1の基本構成

| 項目 | 役割 |

|---|---|

| Source | 「入れ替えたい顔」=入れる側の顔(顔の提供元) |

| Target | 「置き換えたい画像」=入れられる側(背景や身体など) |

| Model | どの顔変換アルゴリズムを使うか(品質・速度に影響) |

| Face Enhancer | 変換後の顔を修正(ぼけ防止・補正)する |

| Segmentation Mask / Blending | 境界の自然さを制御(顔の繋ぎ目など) |

設定

1. Processors

face_swapper

- 役割:基本の顔置き換え。

- 特徴:

- 入れ替えたい顔(Source)を対象画像(Target)にマッピング

- 誰の顔かハッキリわかるように置き換える

- 備考:一番最初に実行するといい

age_modifier

「顔をスワップする時に、元画像(ターゲット側)と年齢差が大きいと破綻しやすい問題」を軽減するための調整パラメータです。

- 役割:顔の年齢調整

- 特徴:

- 若返らせる/老けさせるなどの変化が可能

- 顔特徴は保ったまま年齢感を調整

- 使いどころ:

- キャラクターや人物を年齢差でバリエーション生成したい時

※age_modifier を使うと、入力顔側に「ターゲットの年齢層に寄せる」補正が掛かり、破綻が減ります。

deep_swapper

- 役割:DeepFake寄りの顔スワップ

- 特徴:

- 滑らかで自然な合成が可能

- 顔特徴が少し弱まる場合あり

- 備考:face_swapperより後に置くと自然さが増す

expression_restorer

スワップ後の顔に、元のターゲット画像の表情(口角・目・頬の動きなど)を復元する機能

- 役割:表情補正

- 特徴:

- 元の表情や笑顔・口の動きなどを復元

- 顔の違和感を減らす

- 使いどころ:

- 動画や表情差分で自然さを重視したい時

| 値 | 効果 |

|---|---|

| 0.0 | 無効(表情を復元しない) |

| 0.2〜0.4 | 軽く表情を寄せる |

| 0.5〜0.7 | 適度にターゲット表情を再現(おすすめ) |

| 0.8〜1.0 | 強めに復元。誇張されることもある |

併用するとさらに綺麗になる設定

| blend_weight(ブレンド強度) | 表情復元と一緒に調整すると、違和感が激減。 |

|---|---|

| face_debugger(顔形状補正) | shape を 0.2〜0.4 ほど追加すると自然な輪郭に。 |

| age_modifier | 年齢差がある場合は合わせて調整するとさらに破綻が減る。 |

face_debugger

- 役割:デバッグ用

- 特徴:

- 顔検出や置換の過程を可視化

- マスクや検出ポイントを確認可能

- 使いどころ:

- 初めての顔や難しい角度の画像を処理するとき

- 備考:最終生成には通常OFF

face_editor

- 役割:手動または自動で顔の微調整ができる。

- 特徴:

- 顔の位置や表情を微調整

- 不自然な部分を補正できる

FACE MASK TYPESを併用する事で、さらに細かく顔のパーツごとの制御をする事が出来る。

face_enhancer

- 役割:顔ディテール補正

- 特徴:

- 目・口・肌のディテールを強化

- 使いどころ:

- 最終出力を高画質にしたいとき

Face Enhancer(顔補正)を有効にすると、以下の機能が使える

RestoreFormer(自然な肌質)

GFPGAN(くっきり系・アニメ寄り)

CodeFormer(輪郭強調タイプ)

frame_colorizer

- 役割:動画のフレームや静止画を着色

- 特徴:

- 白黒や淡い画像に色をつける

- 使いどころ:

- 古い動画やモノクロ素材のカラー化

frame_enhancer

- 役割:フレーム全体の画質向上

- 特徴:

- シャープネスや解像度改善

- 背景や顔以外の部分も鮮明に

lip_syncer

- 役割:口パク同期

- 特徴:

- 音声に合わせて口の動きを調整

- 使いどころ:

- 動画の声に合わせた自然な口の動きを作りたい時

PROCESSORS の優先度

- 順番が大切

- 基本は

face_swapper → deep_swapper → expression_restorer → face_enhancer - ただし、

deep_swapperと併用すると干渉する場合がある - デバッグ系や補助系は最後または必要時に挟む

- 基本は

- 処理が多いほど時間がかかる

- 特に deep_swapper / frame_enhancer / lip_syncer は重め

おすすめ構成:

face_swapper

face_enhancer

expression_restorer(必要なら) 未来

未来まずはシンプルに確認するのがおすすめですよ!

2. FACE SWAPPER WEIGHT(顔の置き換え強度)

0.5→ これは「半分だけ入れ替える」状態です。

値を 0.7~1.0 に上げると、よりしっかりと入れ替わります。

おすすめ:

まず 0.8位 に設定して試していく。

3. FACE SELECTOR MODE

reference→ このモードでは、REFERENCE FACE に指定した画像をもとに入れ替える。

ただし REFERENCE FACE が未設定 or 検出失敗すると効果が薄くなる。

確認方法:

- 「REFERENCE FACE」欄にきちんと参照画像が読み込まれているか?

- その画像で顔が認識されているか?(

face_debuggerをONにして確認)

4. FACE DETECTOR SCORE

0.5→ 顔検出のしきい値。高すぎると顔を認識できず、処理がスキップされることがあり。- 0.3〜0.4 に下げてみると改善する場合があり。

5. REFERENCE FACE DISTANCE

0.3- → 顔が似ていない場合、この値が低いと「別人」と判断され、入れ替えが弱まる。

- 顔の骨格が違う場合は 0.4〜0.6 に上げてみる。

6. FACE MASK BLUR / PADDING

FACE MASK BLUR 0.3- 境界が自然に見える

ぼかしすぎると「元の顔が残る」ように見えることも。

対策:

→ FACE MASK BLUR 0.0 くらいを試してみると、どの範囲が置き換わっているか確認しやすい。

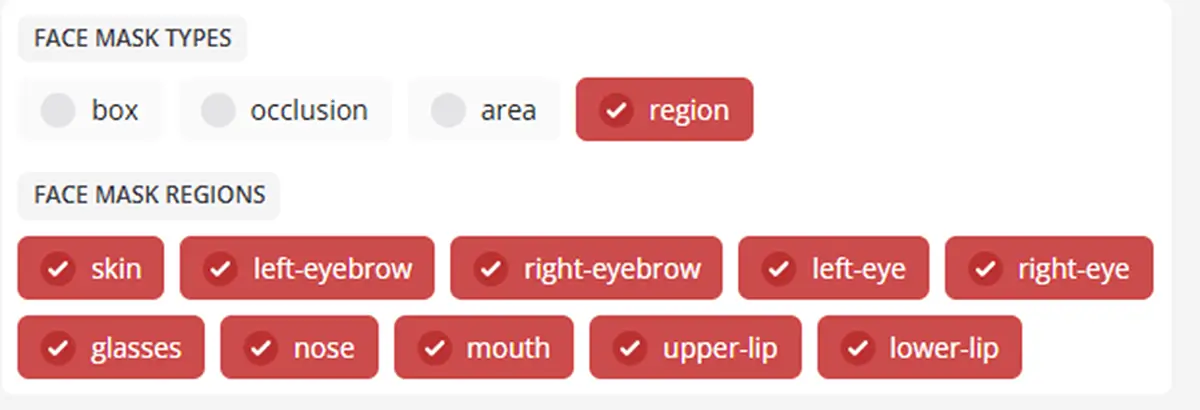

7. FACE MASK TYPES(マスクの種類)

マスクの作り方そのものを選ぶ設定。

どの「形状・範囲・アルゴリズム」でマスクを作るかを指定します。

| 種類 | 意味・特徴 |

|---|---|

| box | 顔検出範囲(矩形ボックス)をそのままマスク。 シンプルだが精度は低い。調整なしで速い。 → ざっくり顔全体を置き換えたい時に。 |

| occlusion | 顔の「遮蔽物(手や髪など)」を考慮したマスク。 物体が顔の前にあるとき、重なりを除外して自然な合成を目指す。 |

| area | 顔領域(スキン検出など)に基づく広めのマスク。 フェイススキンの面積を解析して作るタイプ。 → 口や頬など、肌面全体を交換したい時。 |

| region | 顔パーツごとの領域(眉・目・鼻・口など)を個別に使うモード。 後述の FACE MASK REGIONS と連携して、細かいパーツ単位のマスクを選べます。 |

FACE MASK AREAS(顔の上下範囲の指定)

マスクの「縦方向の範囲(エリア)」を限定する設定。

特に region や area タイプと併用します。

| 設定 | 意味 |

|---|---|

| upper-face | 額〜目のあたり(上半分)だけマスク対象。前髪などが影響しやすい部分。 |

| lower-face | 鼻〜口・顎周り(下半分)だけマスク対象。笑顔や口の動きを変えたい時に。 |

| mouth | 口の周辺だけをマスク。リップシンクや表情修正などに。 |

例:口元だけを別キャラに差し替えたい時 →FACE MASK TYPE = regionFACE MASK AREAS = mouth

8. FACE MASK PADDING(上下左右の余白)

マスクのサイズを上下左右に広げたり縮めたり する。

▶ FACE MASK PADDING TOP

おでこ方向(上側) のマスクを広げたり狭めたりする。

- プラス(数値↑) → おでこ〜髪の部分まで含めて広げる

- マイナス(数値↓) → 額を削って、狭くする

→ 眉から下だけ置き換えたい時に有効

▶ FACE MASK PADDING RIGHT

顔の右側(向かって左側) の領域を広げたり縮めたりする。

- プラス → こめかみ・頬の横まで広げる

- マイナス → 右側を削って狭くする

→ 側面の髪が変に置き換わる時に調整

▶ FACE MASK PADDING BOTTOM

あご方向(下側) のマスク調整。

- プラス → 顎下〜首元まで広げる

- マイナス → 顎より上だけ置き換える

→ 顎が不自然になる場合に縮めると改善

▶ FACE MASK PADDING LEFT

顔の左側(向かって右側) のマスク調整。

- プラス → 左側の髪・頬の範囲を広げる

- マイナス → 左側を削る

調整(実用目安)

| 問題 | 調整する方向 |

|---|---|

| おでこや髪の境界線が不自然 | TOP を + |

| 髪が大きく変形する | 左右(LEFT/RIGHT)を – |

| 顎が崩れる/長く見える | BOTTOM を – |

| 顔の横が浮いて見える | 左右を微調整(±数値) |

- ±5 〜 ±20 の範囲で十分

- 激しく変わる場合は ±30 くらいまでは使える

- 極端に±100などにするとマスクが破綻して不自然になる

9. VIDEO MEMORY STRATEGY

strict→ VRAMが少ないGPUでは、強制的にメモリ制限がかかって処理が軽減される。- VRAM に余裕があるなら

moderateに変更すると安定度と精度が上がる。

おすすめ設定

| 項目 | おすすめ値 |

|---|---|

| FACE SWAPPER WEIGHT | 0.8〜1.0 |

| FACE DETECTOR SCORE | 0.35 |

| REFERENCE FACE DISTANCE | 0.5 |

| FACE MASK BLUR | 0.0〜0.1 |

| VIDEO MEMORY STRATEGY | moderate |

出力フォルダ構造(デフォルト)

facefusion/

├── input/

│ ├── source.jpg

│ └── target.jpg

├── output/

│ ├── result_001.jpg

│ └── result_001_log.txt

└── models/

├── detection/

├── swap/

└── enhancement/| 分類 | 向いている用途 | 向いていない用途 / 注意点 |

|---|---|---|

| 画像タイプ | 静止画(1枚単位) | 動画や複数フレームの顔交換 |

| 顔の角度 | 正面顔・ほぼ正面 | 横顔・斜め顔・複雑な角度 |

| 表情 | 自然な表情、微笑み程度 | 強い表情変化(大口・しかめ面など) |

| 背景 | 単純な背景 | 複雑・人物が多い背景 |

| 解像度 | 中〜低解像度(512〜1024px程度) | 高解像度(2K以上)や精細なディテール要求 |

| 処理後補正 | ある程度の補正は不要 | 高精度・自然補正が必要な場合は Real‑ESRGAN / GFPGAN / CodeFormer との併用推奨 |

| ユーザー層 | 手軽に顔交換したい人 | 本格的・研究用途 |

出力の画像解像度が1024pxまでなので、

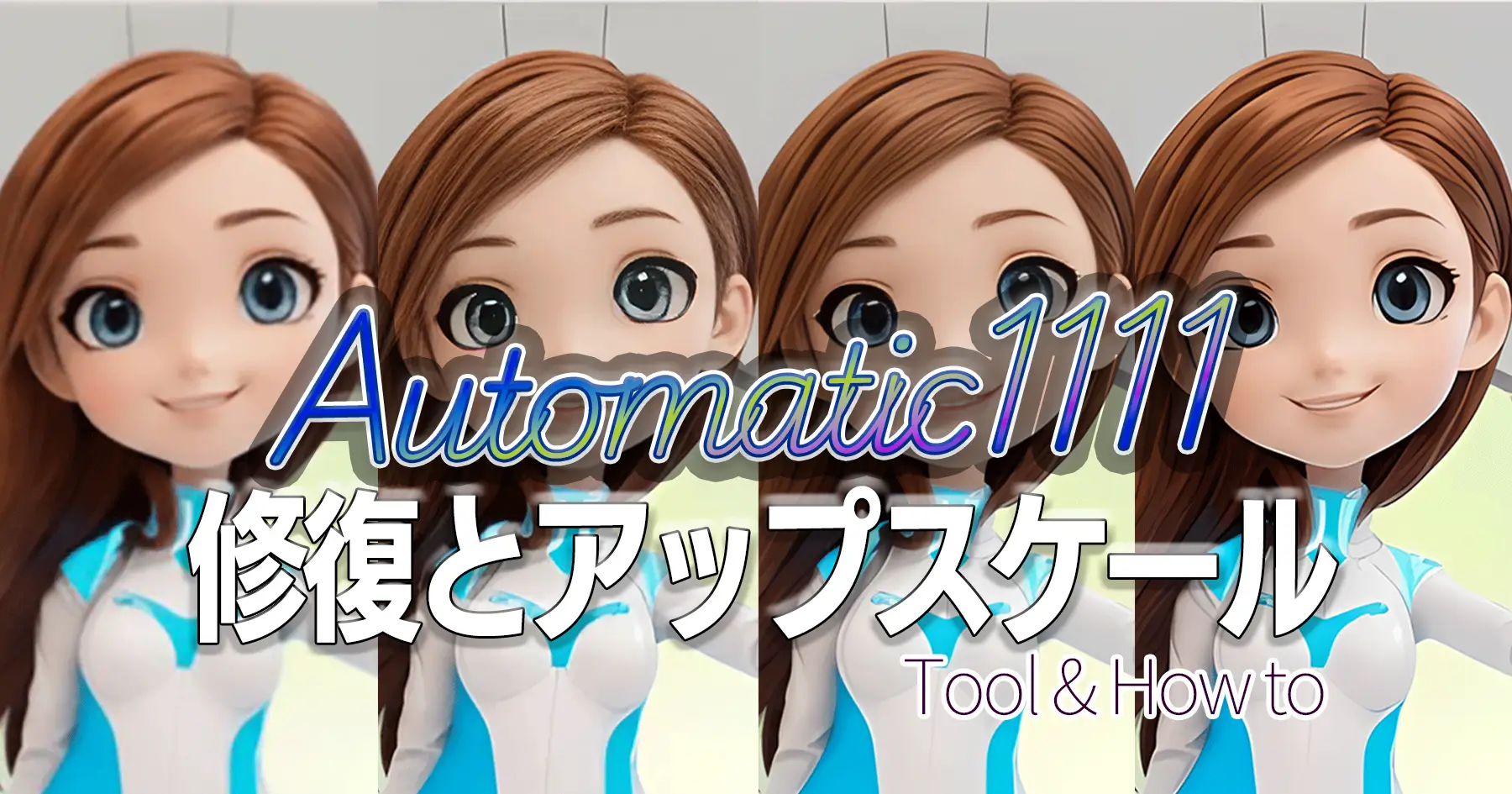

アップスケールや、補正ツール(Real‑ESRGAN / GFPGAN / CodeFormer など)との併用がおすすめです!

アップスケールや、補正ツール(Real‑ESRGAN / GFPGAN / CodeFormer など)との併用がおすすめです!

あわせて読みたい

Automatic1111での画像の修復とアップスケールをする方法 A1111での顔画像と画像全体の修復、アップスケールの方法 GFPGAN(顔修復・補正モデル) — GitHubリポジトリ: https://github.com/TencentARC/GFPGAN GitHub CodeFormer…

Tips

- 動画を扱う場合

フレームごとにスワップするため、非常に時間がかかる。--batch-size 2などで並列数を増やすと高速化可能(VRAMに余裕があれば)。 - 顔を選択して限定的にスワップ

GUIの「Face Selector」でターゲットを選ぶと、複数人写っている画像でも1人だけ置換できる。 - 出力補正(Postprocess)

“Face enhancer” を併用することで、肌質や解像度を補正できます(Real-ESRGANに近い効果)。

あわせて読みたい

画像生成AIでキャラクターの顔を維持しつつ、再生成する!【5つの方法】▶ 2025.10.16更新 顔だけ変える方法が知りたい=この顔で生成したい すごくいい画像が出来た!…けど、顔が好みじゃない。このキャラの違うポーズが欲しい! この 身体 に、かわいいあの子…