自動タグ付けとLoRA学習の簡単な方法【Train FLUX LoRA with Ease(Ease for FLUX)】

目次

Train FLUX LoRA with Ease(Ease for FLUX)

「Train FLUX LoRA with Ease」は、FLUX 専用に最適化された「Stable Diffusion WebUI の FLUX版ミニUI」 のような存在で、

一括で効率的に学習用のデータセットを構築できる上に、FLUXを手軽に操作し、LoRAの学習や推論を行うことができます。

- Gradioベース → Automatic1111 や Kohya_ss GUI と同じく、ブラウザで操作できるWeb UI を提供している。

- FLUXモデル専用のUI → Stable Diffusionとは違う仕組みのFLUXを「なるべく簡単にローカルで動かせる」ように設計されている。

- キャプション付与や整理(データセット準備を楽にする機能)

- LoRAの学習(簡易的なUIで学習可能)

Ease for FLUXは、「本格的にLoRAを鍛える」というよりも、

「FLUX向けに小規模LoRAをさっと作る」「学習用画像のキャプション付けを効率化する」といった、

前処理・補助的な用途に強みがあるツールです。

LoRA学習の特徴(Ease for FLUXの場合)

Ease for FLUX のLoRA学習は 「簡単に試せる」 という位置づけで、Kohya_ss や sd-scripts に比べると 自由度は低めですが、

「短時間でお手軽にLoRAを作ってみたい」「Fluxモデル用にまず試したい」という人にはおすすめです。

- GUIベースなので、コマンドラインを打たずに設定できます

- 画像データをドラッグ&ドロップで投入できるようになっていることが多い

- 学習設定項目は絞られている(簡易化)

- 例:学習ステップ数、学習率(learning rate)、バッチサイズなど

- Kohya_ss や LyCORIS で設定できるような細かいパラメータ(正則化や高度なスケジューラ)は非対応の場合が多い

- 基本的なLoRAは十分作れるけれど、細かいチューニングはできない。

必要なPCスペック

推論(画像生成)目的の場合

- GPU最低限:NVIDIA RTX 3060(12 GB VRAM)、メモリ 32~64 GB

→ Flux DEV モデル1枚生成に約 2 分 - より高速な環境:RTX 4060 Ti 級

- 高性能の場合:RTX 4090 など(VRAM 24 GB〜)は高速で快適

※ローカル環境への各種インストールの手間を省きたい場合や、PCのスペックが足りない場合には、各種機能がセットアップされたテンプレートを使用できるRunpodがおすすめです。

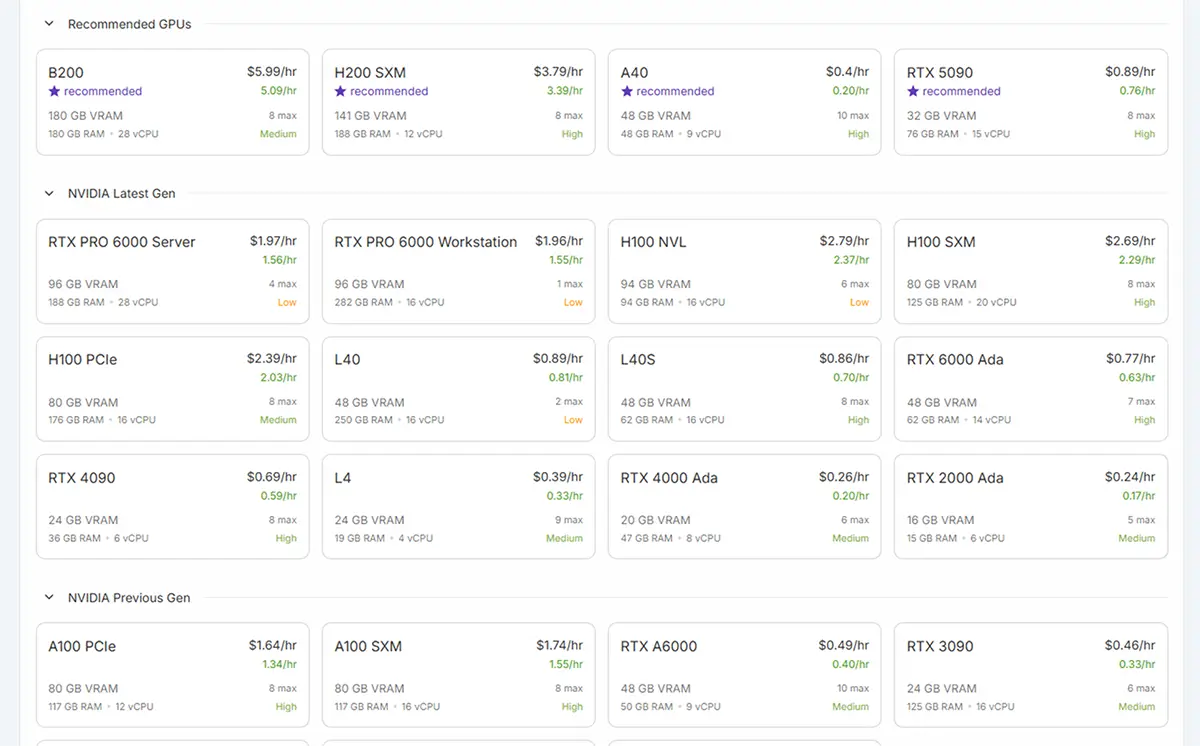

クラウドのGPUのRunpod

【RunPodの料金と使い方】Stable Diffusionなどで画像生成やLoRA学習をする方法【②実践編】 RunpodでStable Diffusion系画像生成やLoRA学習をする方法 Stable DiffusionやLoRA学習では、長時間GPUをフル稼働させるため、発熱や電源の安定性が大きな課題になりま…

全体的スペック(公式や情報サイトより)

モデル別要件(Flux 1.0シリーズ)

| モデルタイプ | GPU VRAM 必須 | システムRAM | ストレージ |

|---|---|---|---|

| Pro | 24 GB 以上(A40/A6000など) | 64 GB 推奨 | SSD 500 GB 以上(1 TB 推奨) |

| Dev | 16 GB 以上 | 32 GB | – |

| Schnell | 8 GB 以上 | 16 GB | – |

Train FLUX LoRA with Easeの使用方法

【ローカル】での使用

1. 必要な環境の準備

まず、以下の手順で必要な環境を整えます。

リポジトリのクローン

以下のコマンドでリポジトリをクローンします。

git clone https://huggingface.co/spaces/autotrain-projects/flux-lora-ease

cd flux-lora-ease依存関係のインストール

次に、必要なPythonパッケージをインストールします。

pip install -r requirements_local.txtAI Toolkitのインストール

AI Toolkitをインストールします。

git clone https://github.com/ostris/ai-toolkit.git

cd ai-toolkit

git submodule update --init --recursive

pip3 install torch

pip3 install -r requirements.txt

cd ..Hugging Faceへのログイン

Hugging FaceのCLIを使用してログインします。

huggingface-cli login※LoRAをHugging Face Hubにアップロードするために必要です。

2. Web UIの起動

以下のコマンドで、GradioベースのWeb UIを起動します。nodeshift.com+5GitHub+5gradio.app+5

python app.pyこれで、ブラウザ上でFLUXのインターフェースが表示され、画像のアップロードやLoRAの学習、推論などの操作が可能になります。

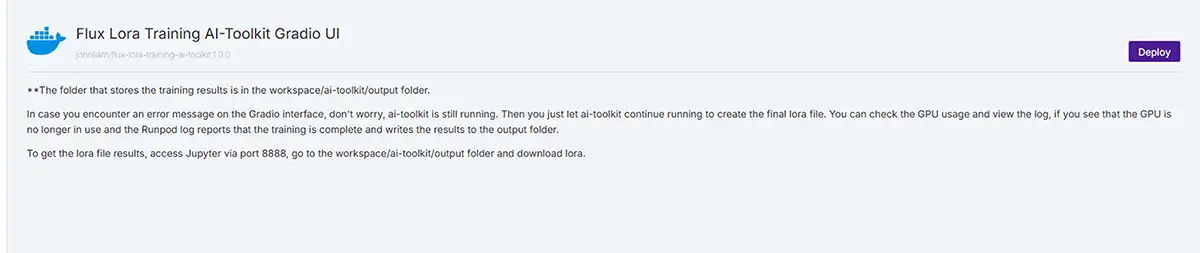

【Runpod】での使用方法

Runpodの使用方法は以下の記事をご覧ください。

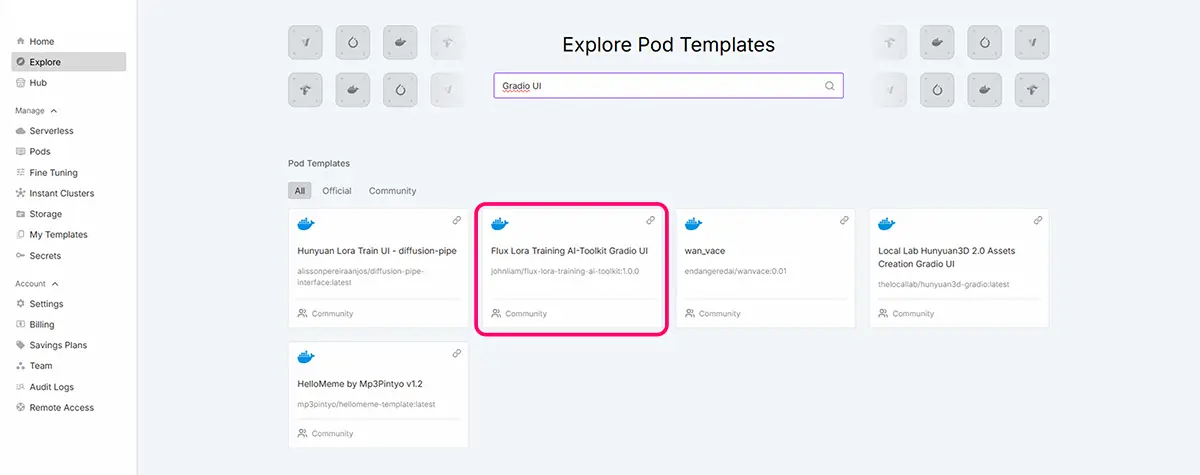

今回使用する”Train FLUX LoRA with Ease”は、Runpodのテンプレート場合は、GradioUIや、Flux loraなどと検索すると出て来ます。

GPUは、先程の【必要なPCスペック】の項目を参考に選び、必要な場合は、Network Volumeを使用します。

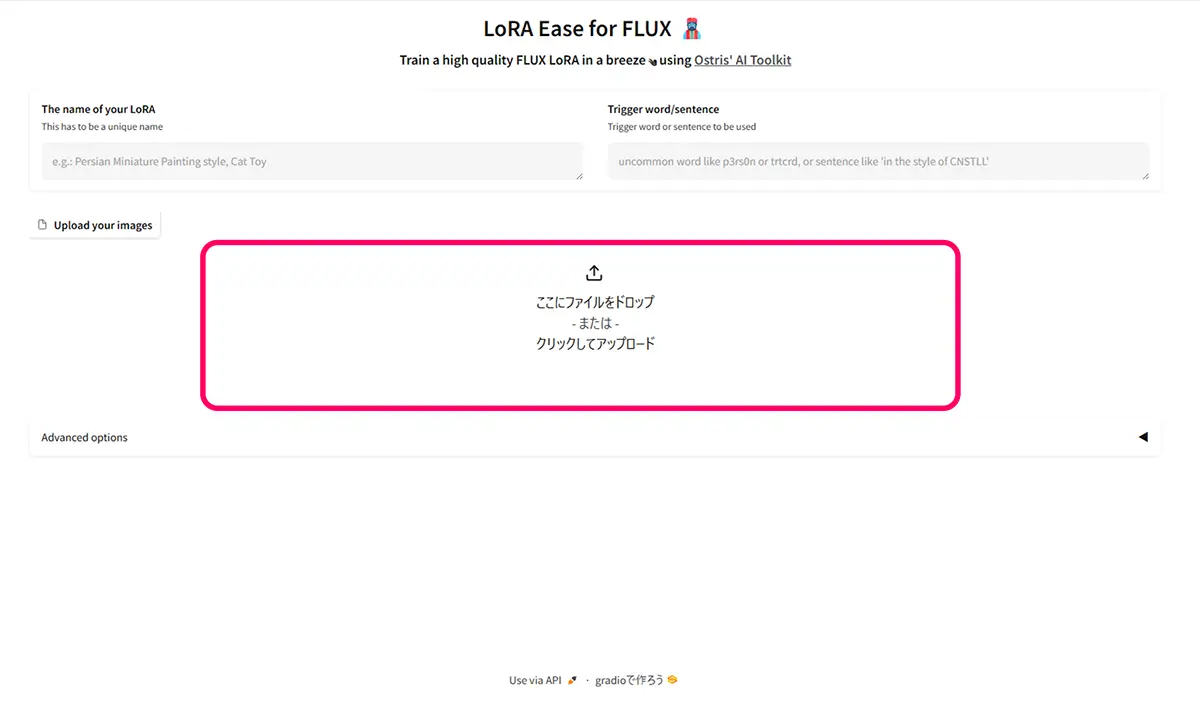

Ease for FLUXのWeb UIでは、画像に対してタグ付けを行うことができる為、LoRAの学習の為のデータセットを効率的にすることができます。

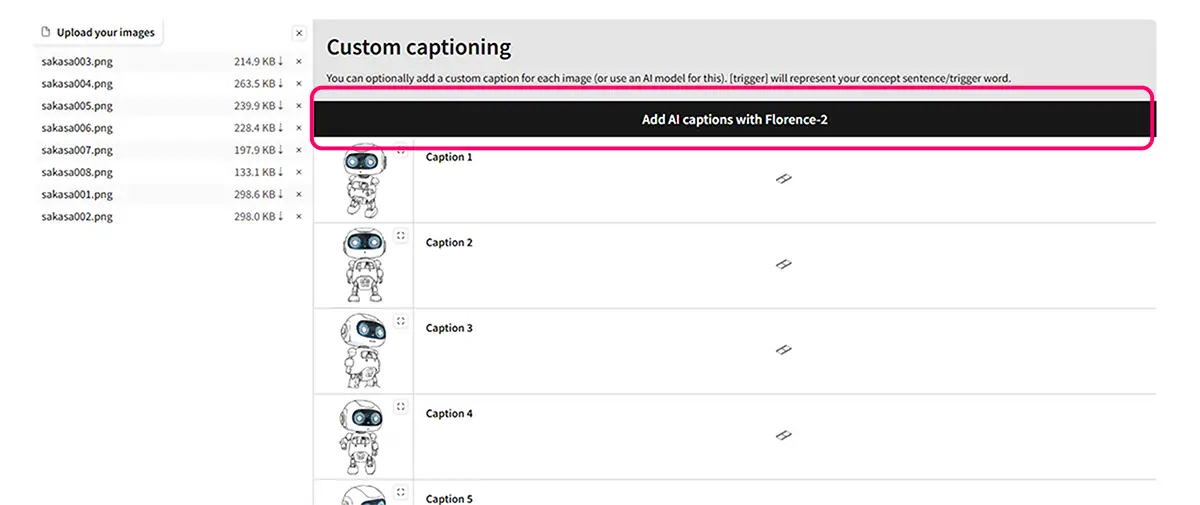

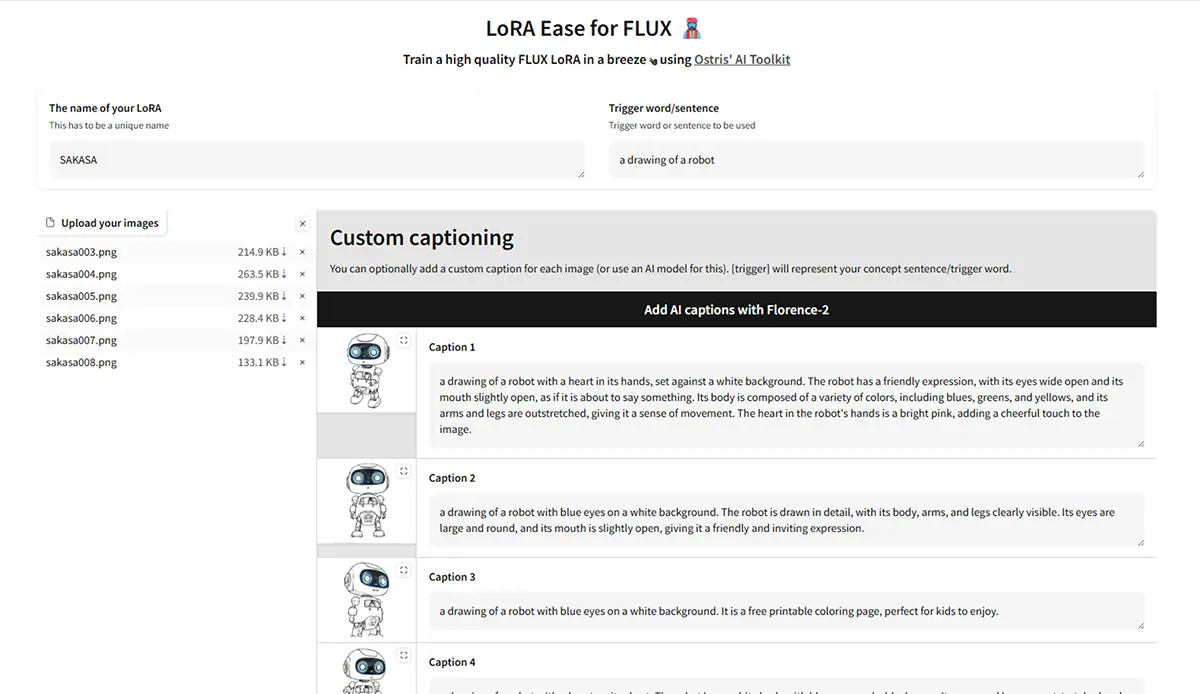

- 画像のアップロード

「Upload your Image」セクションから、タグ付けしたい画像をアップロードして、読み込まれたら、Add AI captions with Florence-2のボタンをクリックします。

2, タグの出力

アップロードした画像に対して、関連するタグが出力されます。

このままEase for FLUXで、LoRA学習をする事も可能ですが、本格的に学習する場合は、 必ず手直し(不要タグ削除・追加・並び替え)してから使用します。

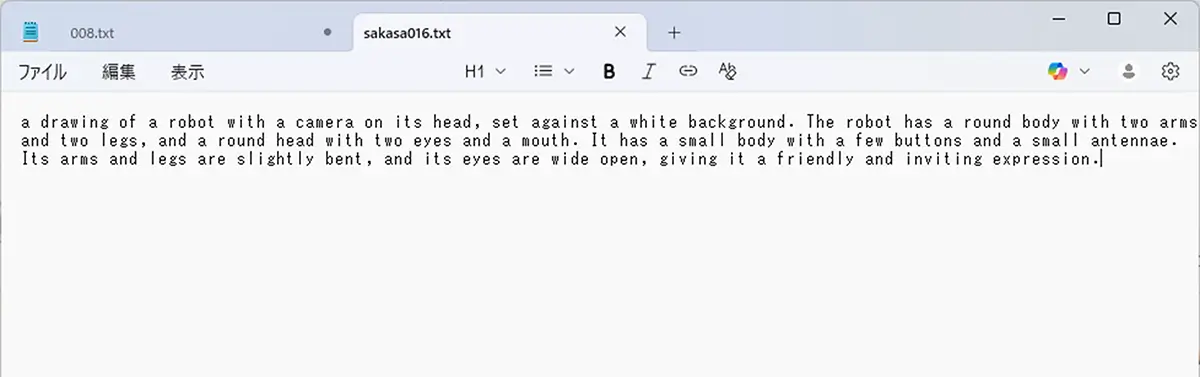

3. タグの保存

基本的に Ease for FLUXで「タグだけを生成」した場合、自動で画像ファイルに埋め込まれるわけではありません。

以下の場合は、テキストエディタに保存します。

- 自動生成タグはノイズが多い(余計な属性や作品名が入る)為、テキストエディタで編集してから使用する場合。

- 編集前と編集後を比較できるようにしておいて、あとで「どのタグ修正が効いたか」振り返るなどの用途。

- 将来、別のLoRA学習に流用する場合。

「タグだけを生成」する場合や、テキストエディタで編集してから使用する場合の操作方法

自動生成されたタグを、テキストエディタで編集(手を加える)する場合。

- 順序を整理(強調したいタグを前に)

- 不要なタグを削除(例:

score_9やrating:safeなど) - キャラ名や固有情報を追加

その後、編集済みの.txtをLoRA学習で使用します。

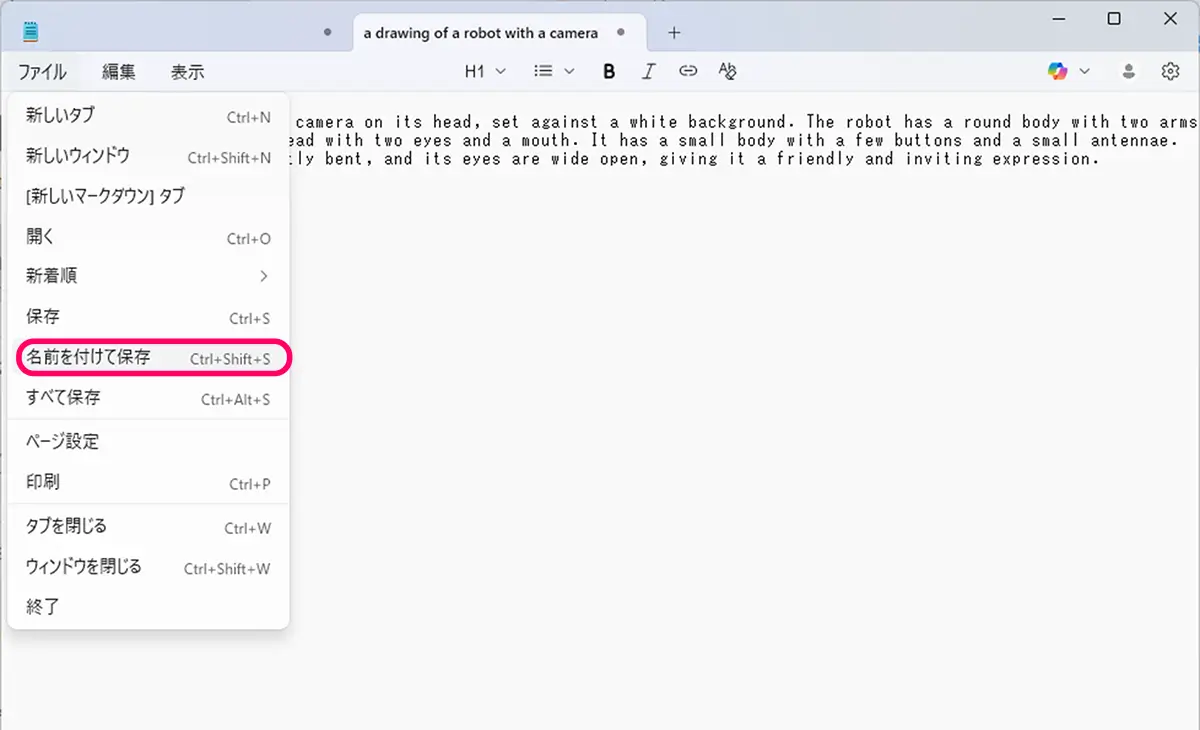

未来

未来メモ帳などの**テキストエディタを開いて、コピペしてテキストタグを作成します。

エンコード、UTF-8で保存します。

**テキストエディタ

メモ帳(Windows標準)

Notepad++(Windowsで人気)

VS Code(Win/Mac/Linux、拡張機能豊富)

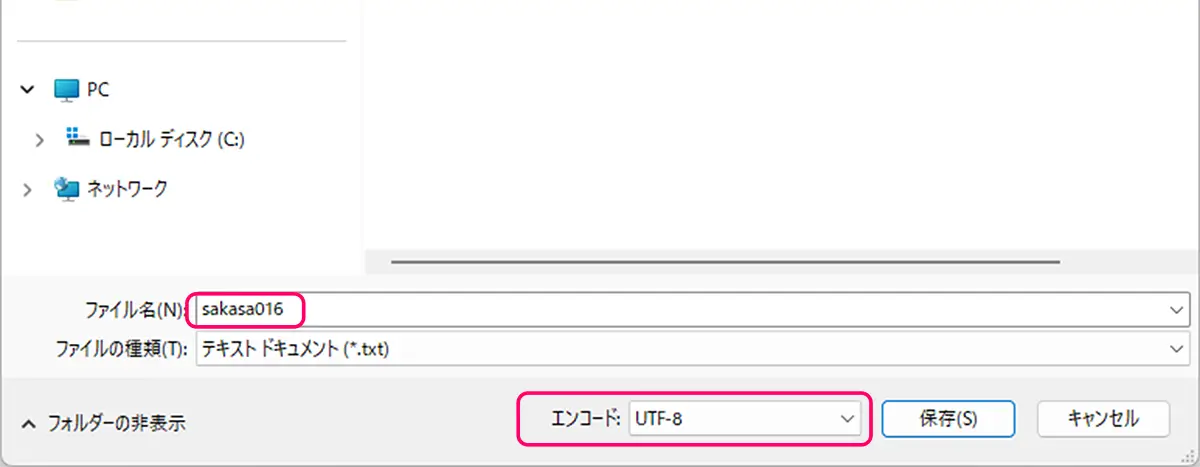

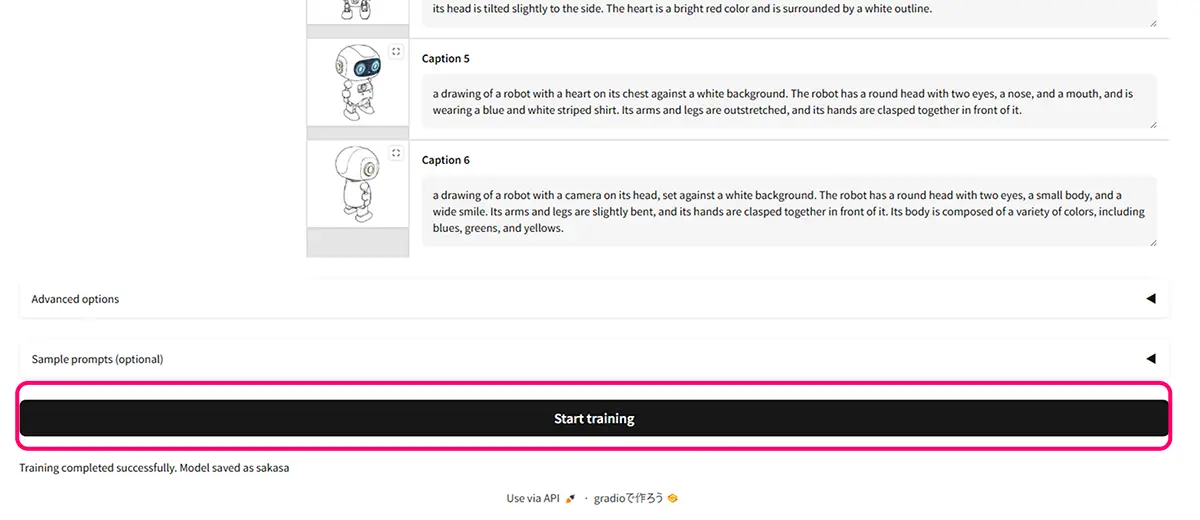

タグの生成後にそのままLoRA学習を行う場合

The name of your LoRA :名前を付ける。

Trigger word/sentence:毎回プロンプトに入力する必要あり、短い固有名詞にすると使いやすい。

※トリガーワードは学習データのキャプションにも必ず含める必要があります。

Ease for FLUX の Steps / Learning Rate / LoRA Rank 。

まずはこのレシピ(初回の基準)

- LoRA Rank:32(迷ったらここ。必要に応じて64へ)

- Learning Rate:1e-4(崩れ気味なら 5e-5 に下げる)

- Steps:2000–3000(データが少ないほど上げ過ぎない)

データ枚数別の目安

| 画像枚数 | Steps目安 | Rank目安 | LR目安 |

|---|---|---|---|

| 10–20枚(少量) | 1500–2500 | 32–64 | 1e-4(崩れたら5e-5) |

| 30–60枚(中量) | 2500–4000 | 32–64 | 1e-4 |

| 80枚以上(多め) | 4000–6000 | 32–64(必要時128) | 5e-5–1e-4 |

結果を見て微調整。

調整のコツ(症状→調整)

- 顔やポーズが崩れる / 発散する → LRを 1e-4 → 5e-5 に下げる、Stepsを少し減らす、Rankを下げる(64→32)。

- 似度が弱い・指定しないと出ない → Stepsを +500〜+1500、Rankを 32→64、学習プロンプトで特徴語を増やす。

- 学習データに引っ張られすぎる(背景まで固定化) → Stepsを-500〜-1000、Rankを下げる、データの多様性を増やす(背景バラけさせる)。

Sample prompts (optional) :学習したLoRAを テスト生成するときに使うプロンプト例 を、Ease for FLUXのUIに保存しておける機能。

Flux系LoRA学習の学習時間目安

- 画像20〜30枚 / Steps 2000 / Rank 32

→ RTX 4090 で 約10〜20分

→ A100 で 約 5〜15分 - 画像50枚以上 / Steps 5000 / Rank 64

→ RTX 4090 で 約30〜50分

→ A100 で 約20〜40分

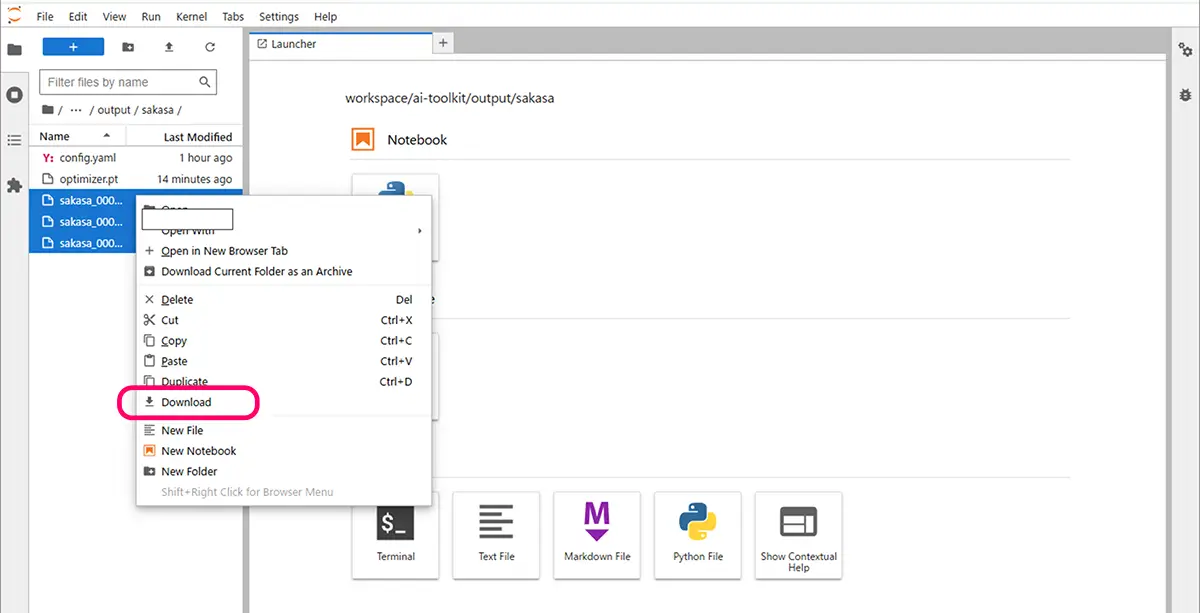

作成したFluxモデルの自作LoRA(.Safetensors)をダウンロードして完了です。

RunPodでのFluxモデルの使用

作成したFluxモデル(.Safetensors)は、Stable Diffusion WebUI Forgeなどで使用してみましょう。

※RunPod上でFluxモデルを使用する場合、Forge UIのFluxテンプレートを利用するのが便利です。

Kohya_ssでFLUX LoRAを本格的に作成する場合の選択肢

Kohya_ssでFlux対応のブランチをクローンしてLoRAトレーニングを行う方法

標準のKohya_ssにはFLUXのLoRAトレーニング用設定が含まれていません。

その為、Flux対応のブランチ(例: sd3-flux)をクローンするか切り替えて使う必要があります。

Flux対応ブランチを入手・切り替え

git clone --single-branch --branch "sd3-flux" --recursive https://github.com/bmaltais/kohya_ss.gitまたは、既存リポジトリで git checkout sd3-flux.1 を実行します。引用元:Reddit。

Kohya GUIを用いてFLUXモデルのLoRAトレーニングを行う方法

Kohya GUI(Kohya_ss にGUIを付加したインターフェース)のインストールと環境構築

- Python、CUDA、Git、FFmpegなどの必要ソフトを準備

- stablediffusion3.netThinkDiffusionGUIを用いたFlux LoRAの設定とデータ準備まで簡略化しているチュートリアルが豊富

ThinkDiffusion版(2025年更新)にも、Flux1-devモデルへのLoRAトレーニングをKohya GUIで行う流れが整理されています。

本格的なLoRA学習の為のデータセット

本格的なLoRA学習の為の**データセット(画像とテキストタグ)の作成については以下の記事をご覧下さい。

SAKASA AI

【自作イラストをLoRA化】画像とテキストタグ(キャプション)の準備からフォルダ構成まで徹底解説 | SAKAS… LoRA学習に必要なデータセットの作り方を完全ガイド。画像選定・テキストタグ(caption)の付け方・フォルダ構成まで、作例付きで丁寧に解説。