ComfyUI + Wanで動画生成!i2v・t2vをRunPodで簡単に使う方法

i2vで”静止画キャラから動画生成”とt2vで”テキストから動画生成”

目次

WANとは?

Wanは、VACE内部で使われる 動画生成モデルで、

VACE(Video-Audio-Content Engine)は、中国の大手テック企業 Alibaba Group(阿里巴巴集団)の、AI研究部門「DAMO Academy(達摩院)」開発した 統合的な動画生成・編集モデル群です。

4Kクオリティの動画生成や、非常に自然な物理的動き・質感表現が可能で「映画級」と評されています。

- 強み

- 1080p〜4K 出力に対応

- 実写に近い自然な動き

- Apache 2.0 ライセンス(商用利用OK)

- 注意点

- モデルの重み(学習済みデータ)はまだ一般公開されていない

- 現状は **公式クラウドサービス または ComfyUIの専用ノード経由(API利用) でのみ使用できます。

- ローカルPC単体では実行できない(非常に高いGPU性能が必要になる為。)

※当サイトのトップページでもWANで作成した動画を使用しています。作成

現状はクラウド限定ですが、商用利用も可能なライセンスで発表されており、将来的には Hugging Face などでの公開が期待されています。

「最新のリアル志向AI動画」を試したいクリエイターに注目されています。

| 呼称 | 意味・内容 |

|---|---|

| VACE | Video-Audio-Content Engine の略称。動画生成・編集を1つのアーキテクチャで統合するAlibabaのフレームワーク全体を指す |

| Wan | VACE内部で使われる 動画生成モデルのシリーズ名。Stable Video Diffusionに近い役割 |

| Wan2.1-VACE | 最新のVACE対応モデルの1つで、「統合エンジン(VACE)」に対応した動画生成モデル(2.1はバージョン番号) |

| Wan Video | 多くの場合、「WanモデルによるVideo生成機能」のことを指し、ComfyUIではi2v/t2vモードとして扱われる |

WANの機能

1. R2V(画像→動画)

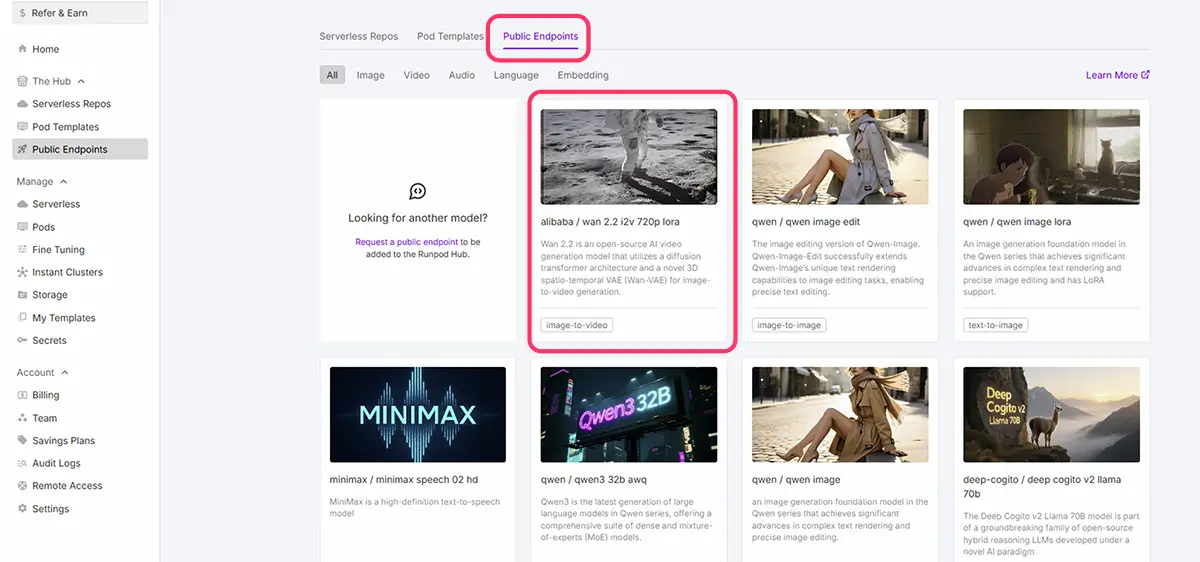

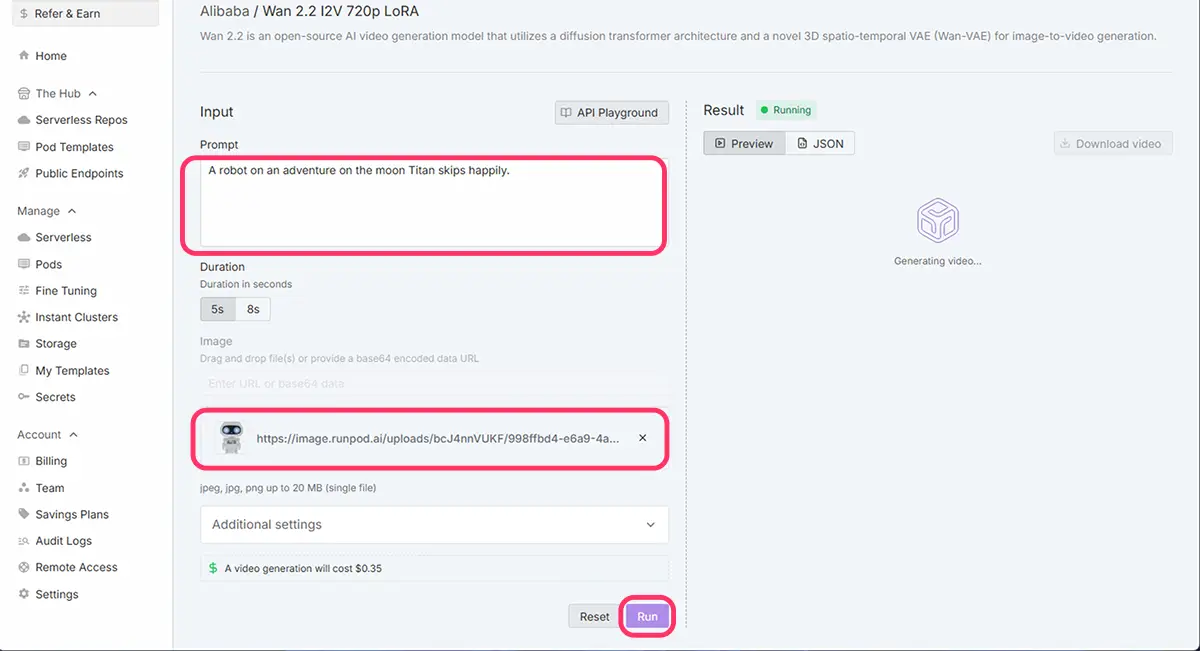

右は、Runpodの

Public Endpoints内の

Wan 2.2 I2V 720pで

左の画像から、ワンクリック生成した8秒動画。

この、画像からの動画生成では、プロンプトのみを指定した。

生成時間は4分20秒

- 自作イラストを読み込んで、動きやアニメーションを付けられます。

- ComfyUI+VACEテンプレでは、ローダーノードに画像を指定し ▶ 実行。

2. MV2V(マスク付き動画編集)

- 動画の一部(例:人物)だけ選んでカラー変更・モーション追加が可能です。

- マスク付き入力で、選択範囲の「入れ替え」「加筆」「削除」など細かく編集できますalibabacloud.com。

3. V2V(動画→動画編集)

- 既存の動画を別のスタイルに変換(例:アニメ調、サイバーパンク風など)。

- 上書き変更、色調補正など、ComfyUIに搭載された動画編集ノードで実現できます。

- 動画の拡張やトランスフォーメーション

4. T2V(テキスト→動画)

- テキスト入力から動画生成。短いアニメーションクリップや動くロゴ作成に使えます。

- 簡単な「猫がジャンプする」等のプロンプトで動きを生み出せる。

5. ハイブリッドワークフロー

- たとえば「画像→動画」→「動画→ダイナミックカラー編集」という一連の処理を、すべて1つのノードフロー内で完結できます。

音声や字幕の生成・同期(Audio-aware)

その中に含まれる具体的な動画生成モデルが、最新版では Wan2.1‑VACE と呼ばれています。

AlibabaのAI”VACE”に関する深掘りはこちらをCLICK!

AlibabaがAIに力を入れている

Alibabaは単なるEC企業ではなく、近年では

- 大規模言語モデル(ChatGPT的な)「Qwen」シリーズの開発

- データセンター / クラウド(Alibaba Cloud)

- AIアート、生成画像、翻訳などの研究

に非常に力を入れています。

VACEは、その中でも**「動画分野の戦略的技術」**として位置付けられていて、Stability AIやRunway、Pikaなどの生成系企業に対抗する動きと見られています。

VACE(Wan2.1‑VACE)の元論文要約

Wan2.1‑VACEは、AlibabaのTongyi Lab(DAMO Academy)が開発したマルチモーダル動画生成・編集統合モデルですarxiv.org+5alibabacloud.com+5github.com+5。以下が主なポイントです

- マルチモーダル対応

テキスト・画像・動画・マスクという複数モーダルを統一フォーマットで処理し、幅広い動画タスクに対応hyper.ai+5arxiv.org+5linkedin.com+5。 - Video Condition Unit(VCU)

それぞれのモーダルをひとつの内部条件表現にまとめられるため、柔軟かつ簡潔なインターフェイス設計が可能arxiv.org+4the-decoder.com+4arxiv.org+4。 - 多様な動画タスクを統合処理

- T2V(テキスト→動画)

- R2V(画像→動画)

- V2V(動画→動画編集)

- MV2V(マスク付き動画編集 / 部分編集・補完)

のすべてを1モデルで扱える多機能性comfyui-wiki.comalibabacloud.com+8arxiv.org+8github.com+8github.com+1alibabacloud.com+1。

- 概念分離(Concept Decoupling)

編集したい部分と固定したい部分をしっかり分けて処理できる仕組みを搭載en.wikipedia.org+4the-decoder.com+4comfyui-wiki.com+4。 - 応用範囲が広い

短編動画、広告素材、映画向け効果・編集、教育用動画など、さまざまな用途に利用可能なユーティリティ性を持っています。

実際の表記例(GitHubや研究論文から)

- 「Wan2.1-VACE achieves unified generation and editing…」(論文より)

- 「We present VACE, a unified framework… powered by Wan models」(公式発表より)

- ComfyUIテンプレートでは「Wan2.1」 or 「VACE」どちらも登場し、実質的に同じものを指しています。

研究論文や発表は以下のような名前で出ています

- “Video and Audio Collaboration Engine (VACE)” by Alibaba DAMO

- GitHubやHuggingFaceにも公式ページがあります。

必要 VRAM から考える目安

GPU 選択の際の目安

| Wan モデル | 必要 VRAM目安 | RunPodで狙うGPU |

|---|---|---|

| Wan 2.1 / 1.3B (T2V, 480p) | 8GB〜 | RTX A4000 (16GB), RTX 3090 (24GB), RTX 4090 (24GB) |

| Wan 2.1 / 14B (480p~720p) | 16GB以上推奨(12GBでもギリ動く報告あり) | RTX A4000 (16GB), RTX 3090, RTX 4090 |

| Wan 2.2 / 5B (T2V/I2V) | 8GB〜(オフロード対応) | A4000 (16GB) でもOK、余裕を見るなら 3090 / 4090 |

| Wan 2.2 / 14B (I2V) | 約20GB必要(実例) | RTX 3090 (24GB), RTX 4090 (24GB), H100/A100 40GBクラス |

目的別おすすめ GPU

- お試し・低コスト重視

- RTX A4000 (16GB)

- Wan 1.3B / Wan 2.2 5B なら十分。

- ただし高解像度や14Bモデルは厳しい。

- コスパと安定性のバランス

- RTX 3090 (24GB)

- 14Bモデルもある程度動かせる。

- 720p動画や長めのシーケンスも可能。

- ハイエンド・速度重視

- RTX 4090 (24GB)

- 3090より処理速度が速い。

- 高解像度や大規模モデル向け。

- 研究・プロ用途(大規模モデル狙い)

- A100 / H100 / L40S (40GB以上)

- Wan 2.2 の 14B など「VRAM 20GB超」モデルを快適に動かすならこのクラス。

動画生成の時間感覚

長尺 → 15秒以上(高VRAM GPU必須、生成時間が現実的でなくなる場合も)

中尺 → 8〜12秒(挑戦レベル、設定調整や工夫が必要)

短尺 → 3〜5秒(試し撮りサイズ、安定して動作)

コスパで中尺を狙う → RTX 4090

安定性と余裕で中尺をやる → L40S (48GB)

本格的に長尺・高解像度も → A100 / H100 (40GB以上)

公式ブログ情報(Wan 2.1 1.3Bモデル)

- 480p 5秒で RTX 4090 使用時に 約4分。

- 14B モデルだとこの倍以上の時間がかかると見込まれる。

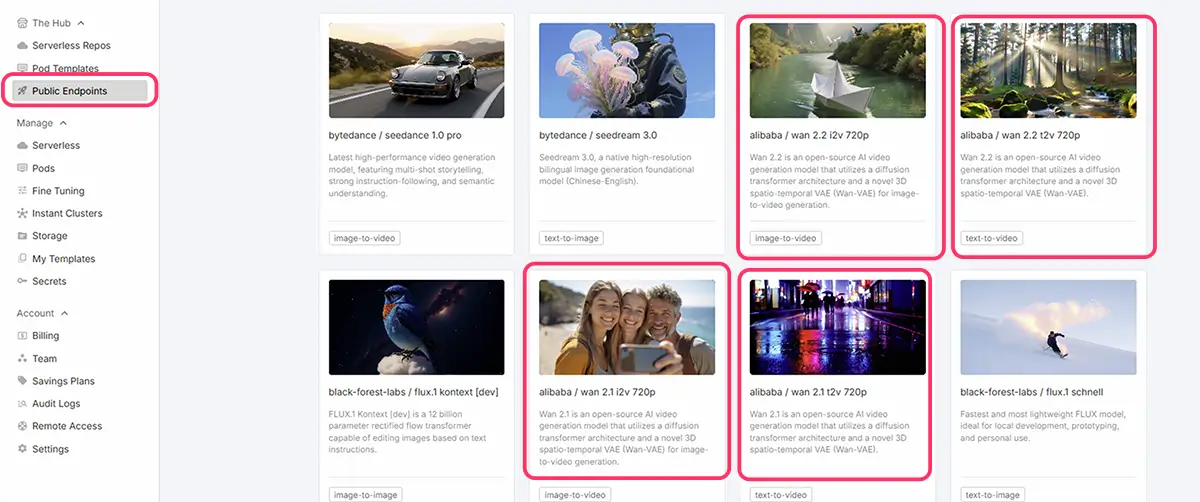

RunpodのPublic Endpointsで使用する方法

アカウントの作成などについてはこちらの記事をご覧ください【RunPodの使い方と料金】Stable Diffusionを使用して画像生成とLoRA学習をする方法【②実践編】

RunPod公式サイト |お友達紹介特典付きリンク

こちらのリンクからサインアップすると、 5~500ドルの1回限りのクレジットが付与され、初回入金時に10ドルが追加されます。

こちらのリンクからサインアップすると、 5~500ドルの1回限りのクレジットが付与され、初回入金時に10ドルが追加されます。

Runpod

Runpod | The cloud built for AI GPU cloud computing made simple. Build, train, and deploy AI faster. Pay only for what you use, billed by the millisecond.

Runpod公式ホームページのPublic EndpointsからWan 2.2 I2V 720p

未来

未来RunpodのPublic Endpointsは、好きなツールを選択するだけで、すぐに生成できる手軽さがおすすめポイントです。

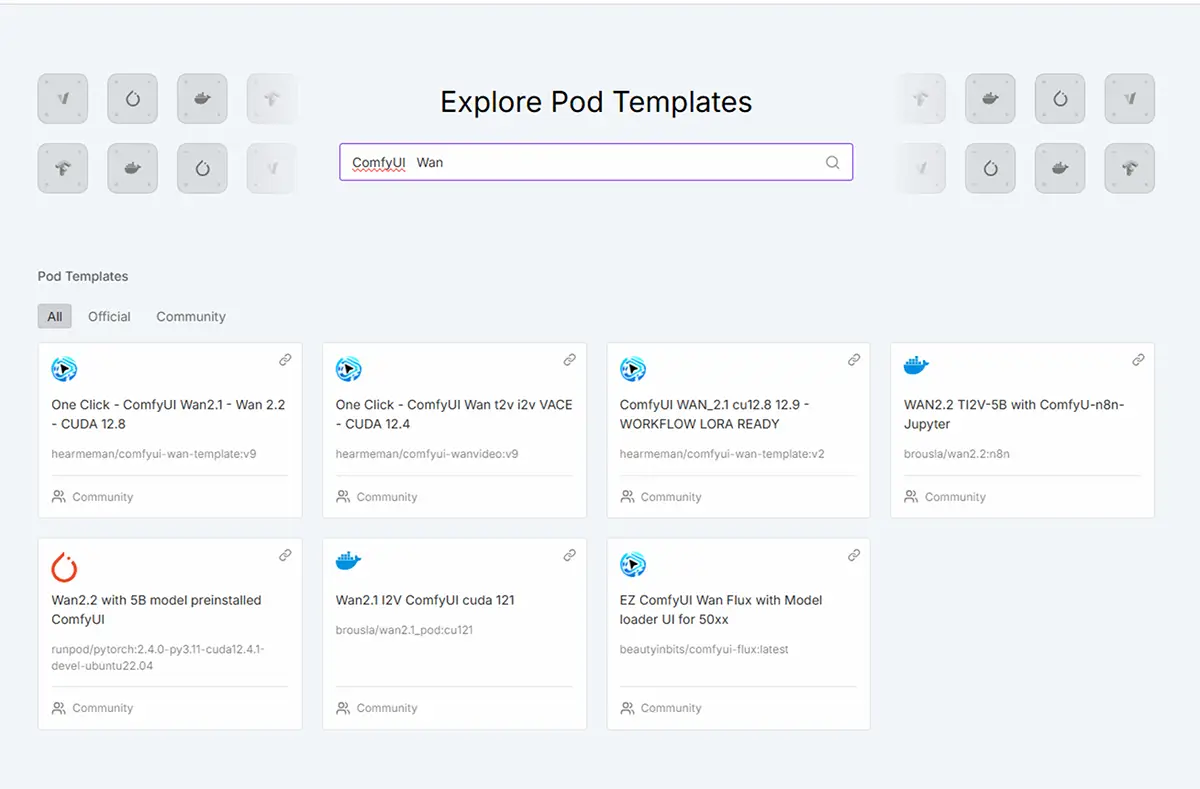

RunPodのテンプレート(ComfyUI + Wan + VACE)を使用する方法

アカウントの作成などについてはこちらの記事をご覧ください【RunPodの使い方と料金】Stable Diffusionを使用して画像生成とLoRA学習をする方法【②実践編】

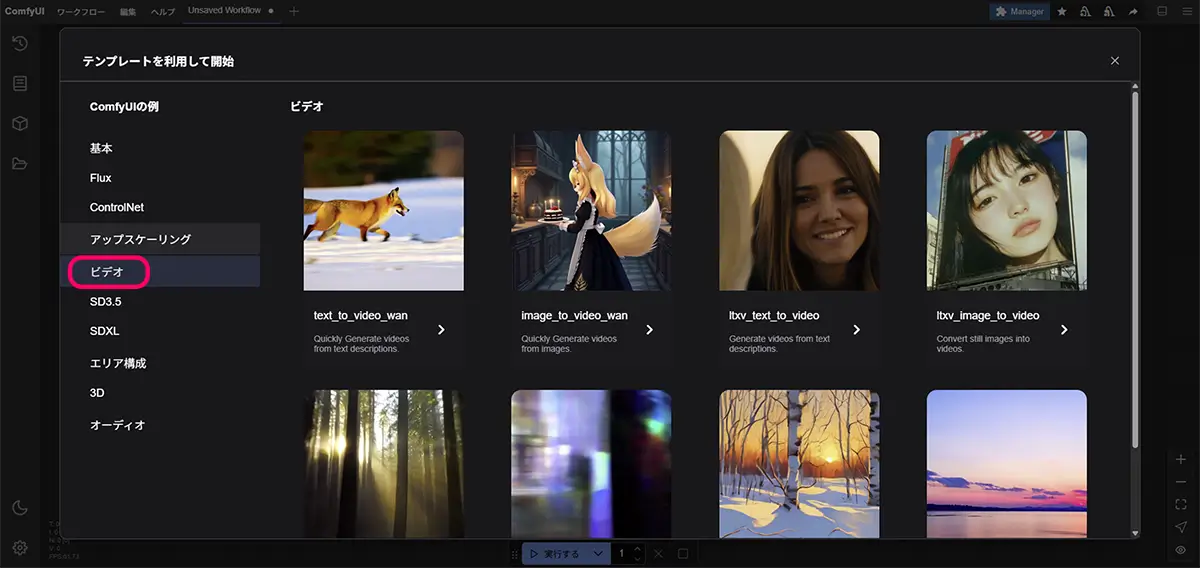

テキスト・画像・動画元素材から簡単に動画を生成できるセットアップです。現在では、どのComfyテンプレートも、Comfy画面を立ち上げるとノードのセットアップ選択が出来るようになっています。

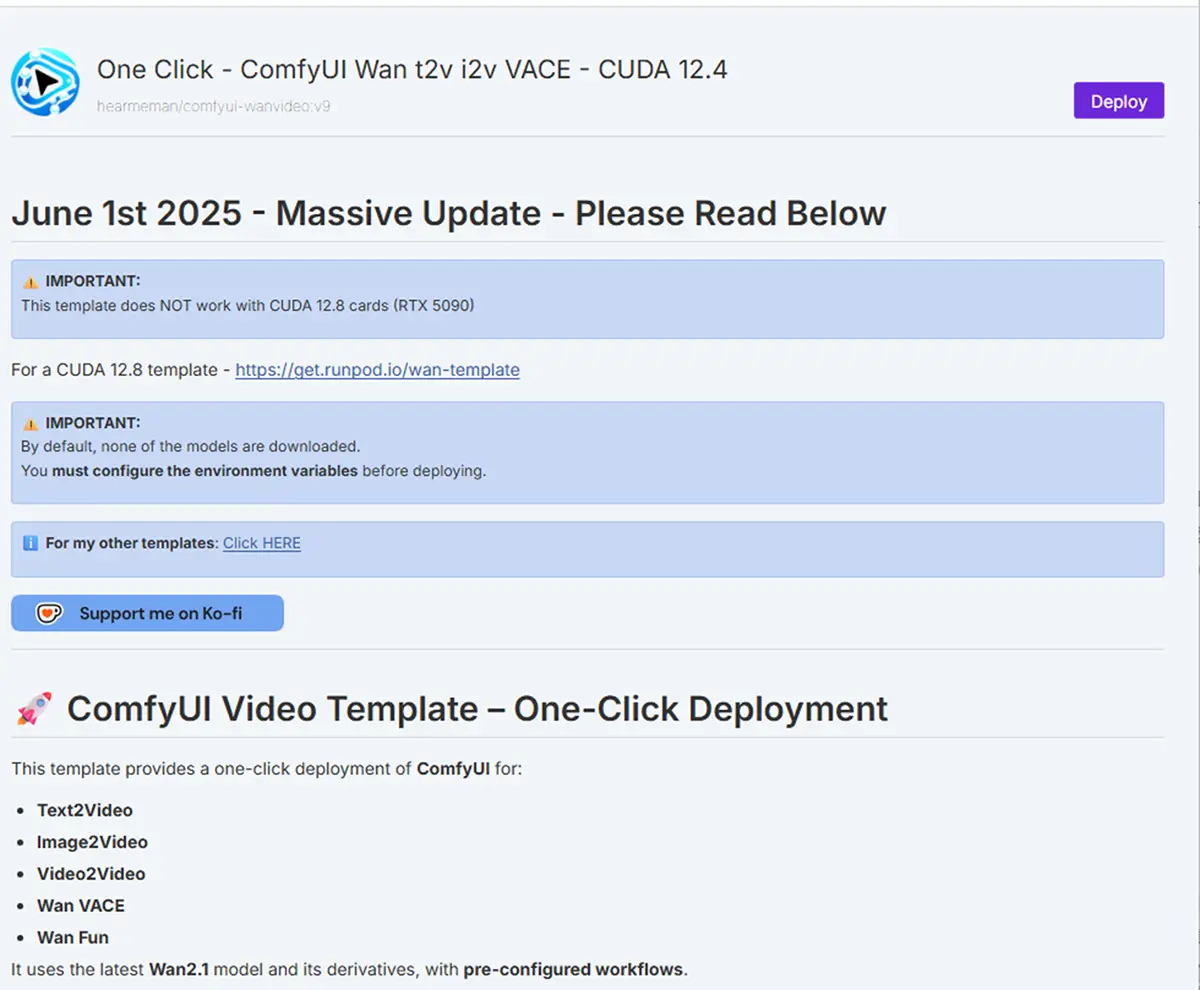

One Click – ComfyUI Wan t2v i2v VACE – CUDA 12.4

- このテンプレートは説明が丁寧なので、お勧めです。

モデルに関してもリンクが貼ってあります

こちらの記事内で紹介しているツールでもWANが使用できます。

ComfyUIでFLUXとSDXLを使う方法と認証モデルのダウンロード AI画像生成の世界で人気の、SDXL(Stable Diffusion XL)とFLUXが2大人気モデル。最近では、そこに、WANの動画生成のノードも組み込めるようになり(WANはクラウド限定…

テンプレートの内容

- ComfyUI ベースのインターフェースに、

- Wan Video(t2v:テキスト→動画、i2v:画像→動画、v2v:動画→動画)

- VACE(Alibabaの統合動画生成/編集モデル)

初期セットアップの手順

- RunPodでテンプレをデプロイ

- “One Click – ComfyUI Wan t2v i2v VACE” を選び、Podを起動。

- モデルをダウンロードする環境変数(例:

DOWNLOAD_MODELS=True)に変更する必要があります 。

- Podが起動&モデルロードされるまで待つ

- デプロイ後、Podのログで「モデルのダウンロード完了」「サービス Ready」のメッセージを確認します。

- ComfyUIのUIにアクセス

- Web ブラウザから指定URLにアクセスして、ComfyUIが表示される状態になっていればOK。

商用利用に適したモデル:Wan2.1 VACE 14B

- ライセンス:Apache License 2.0

- 商用利用:許可されています

- 特徴:

- 高解像度(最大720p)での動画生成が可能

- テキストから動画への変換(T2V)および画像から動画への変換(I2V)に対応

⚠️ 注意点

- モデルの選択:商用利用を検討する際は、使用するモデルのライセンスを必ず確認してください。

- コンテンツの内容:生成するコンテンツが他者の著作権を侵害しないよう注意が必要です。

- 商用利用の範囲:広告、プロモーション、商品紹介など、商用利用の具体的な範囲についても確認しておくことをおすすめします。

便利設定・Tips

- モデルのダウンロード設定:テンプレートデプロイ時に「環境変数でモデルをダウンロードするよう設定」してください。さもないと、実行時にエラーになります 。

- リアルタイムプレビューを有効に

- ComfyUIの VHS設定で Advanced Previews を “Always”、Preview method を “Auto” にすると、動画生成途中でもプレビューが表示され、失敗パラメータに気づきやすいです reddit.com。

i2v(画像→動画)の基本手順

- ComfyUI内で i2vワークフロー を選択。

- 「Load Image」ノードに、自分の絵のファイルを接続。

- フレーム数・解像度・プロンプトなどを設定。

- 実行ボタン(▶)を押すと、一定時間後に

ComfyUI/output/videoに mp4 が出力されます youtube.com+12docs.comfy.org+12reddit.com+12。

t2v(テキスト→動画)の基本

- プロンプトを「キャラが動いてる様子」など具体的に記述。

- フレーム数や解像度を指定。

- ▶を押せば動画が生成され、処理後は同じく

output/videoに保存されます 。

どのテンプレートを選んだ後も、ComfyUIの画面ではフローを編集できます。また、フロータブからいつでもテンプレートを変更できますので、気軽に選んでみまし

- 解像度変更

- フレーム数の増減

- 動きのスムーズさの調整(interp系)

もカスタマイズ可能です!

「Start image」「End image」がある場合の設定

| 項目名 | 意味 | 役割 |

|---|---|---|

| Start image | 開始フレーム(最初の画像) | 動画の1フレーム目をこの画像から生成 |

| End image | 終了フレーム(最後の画像) | 動画の最終フレームをこの画像に近づけるよう補間生成 |

この2枚を指定すると、AIがその間の動きを「補完」して動画を生成します。

- 例:

- Start image → 女性が前を向いている絵

- End image → 同じ人物が少し横を向いている絵

→ その間の動きを自然に繋いでくれるようなショート動画になります。

2つのCLIP Text Encode

ComfyUIフロー内に「CLIP Text Encode(Clipテキストエンコード)」ノードが 2つあります。

画像生成・動画生成系のAIでは、複数のプロンプト入力を使い分けるためにエンコードノードが複数使われます。

| 目的 | 説明 | ノードの役割 |

|---|---|---|

| ① 正規のプロンプト(positive prompt) | 「こうしてほしい」方向の指示 | 明るい・女性・水彩・幻想的など |

| ② ネガティブプロンプト(negative prompt) | 「こうならないでほしい」方向の指示 | ノイズ・崩れ・奇形・にじみ・extra limbs など |

例:

CLIP Text Encode(Positive) ← "a woman walking in the wind, smooth, cinematic"

CLIP Text Encode(Negative) ← "blurry, deformed, extra limbs, low quality"出力先で見分ける

- Encodeノードの出力先が

- 「Cond (条件)」や「Prompt Conditioning」に繋がっている → 正常

- どちらも「モデル条件」に統合されている → 正しい構成

最低限の手順(i2vで Start / End を使う)

- Start image を読み込む

- 自分の描いたイラストや写真などを設定

- End image を読み込む(任意)

- 変化させたい目標フレーム(同じキャラの別ポーズなど)

- プロンプトを入力する

- 例:

a girl turns her head slightly, gentle lighting, smooth motion"

- 例:

- 必要があればフレーム数・出力サイズの確認

- 例:16フレーム / 480p(初期値のままでもOK)

▶ 実行!

- プロンプトは「動きの方向性」を示す程度にする。

(例:「歩き出す」「振り返る」「風になびく」など) - StartとEndの絵が似すぎていると、あまり動かない。

→ ポーズや視線を少し変えてみる。 - 出力がカクつく場合は、「interpolation(補間)」のオプションを増やしてみる。

その他のオプション

| 項目名 | 意味 | 推奨値(初回) |

|---|---|---|

| Num Frames | 生成する動画の長さ(フレーム数) | 16〜24 |

| Resolution | 出力解像度 | 480p(初回は小さめでOK) |

| FPS | フレームレート | 6〜12(後から調整可) |