ローカルCLI(Pythonスクリプト)の為の【PyTorch+CUDA】のインストール手順

PyTorch + CUDA のインストール

目次

GPUとCUDAの互換性を確認する方法

PyTorch・Stable Diffusion・ComfyUI など、GPUを使うAIツールを動かすときは「GPUがCUDAに対応しているか」が最初のチェックポイントです。ここでは、互換性確認から環境構築までを解説します。

ステップ① 自分のGPUの型番を調べる

【Windowsの場合】

方法A:タスクマネージャーで確認

Ctrl + Shift + Escでタスクマネージャーを開く- 「パフォーマンス」タブ →「GPU」を選択

- 右上に「GeForce RTX 3060」などの型番が表示されます

方法B:コマンドで確認(より確実)

Windowsキー + R→「cmd」と入力 → Enter- 以下のコマンドを実行します

nvidia-smi例:

| GPU Name | CUDA Version: 12.2 |

| NVIDIA GeForce RTX 3060 | |「GPU Name」が使っているGPUの正式名称です。

「CUDA Version」はドライバが対応しているCUDAバージョンです

ステップ② 自分のGPUがCUDA対応かを確認する

以下のNVIDIA公式ページで、あなたのGPUがCUDA対応かどうか確認できます。

目安:GeForce GTX 750以降のほとんどのGPUはCUDA対応です。

ステップ③ 自分のGPUに適したCUDAバージョンを確認する

GPUごとに「Compute Capability」と呼ばれる世代があり、それに応じて使えるCUDAバージョンが変わります。

参考表(主なGPUと対応CUDA)

| GPU型番 | CUDA Compute Capability | 対応CUDAバージョン |

|---|---|---|

| GeForce GTX 1060 | 6.1 | CUDA 10.x~11.x |

| GeForce RTX 2060 | 7.5 | CUDA 10.x~12.x |

| GeForce RTX 3060 | 8.6 | CUDA 11.x~12.x |

| GeForce RTX 4070 | 8.9 | CUDA 12.x |

PyTorch + CUDA の導入

AIツールの多くは PyTorch ベースで動作しています。GPUを活かすためには「自分のCUDAバージョンに合ったPyTorch」を入れる必要があります。

最適なPyTorchの選び方

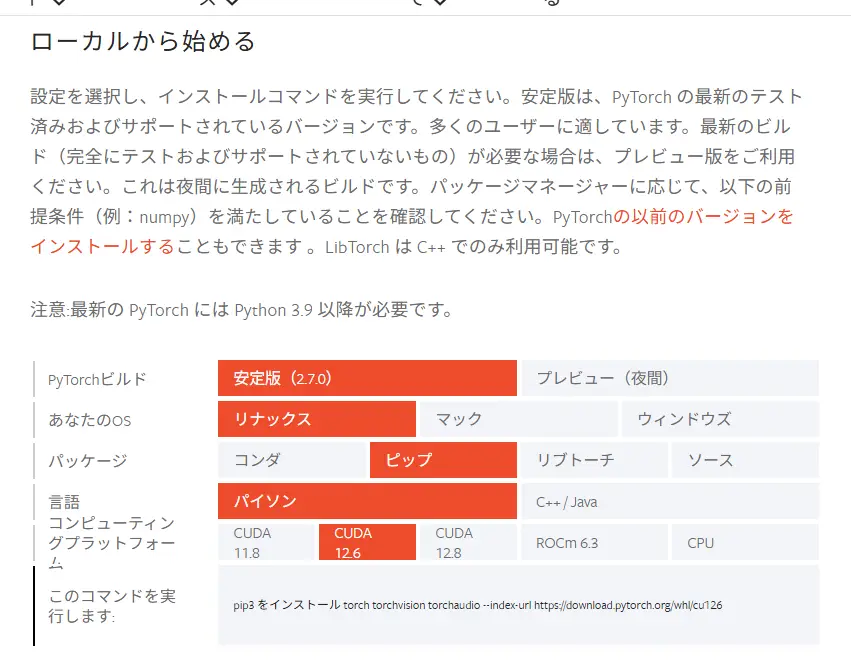

PyTorch公式サイトにある”ローカルから始めるのガイドが便利です。

画面の見方と操作手順

| 設定項目 | 説明 |

|---|---|

| PyTorch ビルド | 基本は「Stable(安定版)」を選べばOK |

| あなたの OS | Windows / Linux / macOS から選択 |

| パッケージ | Pythonユーザーは「pip」または「conda」 (pipが一番シンプル) |

| 言語 | Python を使っていればそのままでOK |

| コンピューティングプラットホーム | GPUあり→CUDAのバージョンを選択 GPUなし→「CPU」 を選ぶ |

上の表に沿って順に選んでいくと、環境に合ったインストールコマンドが自動で表示されます!

PyTorchとCUDAのバージョン対応表

| PyTorch | 対応するCUDAバージョン | pip install の末尾 |

|---|---|---|

| 2.1.x | 11.8 / 12.1 | cu118, cu121 |

| 2.0.x | 11.7 | cu117 |

| 1.13.x | 11.6 | cu116 |

例:Windows + pip + CUDA 11.8の場合

選択はこのようになります

- PyTorch Build:

Stable - Your OS:

Windows - Package:

pip - Language:

Python - Compute Platform:

CUDA 11.8

すると、下にこのようなコマンドが表示されます

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118このコマンドをコピーして、ターミナル(BashやPowerShell)に貼り付けて実行すれば完了です。(※ターミナル、コマンドプロンプトの起動方法はこちら)

cu118 は CUDA 11.8 を意味します

※ Windows のターミナルの起動方法…

Windows Terminal起動方法

- スタートメニューで、左クリック➡

ターミナルもしくは、「Windows Terminal」と検索して起動

※ デフォルトでは PowerShell または WindowsPowerShell)が開きます

画像生成用途の場合は、コマンドプロンプト(CMD)と相性が良いです。

pip install や conda などのモダン開発向けコマンドは、PowerShellと相性が良いです。

(※コマンドプロンプト(cmd)をWindows Terminal から開く為の設定方法はこちらの記事をご覧ください。)

Windows Terminalは、タブを切り替えて複数のシェルを使う事が出来ます

- 上部の

+ボタンから新しいタブを開けます

※Microsoft 公式も「Windows Terminal」を推奨

※ Mac のターミナルの起動方法…

ターミナル起動方法

- **「Command ⌘ + Space」を押して、「Spotlight検索」**を開く

- 検索バーに「ターミナル」と入力してEnter

または、以下の手順でも開けます:

アプリケーション → ユーティリティ → ターミナル

※ Linux のターミナルの起動方法…

Linuxターミナル起動方法

- 1,:

Ctrl + Alt + Tを同時に押す(多くのLinuxディストリビューションで共通) - 2,:アプリケーション一覧から「ターミナル」または「Terminal」で検索して開く

Ubuntu、Fedora、Debianなど、ほとんどのLinux環境に標準で搭載されています。

※ PowerShell の起動方法…(Windows)

PowerShell(パワーシェル)**は、Windowsに標準搭載されている、より高度な操作ができるコマンドラインツールです。見た目はコマンドプロンプトと似ていますが、より多機能で、プログラミング的な処理も得意です。

PowerShell起動方法

1,スタートメニューで「PowerShell」と検索してクリック

※ コマンドプロンプト(cmd)の起動方法…(Windows)

Windowsキー + Rを押す

「cmd」と入力してEnterを押す

または、スタートメニューで「コマンドプロンプト」と検索してもOK!

コマンドプロンプト(cmd)は、Windowsのターミナルからも開く事が出来ます

(※コマンドプロンプト(cmd)をWindows Terminal から開く為の設定方法はこちらの記事をご覧ください。)

参考:CUDAバージョン別コマンド

| CUDAバージョン | pipコマンド例 |

|---|---|

| 11.7 | --index-url https://download.pytorch.org/whl/cu117 |

| 11.8 | --index-url https://download.pytorch.org/whl/cu118 |

| CPUのみ | --index-url https://download.pytorch.org/whl/cpu |

インストール確認

Pythonで以下を実行してチェックします

import torch

print(torch.__version__)

print(torch.cuda.is_available()) # TrueならGPUを認識注意点

- PyTorchのバージョンとCUDAのバージョンは対応関係があります

- CUDA Toolkit が必要(

nvcc --versionで確認可能) - NVIDIAドライバは最新推奨

- 画像生成系ツールは CUDA 11.8 または 12.1 が最も安定

まとめ

nvidia-smiでGPU型番とCUDAバージョンを確認- NVIDIA公式でCUDA対応状況をチェック

- PyTorch公式サイトから自分に合ったインストールコマンドを取得

- Pythonで動作確認

これで「GPU + CUDA + PyTorch」の環境構築は完了です!

PyTorch + CUDA を使用する代表的なツール・アプリ

| ツール名 | 主な用途 | 特徴 |

|---|---|---|

| Stable Diffusion(AUTOMATIC1111など) | 画像生成(テキスト → 画像) | PyTorchベースの生成AI。CUDA対応で高速化 |

| ComfyUI | ノードベース画像生成 | PyTorch + CUDAが必要。リアルタイム性に優れる |

| Real-ESRGAN | 画像の高画質化(超解像) | GPU対応で数倍~数十倍高速に動作 |

| GFPGAN | 顔画像の修復・補完 | Real-ESRGANと連携可。PyTorch製 |

| CodeFormer | 顔修復AIの一種 | GFPGANの代替として人気。PyTorch製 |

| Waifu2x-Extension-GUI(PyTorch版) | アニメ画像高画質化・ノイズ除去 | PyTorchベースのGUI。CUDAで高速動作 |

| ESRGAN(本家版) | 超解像 | PyTorch + CUDAを使用。訓練やカスタムモデルに対応 |

| DreamBooth / LoRA訓練 | 画像生成モデルのファインチューニング | PyTorchで学習処理を行い、CUDAで高速化 |

| DeepFaceLab / FaceFusion | 顔の入れ替え・ディープフェイク | PyTorch + CUDAでリアルタイム化可能 |

| YOLOv5 / YOLOv8 | 物体検出 | PyTorch製の物体認識AI。GPU推論で高速動作 |

| Segment Anything(SAM) | 画像領域の自動分割 | Meta社のPyTorch製セグメンテーションモデル |

PyTorchのインストール

画像生成には「CUDA 11.8 or 12.1」が安定!

| CUDAバージョン | 安定性 | 対応ツール | コメント |

|---|---|---|---|

| 11.8 | ◎ 高い | 多くのツール対応 | 最も推奨される |

| 12.1 | ○ 良好 | 一部ツール対応 | 対応広がりつつある |

| 12.8 | △ 限定的 | 対応少ない | まだ不安定、要注意 |

🚫 現時点での制限

多くのAI画像生成ツール(Stable Diffusion、ComfyUI、InvokeAI、CodeFormerなど)は… CUDA 11.8 や CUDA 12.1 に最適化されています。

CUDA 11.8 、 CUDA 12.1以外の場合の対応策については、こちらをClick!

PyTorch が使う CUDA バージョンと、あなたの PC にインストールされている NVIDIA ドライバがその CUDA に対応していれば、CUDA Toolkit のインストールは基本的に不要です。

逆に、ドライバのバージョンが合っていない場合や、他のツールで CUDA をビルド・開発に使いたい場合には、CUDA Toolkit のインストールが必要になることがあります。

CUDA Toolkit とは、GPU 上での並列計算を行うために必要な以下のような要素をまとめた「開発者向けの総合セット」です

開発用ヘッダファイルやドキュメント

コンパイラ(nvcc)

ライブラリ(cuBLAS, cuDNNなど)

サンプルコードやデバッグツール

| 状況 | CUDA Toolkit必要? | 理由 |

|---|---|---|

| PyTorchやComfyUIを使いたい(pipでインストール) | ❌ 基本不要(PyTorchが内部で処理) | PyTorchのCUDAバージョンとドライバが合っていればOK |

| 自作のCUDAコードを書く・ビルドする | ✅ 必須 | nvccやヘッダが必要 |

| 特定のアプリが「Toolkit必須」と明記している | ✅ 必須 | 一部のツールでは依存あり |

| バージョン調整のため、古いCUDAを使いたい(このパターンの方に有効な手段です) | ✅ 推奨 | 複数バージョンの共存が可能になる |

方法①:CUDA Toolkitを ダウングレードして使う方法(推奨)

- 【おすすめ】CUDA 11.8 を別途インストールして、それに対応したPyTorchを使う方法。

- 環境が安定しやすく、多くのツールが対応済み。

CUDA 11.8 ダウンロード: NVIDIA CUDA 11.8 ダウンロードページ

注意:CUDAのバージョン ≠ GPUのドライバ

CUDA Toolkitのバージョンをインストールしても、GPUのドライバはそれに合わせる必要はありません。

→ この方法は、、PyTorch 側も CUDA 11.8 対応ビルドをインストールし、CUDA 11.8 Toolkitを手動で入れるパターンです。

手順まとめ(Windows / Linux 共通の考え方)

① CUDA 11.8 Toolkit のインストール

- NVIDIA公式サイトからダウンロード

https://developer.nvidia.com/cuda-11-8-0-download-archive - OSを選択し、インストール方法に従ってセットアップ

- インストール後、以下コマンドで確認

Windows

nvcc --versionLinux

nvcc --versionこれで release 11.8 と出ればOKです。

② PyTorch(CUDA 11.8対応ビルド)のインストール

PyTorch 公式のインストールページからコマンドを生成できます

https://pytorch.org/get-started/locally/

以下は一例(pip使用、Python 3.10環境の場合)

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118cu118 = CUDA 11.8対応ビルド

③ NVIDIAドライバの互換性を確認

PyTorch + CUDA 11.8を使うには、NVIDIAドライバがバージョン ≥ 512.0 である必要があります。

確認方法

Windows

nvidia-smiLinux

nvidia-smi出力の Driver Version をチェックしましょう。

使用確認(PyTorchがGPU + CUDA 11.8を使っているか)

import torch

print(torch.version.cuda) # → '11.8'

print(torch.cuda.is_available()) # → True(ならOK)

print(torch.cuda.get_device_name(0)) # GPU名表示補足:Toolkitが必要なケースとは?

- PyTorchをビルドする(=開発者向け)

- 他のC++/CUDAベースのAIツール(例:TensorRT、xformersなど)を自分でビルドする

nvccやlibcudartなどが必要なツールを使う

単純に PyTorch + GPU 推論だけなら、Toolkitなしでも PyTorch の cu118 ビルドで完結します。

方法②:CUDA 12.1 に対応するPyTorch「CUDAバージョン付きビルド」をインストールする方法

「CUDAバージョン付きビルド」とはPyTorch公式が「このバージョンのPyTorchは、このCUDAバージョンで動作するようにビルドされていますよ」と用意している事前ビルド済みパッケージのことです。「CUDAバージョン付きビルド」を使えば、Toolkitも不要

CUDA 12.1 にも対応できるなら、この方法もOKです。

※一部機能やツールとの互換性に注意が必要です。

PyTorch公式からインストールコマンドを選ぶ場合の設定(おすすめ)

| 項目 | 選択例 |

|---|---|

| PyTorch Build | Stable |

| OS | 環境に合わせて(例:Windows) |

| Package | pip |

| Language | Python |

| Compute Platform | CUDA 11.8(または CPU でもOK) |

生成されたコマンドの例

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118このように cu121(=CUDA 12.1)版を明示すれば、PyTorch内部で必要なランタイム「CUDAランタイム(*.dllなど)」が用意されるため、Toolkitインストールは不要で、CUDA Toolkitを別途インストールしなくても、PyTorch内部でCUDAが動くようになります。

注意点:ほかのソフトと共存する環境では、明示的にToolkitを使う方が安定することも。

方法③:WSL(Linux仮想環境)を使う ※Windowsユーザーの場合

Windows上でLinuxを“仮想環境”として動かせる機能”WSL(Windows Subsystem for Linux)は、「Windowsの中でLinuxが動く箱」を実際にLinuxをインストールせずに使うイメージです。

WSLとは?

WSLは「WindowsでLinux専用ツールを動かすための橋渡し」です。

| 項目 | 内容 |

|---|---|

| 正式名 | Windows Subsystem for Linux |

| 対応OS | Windows 10(Ver.2004以降)、Windows 11 |

| 何ができる? | UbuntuなどのLinux環境をWindows内で使える |

| どう便利? | Linux用のコマンドやツールがそのまま使える(しかも高速) |

WSLでできること(画像生成やAI用途向け)

- PythonやPyTorchをLinux環境で扱える

- UbuntuなどのLinuxディストリビューションをWindows上で起動できる

- 通常のLinuxコマンド(

pip,apt,git,pythonなど)が使える - GPU(NVIDIA製)を持っていれば、WSL + CUDA対応で高速処理も可能(WSL2 + GPU対応ドライバ必須)

- Gitなどの開発ツールをLinux用に使える

- CUDA対応のモデルも動かせる(WSL2 + GPU対応ドライバが必要)

- コンテナ(Docker)で環境管理しやすい ←画像生成系では便利!

WSLのざっくり構成イメージ

┌─────────────────────┐

│ Windows 11 │

│ ┌─────────────┐ │

│ │ WSL2 (Ubuntu) │ ← Linux環境(ここでAIモデル実行)

│ └─────────────┘ │

│ ↕ ファイル共有可 │

└─────────────────────┘

WSLを使うメリット

- LinuxのAIツールがそのまま使える

- Windowsに環境を汚さず構築できる

- 複数のLinux環境を切り替え可能

- GPU対応もOK(NVIDIAの専用ドライバで)

WSLの注意点

- 最初に少しセットアップが必要(でも1回やればOK)

- WSL2(最新版)+GPUドライバが必要(GPUを使うなら)

- Linuxコマンドに少し慣れると快適

WSL導入の流れ

- PowerShellを管理者権限で開く

wsl --install - 再起動 → Ubuntuなどを選択

- Linuxの初期設定(ユーザー名など)

- 必要なツールやAIライブラリをインストール(PyTorch、CUDAなど

ローカルCLIで使うための基本ステップ

- Python 環境 をインストール(3.9〜3.10など)

- CUDA対応のPyTorch をインストール(GPU使いたい場合)

git cloneでツールを取得(Gitでコードをダウンロード)pip install -r requirements.txtで依存ライブラリを一括インストール- コマンドラインで実行(例:

python inference_codeformer.py ...)

Anaconda(conda)でのインストールについて

本記事では pip版 のインストール方法を解説しましたが、

もしあなたが Anaconda(conda)環境 を利用している場合は、よりシンプルにインストールできます。

詳しくは以下の記事をご覧ください

🔗 [Anaconda(conda)でのPyTorch + CUDAインストール手順]

SAKASA AI

【初心者向け】自作LoRAの作り方|Kohya_ssで学習する方法|Anaconda + CUDA【Windows】 | SAKASA AI 初心者でも安心!Kohya_ssをWindows+Anaconda+CUDAで使えるようにする手順を画像付きで丁寧解説。LoRA学習モデルの作成から出力までをカバーしています。

PyTorch+CUDAのインストールをせずにDockerを使用する方法はコチラ

あわせて読みたい

【Dockerコンテナ徹底解説】~インストールからDocker対応AIツールまで Dockerコンテナとは? 通常、あるツールやアプリを動かすには「OSの設定・依存ライブラリ・Python・CUDAのバージョン」などを細かく合わせる必要があります。そして、そ…