Gemma 3のインストール手順をOllamaのインストールから~初心者にも分かりやすく”スクショ付き”~解説!

Gemma 3のインストール

目次

Gemma 3とは

Gemma 3は、Google DeepMindが2025年3月12日に発表した最新のオープンウェイト大規模言語モデル(LLM)です。これは、Gemmaファミリーの第3世代モデルで、以下の特徴を備えています

- マルチモーダル対応:テキスト、画像、短い動画の入力に対応し、テキスト出力を生成できます。

- 広範な言語サポート:140以上の言語に対応しています。

- 長いコンテキストウィンドウ:最大128,000トークンのコンテキストを処理可能です。

- 高性能:数学、推論、チャット能力、構造化出力、関数呼び出しなどの分野で性能が向上しています。

- モデルサイズのバリエーション:1B、4B、12B、27Bの4種類が提供されており、いずれも事前学習済みモデルと命令調整済みバージョンが利用可能です 。

Gemma3に関する詳細と活用例

ローカルLLMとは?Gemma 3で始めるAI活用ガイド Gemma 3で始めるAI活用 LLM(大規模言語モデル)の基礎知識 AIを使いたいけど、クラウドだとデータが心配な人、多いんじゃないかな…? ローカル環境でLLMを使う方法が知…

Gemma 3のインストール手順

Gemma 3をローカル環境で実行する為には、Ollamaというツールを使用するのが一般的です。

この記事では、Ollamaを使用してGemma 3をインストールする手順を解説します。

「Ollama」は、ローカル環境で大規模言語モデル(LLM)を簡単にダウンロード・実行できるツール(”実行マネージャー兼モデルランタイム”)で、複数のモデルに対応しています。

1,Ollamaのインストール(macOS/Windows/Linaxの場合)

先ず、Gemma 3をインストールする為のAIモデル実行エンジン”Ollama”をダウンロードします。

Ollamaは、Gemma 3を実行する際にGPUやCPUの最適な使い方を自動で選択し、ローリングバッファや推論最適化などの高速化技術を内部で処理してくれます。

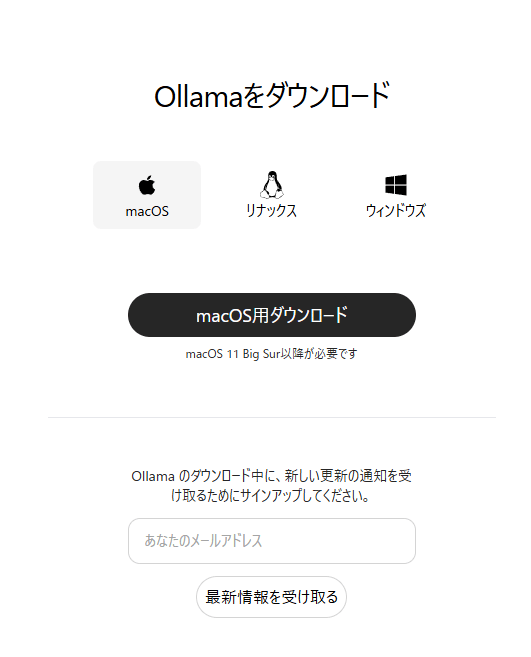

“Ollama公式ウェブサイト“から、自身のOSに対応したバージョンをダウンロードします。

”ダウンロード”をクリックすると、

下の選択画面に。自身のOSを選択して”ダウンロード”します。

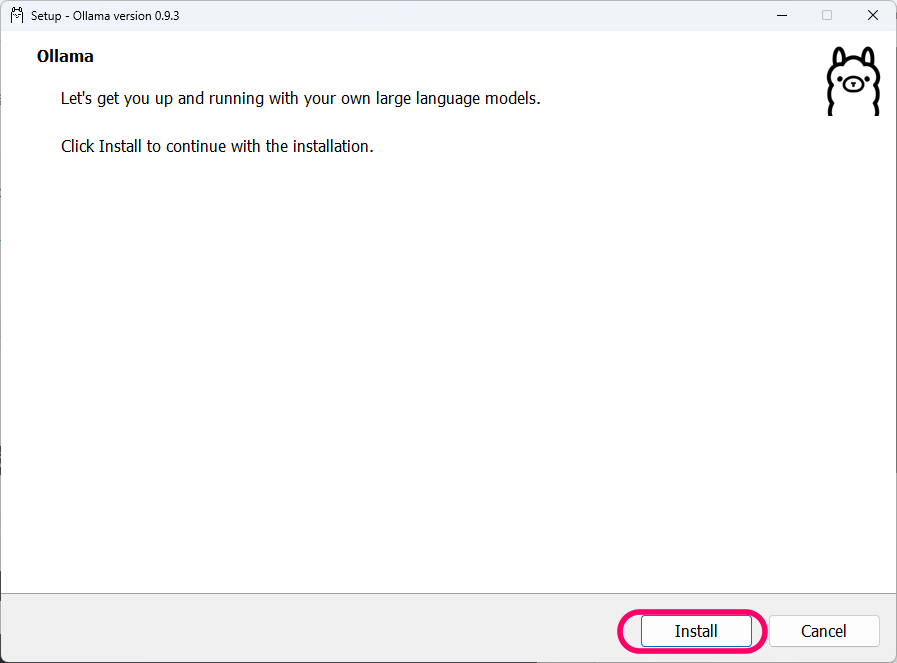

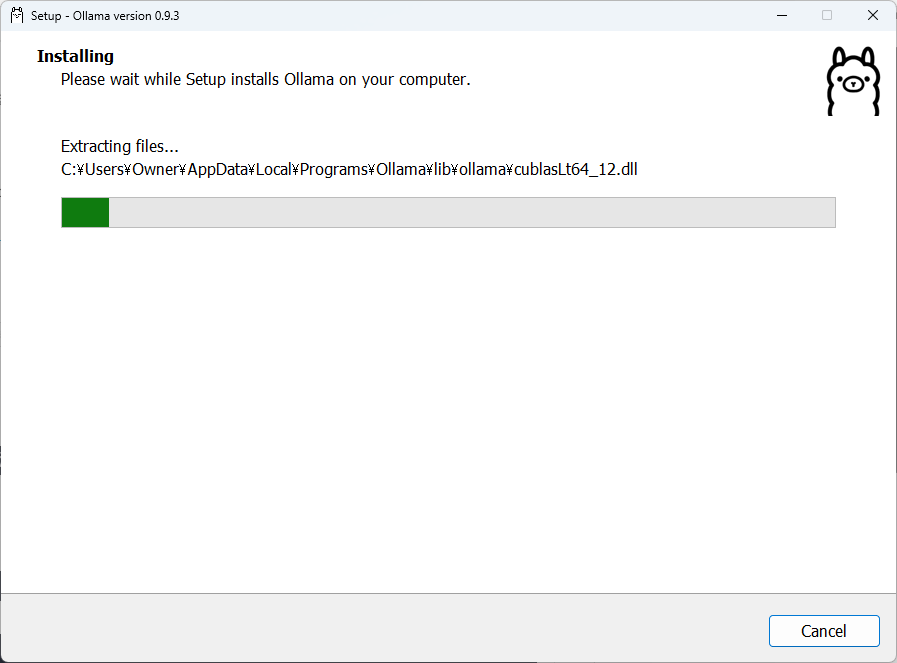

まずは、ダウンロードファイルをダブルクリックでインストールしましょう。

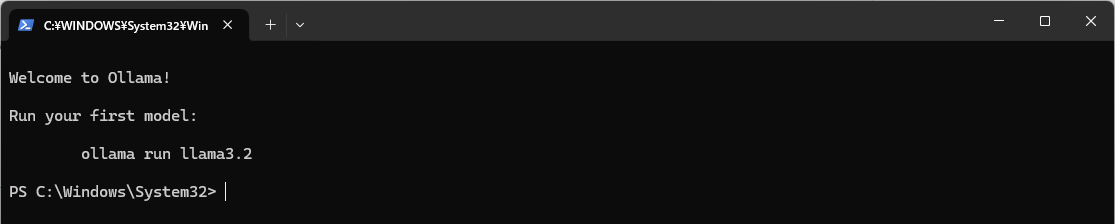

正常にインストールがされたか確認する方法

最近では、インストールが完了すると画面端にポップアップが出るようです。ポップアップが出たらクリックして開くようです。

※ポップアップが出なかった場合は、

ターミナル(コマンドプロンプト)を開き、”ollama”と打ち込むと呼ぶ出してくれます。

※ Windows のターミナルの起動方法…

Windows Terminal起動方法

- スタートメニューで、左クリック➡

ターミナルもしくは、「Windows Terminal」と検索して起動

※ デフォルトでは PowerShell または WindowsPowerShell)が開きます

画像生成用途の場合は、コマンドプロンプト(CMD)と相性が良いです。

pip install や conda などのモダン開発向けコマンドは、PowerShellと相性が良いです。

(※コマンドプロンプト(cmd)をWindows Terminal から開く為の設定方法はこちらの記事をご覧ください。)

Windows Terminalは、タブを切り替えて複数のシェルを使う事が出来ます

- 上部の

+ボタンから新しいタブを開けます

※Microsoft 公式も「Windows Terminal」を推奨

※ Mac のターミナルの起動方法…

ターミナル起動方法

- **「Command ⌘ + Space」を押して、「Spotlight検索」**を開く

- 検索バーに「ターミナル」と入力してEnter

または、以下の手順でも開けます:

アプリケーション → ユーティリティ → ターミナル

※ Linux のターミナルの起動方法…

Linuxターミナル起動方法

- 1,:

Ctrl + Alt + Tを同時に押す(多くのLinuxディストリビューションで共通) - 2,:アプリケーション一覧から「ターミナル」または「Terminal」で検索して開く

Ubuntu、Fedora、Debianなど、ほとんどのLinux環境に標準で搭載されています。

※ PowerShell の起動方法…(Windows)

PowerShell(パワーシェル)**は、Windowsに標準搭載されている、より高度な操作ができるコマンドラインツールです。見た目はコマンドプロンプトと似ていますが、より多機能で、プログラミング的な処理も得意です。

PowerShell起動方法

1,スタートメニューで「PowerShell」と検索してクリック

※ コマンドプロンプト(cmd)の起動方法…(Windows)

Windowsキー + Rを押す

「cmd」と入力してEnterを押す

または、スタートメニューで「コマンドプロンプト」と検索してもOK!

コマンドプロンプト(cmd)は、Windowsのターミナルからも開く事が出来ます

(※コマンドプロンプト(cmd)をWindows Terminal から開く為の設定方法はこちらの記事をご覧ください。)

余談ですが、上の表記、が出てきた際に、C:\Windows\System32\cmd.exe → 64bit版コマンドプロンプトC:\Windows\SysWOW64\cmd.exe → 32bit版コマンドプロンプト

どちらも見た目は似ていますが、内部で動作できるプログラムやDLLに違いがあります。

64bitのPCで、System32と表示されると「あれ?」となりますが、大丈夫です。安心してください。

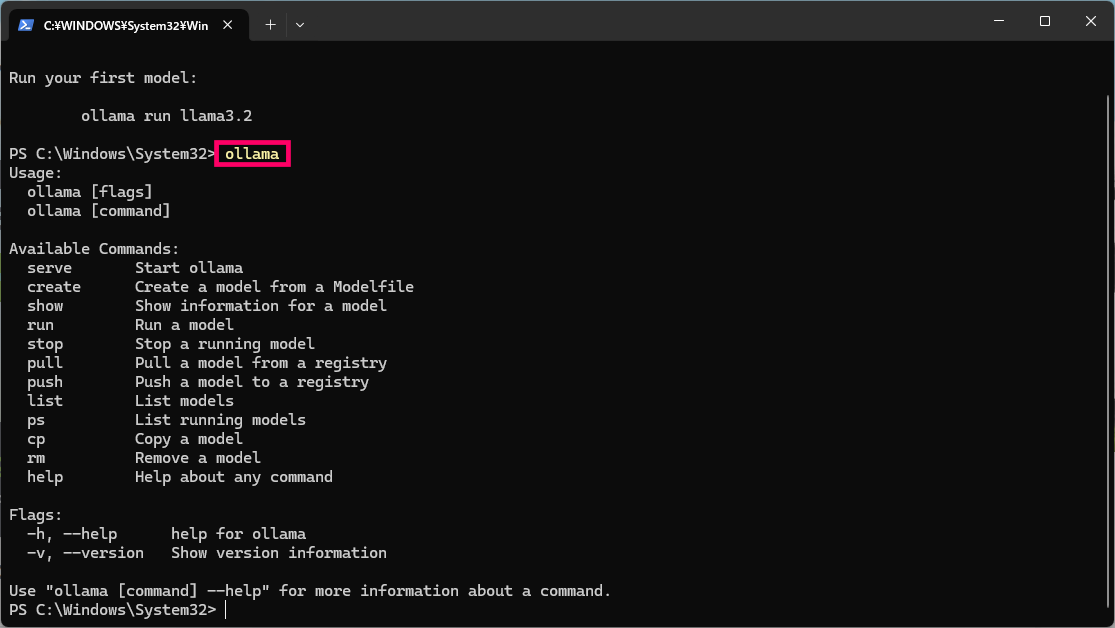

ollamaと打つと、各種コマンドが表示されます。

困ったときは、ollamaと、打ちましょう。(笑)

| serve | Start ollama | ollamaを起動します |

| create | Create a model from a Modelfile | モデルファイルからモデルを作成します |

| show | Show information for a model | モデルの情報を表示します |

| run | Run a model | モデルを実行します |

| stop | Stop a running model | 実行中のモデルを停止します |

| pull | Pull a model from a registry | レジストリからモデルを取得します |

| push | Push a model to a registry | モデルをレジストリにプッシュします |

| list | List models | モデルを一覧表示します |

| ps | List running models | 実行中のモデルを一覧表示します |

| cp | Copy a model | モデルをコピーします |

| rm | Remove a model | モデルを削除します |

| help | Help about any command | コマンドのヘルプを表示します |

| Flags:フラグ | ||

| -h, | –help help for ollama | –help ollamaのヘルプを表示します |

| -v, | –version Show version information | –version バージョン情報を表示します |

2,Gemma 3モデルのダウンロード

そして本題の、Gemma 3のダウンロードですが

ハードウェア要件

Gemma 3の各モデルを実行するための推奨ハードウェア要件は以下の通りです。

- 27Bモデル: 48GBのGPUメモリ

- 12Bモデル: 24GBのGPUメモリ

- 4Bモデル: 8GBのGPUメモリ

- 1Bモデル: 2GBのGPUメモリ

これらの要件を満たすハードウェア環境を用意することで、Gemma 3を効果的に活用できます。

詳細はGemma3の公式ホームページで確認してください。

GPUスペックについてはこちら

【2026年】AI画像生成に最適なGPU比較:RTX4060~5090【SD/LoRA/ControlNet対応】 画像生成AIを使いたい!GPUは何を選べばいい? Stable DiffusionやComfyUIで画像生成に挑戦したい――そう思ったとき、最初に立ちはだかる壁が「GPU選び」ではないでしょ…

Ollamaを使用して、必要なサイズのGemma 3モデルをダウンロードします。

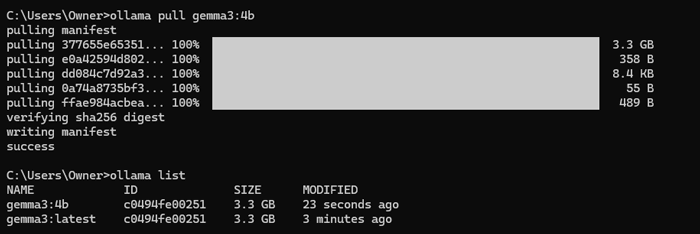

ターミナル(コマンドプロンプト)で、以下のコマンドを入力すると、

Gemma 3モデルがローカル環境にダウンロードされます。

(※以下の画像一段目、c:\Users\Owner>の所に、下の何れかのコマンドを入力してください。

どのモデルを選択するかは、上のハードウェア要件を参考にして下さい。)

- 27Bモデルの場合

ollama pull gemma3 - 12Bモデルの場合

ollama pull gemma3:12b - 4Bモデルの場合

ollama pull gemma3:4b - 1Bモデルの場合

ollama pull gemma3:1b

このコマンドにより、Gemma 3モデルがダウンロードされます。

リスト(上の画像の下から4段目c:\Users\Owner>ollama list)にgemma3(または選択したモデル)が表示されていれば、インストールは成功しています。

ここでは、(上の画像の下から2段目)gemma3:4と出ていますね。

※出てこない場合は、c:\Users\Owner>の後に、ollama listと、入力してリストを呼び出してください。

カスタムモデルの作成(オプション):特定の用途に合わせてモデルをカスタマイズしたい場合は、Modelfileを作成し、以下のコマンドでカスタムモデルを作成できます。

ollama create gemma3-custom -f Modelfile

ollama run gemma3-customModelfileの内容例:

FROM gemma:3

PARAMETER context_length=128000これにより、最大コンテキスト長を128,000トークンに設定したカスタムモデルを作成できます。

参考資料

- Introducing Gemma 3: The Developer Guide

- Gemma 3 model overview | Google AI for Developers

- Gemma 3 on mobile and web with Google AI Edge

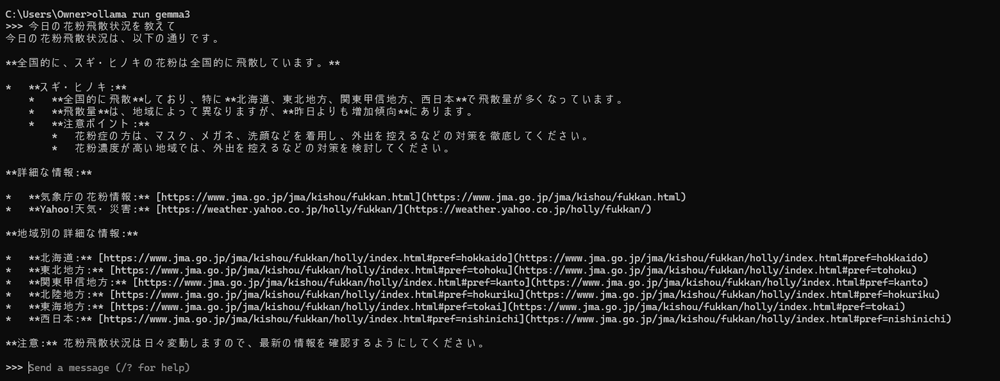

実際使ってみよう!

ダウンロードが完了したら、以下のコマンドでGemma 3を実行できます。

c:\Users\Owner>の後に、以下を入力してください。

ollama run gemma3

これにより、Gemma 3との対話が可能になります。

SAKASA

SAKASA今日は花粉症が辛かったので、花粉飛散状況を聞いてみました。

未来

未来ローカルで会話できるよ!

簡単なので使ってみてね。